Omawiamy ważne fakty dla debaty publicznej, a także przedstawiamy istotne raporty i badania.

AI Act – czym jest unijny akt o sztucznej inteligencji?

W Unii Europejskiej trwają prace nad aktem o sztucznej inteligencji – AI Act. Prawdopodobnie wejdzie on w życie w połowie przyszłego roku. Przepisy mają nas chronić m.in. przed wykorzystaniem sztucznej inteligencji do nadzoru biometrycznego czy rozpoznawania emocji. To pierwsza tak kompleksowa regulacja dotycząca zagadnienia AI. Co w niej znajdziemy?

Fot. tungnguyen0905 / Pixabay / Modyfikacje: Demagog

AI Act – czym jest unijny akt o sztucznej inteligencji?

W Unii Europejskiej trwają prace nad aktem o sztucznej inteligencji – AI Act. Prawdopodobnie wejdzie on w życie w połowie przyszłego roku. Przepisy mają nas chronić m.in. przed wykorzystaniem sztucznej inteligencji do nadzoru biometrycznego czy rozpoznawania emocji. To pierwsza tak kompleksowa regulacja dotycząca zagadnienia AI. Co w niej znajdziemy?

W ostatnim czasie Parlament Europejski (PE) przyjął znaczną większością głosów stanowisko negocjacyjne w sprawie aktu o sztucznej inteligencji (AI Act). Dalej nad ustawą europosłowie będą pracować razem z Radą UE i Komisją Europejską.

Jak czytamy na stronie PE: „Sztuczna inteligencja może przynieść wiele korzyści – np. lepszą opiekę zdrowotną, bezpieczniejszy i czystszy transport, bardziej wydajną produkcję oraz tańszą i bardziej zrównoważoną energię”.

Warto podkreślić, że akt o sztucznej inteligencji ma szansę zostać pierwszym tego typu dokumentem na świecie. Oznacza to, że może się on przyczynić do wypracowania światowych standardów w zakresie praw dotyczących AI.

Ramy bezpiecznej i odpowiedzialnej sztucznej inteligencji

Komisja Europejska zaproponowała stworzenie AI Act – regulację mającą stworzyć ramy prawne dla rozwoju i wykorzystania sztucznej inteligencji (AI) w Unii Europejskiej.

Głównymi celami polityki dotyczącej AI są: stworzenie warunków sprzyjających rozwojowi i wykorzystaniu sztucznej inteligencji, budowanie strategicznego przywództwa w sektorach o dużym znaczeniu, sprawienie, aby UE była miejscem szybkiego rozwoju sztucznej inteligencji, oraz dbanie o to, aby technologia AI służyła ludziom.

Czym różnią się poszczególne poziomy ryzyka?

Akt o sztucznej inteligencji ma rozróżniać trzy poziomy ryzyka zastosowania sztucznej inteligencji: niedopuszczalne ryzyko, wysokie ryzyko i ograniczone lub minimalne ryzyko.

Niedopuszczalne ryzyko

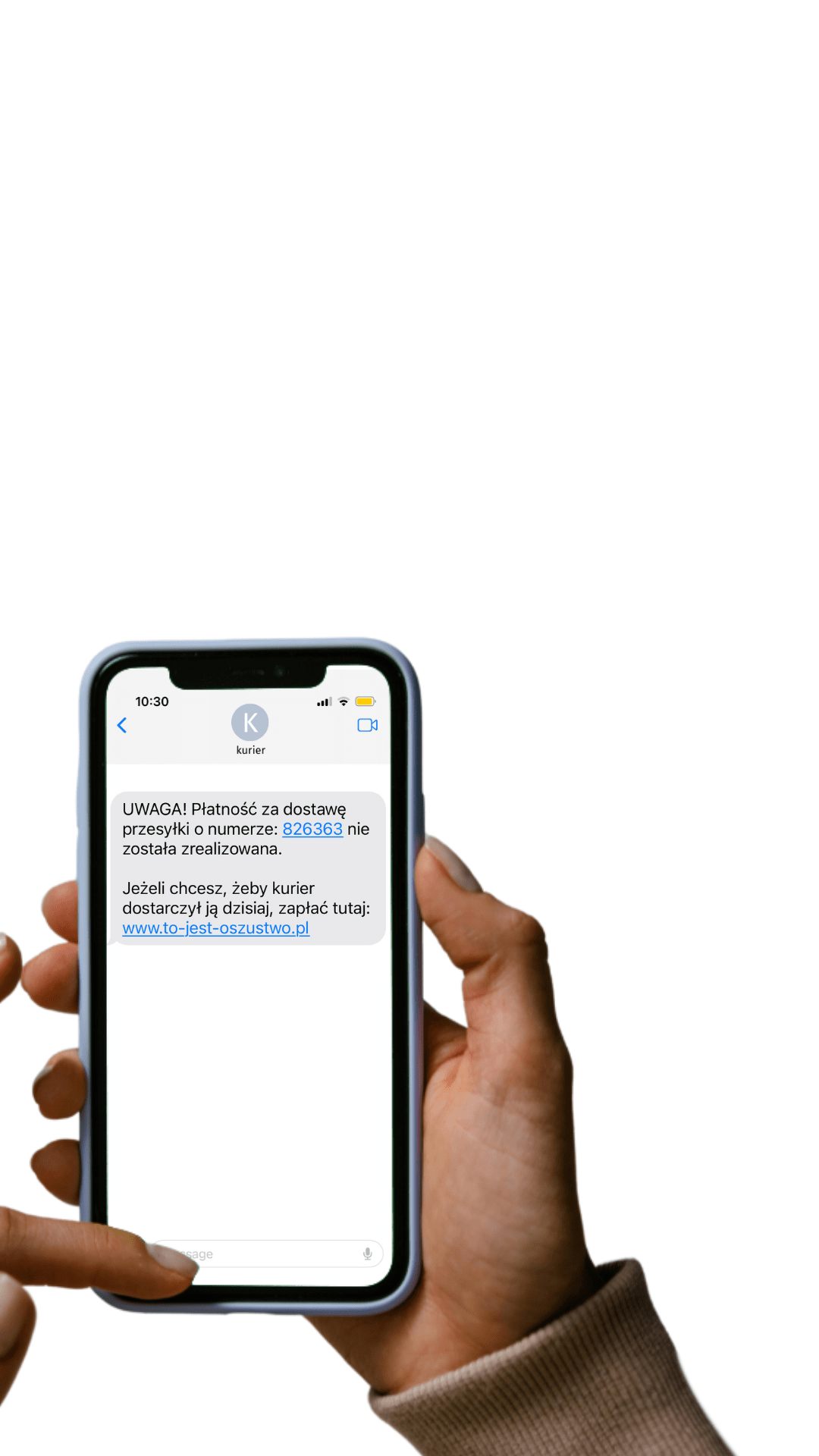

Aplikacje AI, które stanowią poważne zagrożenie dla bezpieczeństwa ludzi, praw podstawowych lub demokracji, zostałyby zakazane. Przykłady aplikacji o niedopuszczalnym ryzyku obejmują systemy sztucznej inteligencji zaprojektowane do manipulowania ludźmi, a także wykorzystywane do oceny punktowej (czyli klasyfikacji ludzi np. na podstawie zachowań, statusu społeczno-ekonomicznego czy cech osobistych).

Jakie konkretnie rozwiązania zostaną zabronione? Przykładowo: biometryczna identyfikacja osób w miejscach publicznych (wyjątek mogą stanowić sytuacje, w których zezwoli na nią sąd), biometryczna kategoryzacja ze względu na cechy indywidualne i grupowe, predykcja kryminalna, a także rozpoznawanie emocji.

Wysokie ryzyko

Klasyfikacja aplikacji wysokiego ryzyka ma obejmować systemy sztucznej inteligencji, które mogą stanowić znaczną szkodę dla zdrowia, bezpieczeństwa, praw podstawowych lub środowiska.

Do listy zostały też dodane systemy AI używane przez platformy mediów społecznościowych z ponad 45 mln użytkowników, stosowane do wpływania na wyborców i wyniki wyborów.

Systemy wysokiego ryzyka nie zostaną zakazane. W zamian za to będą oceniane przed wprowadzeniem na rynek, a także przez cały cykl swojego życia.

Ograniczone lub minimalne ryzyko

Zastosowania sztucznej inteligencji, które nie stanowią znaczącego zagrożenia dla bezpieczeństwa ludzi, praw podstawowych lub demokracji, nie podlegałyby w dużej mierze regulacjom ustawy o sztucznej inteligencji.

Przykłady zastosowań o ograniczonym ryzyku obejmują systemy sztucznej inteligencji wykorzystywane do celów marketingowych lub obsługi klienta.

Natomiast swobodne korzystanie z gier wideo wykorzystujących sztuczną inteligencję lub filtrów spamu zostało zaliczone do minimalnego ryzyka.

Zdecydowana większość systemów sztucznej inteligencji należy do kategorii minimalnego ryzyka. Nowe przepisy nie mają na tę kategorię wpływu. Systemy z tej grupy charakteryzują się minimalnym, a nawet zerowym zagrożeniem dla praw i bezpieczeństwa obywateli.

Akt o sztucznej inteligencji: przełomowy akt prawny

Fundacja Panoptykon po głosowaniu w PE wskazała szereg pozytywnych rozwiązań, które znajdują się w akcie. Wymienia wśród nich:

- lepszą ochronę osób dotkniętych decyzjami systemów AI – umożliwienie wnoszenia skargi do odpowiedniego organu na poziomie krajowym,

- zakaz najbardziej ryzykownych zastosowań AI – jak ocenianie ryzyka, czy dana osoba popełni przestępstwo,

- zwiększenie kontroli nad systemami AI wysokiego ryzyka,

- precyzyjność i odporność definicji AI na zmiany technologiczne,

- a także parę innych rozwiązań chroniących obywateli.

Fundacja Panoptykon zwraca jednak uwagę, że w AI Act jest jeszcze przestrzeń na wzmocnienie ochrony obywateli przed zagrożeniami związanymi ze sztuczną inteligencją. Organizacja wymienia następujące rozwiązania, których brakuje w regulacji:

- większe zaangażowanie organizacji społecznych w ochronę ludzi,

- prawo do każdorazowego wyjaśnienia decyzji podjętej przy pomocy AI,

- całkowity zakaz inwigilacji biometrycznej w czasie rzeczywistym w przestrzeni publicznej,

- obowiązek rejestrowania wszystkich systemów wysokiego ryzyka w unijnej bazie.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter