Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

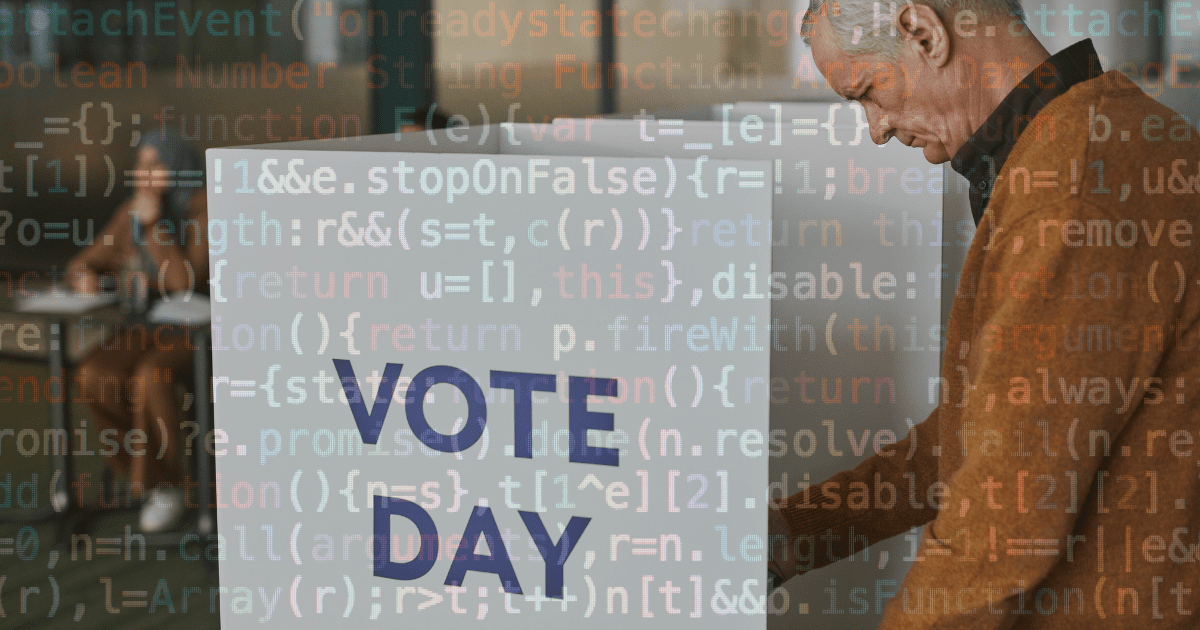

Deepfake i sztuczna inteligencja – zagrożenia dla wyborów 2024

W 2024 roku w wielu krajach odbędą się wybory. Do głosowania może przystąpić połowa światowej populacji. Okres kampanii wyborczych sprzyja powstawaniu dezinformujących treści na temat wyborów, a także tworzeniu deepfake’ów z udziałem kandydatów lub innych polityków.

16 lutego 2024 roku dwadzieścia największych firm technologicznych zawarło „Porozumienie technologiczne w sprawie zwalczania oszukańczego wykorzystania sztucznej inteligencji w wyborach w 2024 roku”. Celem tej współpracy jest zapobieganie rozpowszechnianiu fałszywych przekazów, zdjęć i filmów tworzonych przy użyciu sztucznej inteligencji (AI) podczas wyborów na całym świecie.

fot. Pexels / Modyfikacje: Demagog

Deepfake i sztuczna inteligencja – zagrożenia dla wyborów 2024

W 2024 roku w wielu krajach odbędą się wybory. Do głosowania może przystąpić połowa światowej populacji. Okres kampanii wyborczych sprzyja powstawaniu dezinformujących treści na temat wyborów, a także tworzeniu deepfake’ów z udziałem kandydatów lub innych polityków.

16 lutego 2024 roku dwadzieścia największych firm technologicznych zawarło „Porozumienie technologiczne w sprawie zwalczania oszukańczego wykorzystania sztucznej inteligencji w wyborach w 2024 roku”. Celem tej współpracy jest zapobieganie rozpowszechnianiu fałszywych przekazów, zdjęć i filmów tworzonych przy użyciu sztucznej inteligencji (AI) podczas wyborów na całym świecie.

Czego dotyczyła Konferencja Bezpieczeństwa w Monachium?

W dniach 16–18 lutego 2024 roku w Monachium odbyła się Konferencja Bezpieczeństwa, której głównym celem było omówienie najpilniejszych wyzwań związanych z bezpieczeństwem na świecie.

Podczas Konferencji firmy takie jak Adobe, Amazon, Anthropic, ARM, ElevenLabs, Google, IBM, Inflection AI, LinkedIn, McAfee, Meta, Microsoft, Nota, OpenAI, Snap, Stability AI, TikTok, TrendMicro, TruePic i X zobowiązały się podjąć działania w celu rozpoznawania i usuwania dezinformujących treści w internecie generowanych przez sztuczną inteligencję. Na stronie jednego z sygnatariuszy – Microsoftu – czytamy: „Cel jest prosty, ale kluczowy – zwalczanie materiałów wideo i audio oraz obrazów fałszujących lub zmieniających wygląd, głos lub działania kandydatów politycznych, urzędników wyborczych i innych kluczowych interesariuszy”.

Światowe Forum Ekonomiczne w raporcie Global Risks Report 2024 uznało dezinformację oraz misinformację za największe, globalne zagrożenie na 2024 rok, które może doprowadzić do zakłócenia przebiegu wyborów na świecie.

Osiem zobowiązań głównych firm technologicznych

Porozumienie technologiczne zawarte przez dwadzieścia przewodnich firm przedstawia osiem najważniejszych zasad, których te przedsiębiorstwa zobowiązały się przestrzegać w celu eliminowania dezinformujących treści w kontekście wyborów 2024.

Te osiem zasad to:

- Tworzenie i wprowadzanie technologii, a także narzędzi typu open source, w celu „ograniczenia ryzyka związanego z treściami wyborczymi zawierającymi zwodniczą sztuczną inteligencję”.

- Analizowanie obecnych modeli AI pod kątem potencjalnego ryzyka oszustwa, które mogą powodować, uwzględniając fałszywe treści wyborcze tworzone przez sztuczną inteligencję.

- Identyfikowanie rozpowszechniania nieprawdziwych i manipulujących przekazów na platformach.

- Odpowiednie reagowanie na niebezpieczne treści znalezione na platformach.

- Budowanie odporności międzybranżowej na dezinformację wyborczą wykorzystującą sztuczną inteligencję.

- Informowanie społeczeństwa, w jaki sposób dana firma będzie postępować z fałszywymi treściami.

- Dalsza współpraca ze światowymi organizacjami społeczeństwa obywatelskiego i ze środowiskiem akademickim.

- Uświadamianie społeczeństw na temat zagrożeń związanych z wykorzystaniem sztucznej inteligencji do tworzenia manipulujących treści. Zwiększanie „odporności całego społeczeństwa” i umiejętności korzystania z mediów.

Kent Walker, prezes ds. spraw globalnych w Google, podczas Konferencji powiedział:

„Demokracja opiera się na bezpiecznych wyborach. Google od lat wspiera integralność wyborów, a dzisiejsze porozumienie odzwierciedla zaangażowanie branży w walkę z dezinformacją wyborczą generowaną przez sztuczną inteligencję, która podważa zaufanie”.

Wpływ sztucznej inteligencji na przebieg wyborów

Głównym przykładem dezinformacji wyborczej, zawartym w porozumieniu technologicznym, są tzw. deepfake’i. To fałszywe obrazy, filmy i dźwięki tworzone za pomocą sztucznej inteligencji. Zazwyczaj pokazują sytuacje z udziałem celebrytów i polityków, które w rzeczywistości się nie wydarzyły.

Zmanipulowane nagrania błędnie przedstawiają takie osoby. Jak czytamy na stronie Konferencji Bezpieczeństwa, porozumienie obejmuje przede wszystkim treści powstałe dzięki sztucznej inteligencji, takie jak: „materiały audio i wideo oraz obrazy, które fałszują lub zmieniają wygląd, głos lub działania kandydatów politycznych, urzędników wyborczych i innych kluczowych interesariuszy w demokratycznych wyborach”.

Dezinformacja związana z wyborami pojawiła się już m.in. w USA czy na Słowacji. W styczniu 2024 roku, przed prawyborami w New Hampshire, do wyborców w tym stanie wysłano automatyczne połączenie telefoniczne stworzone dzięki sztucznej inteligencji. Fałszywe nagranie naśladowało głos prezydenta Joe Bidena, który rzekomo miał zniechęcać ludzi do oddania głosu w prawyborach. Podobna sytuacja miała miejsce na Słowacji. Przed wyborami pojawiło się nagranie dźwiękowe wygenerowane przy pomocy sztucznej inteligencji, w którym wykorzystano głos Michala Šimečki, przewodniczącego konkurencyjnego ugrupowania.

Jak najważniejsze platformy planują przeciwdziałać fałszywym treściom, które powstają dzięki sztucznej inteligencji?

- Meta

Media społecznościowe sprzyjają szybkiemu rozpowszechnianiu się fałszywych przekazów. Zgodnie z zawartym porozumieniem właściciele tych platform powinni szczególnie przeciwdziałać deepfake’om i nieprawdziwym komunikatom na temat wyborów, które pojawiają się na ich portalach. W treści wspomnianego porozumienia czytamy, że firmy mają współpracować w celu: „wykrywania i reagowania na dystrybucję online takich treści AI, prowadzenia kampanii edukacyjnych i zapewniania przejrzystości”.

Na stronie Mety znajdziemy informacje o tym, że firma w najbliższych miesiącach planuje „oznaczać zdjęcia publikowane przez użytkowników na Facebooku, na Instagramie i w Threads”, jeśli rozpozna, że zostały stworzone przez sztuczną inteligencję. Meta będzie znakować zarówno treści powstałe dzięki użyciu ich funkcji – Meta AI, jak i te wygenerowane za pomocą narzędzi innych firm. Na obrazie zrobionym przez Meta AI znajdzie się etykieta „Imagined with AI” oraz niewidzialny znak wodny. Obecnie ta funkcja jeszcze nie działa.

W okresie przed wyborami do Parlamentu Europejskiego firma Meta planuje także otworzyć Centrum Operacji Wyborczych. Eksperci będą rozpoznawać niebezpieczne treści wygenerowane przy użyciu sztucznej inteligencji i wprowadzać „określone środki zaradcze w aplikacjach i w technologiach w czasie rzeczywistym”.

- TikTok

w marcu 2024 roku TikTok planuje otworzyć w swojej aplikacji „Centrum Wyborcze w języku lokalnym dla każdego z 27 państw członkowskich UE, aby umożliwić obywatelom łatwe oddzielenie faktów od fikcji”. Użytkownicy internetu będą mogli znaleźć tam wiarygodne informacje na temat wyborów. Firma przedstawiła także inne działania podejmowane w celu zapobiegania dezinformacji wyborczej. Są to m.in.:

- praca wyspecjalizowanych moderatorów, którzy wykrywają i usuwają takie treści,

- współpraca z organizacjami weryfikującymi fakty,

- kampanie edukacyjne na temat tego, jak korzystać z mediów,

- wymóg oznaczania przez twórców treści wygenerowanych przez sztuczną inteligencję,

- wykrywanie przez ekspertów zwodniczych treści i zachowań, zanim się one pojawią.

Użytkownicy TikToka mają obowiązek oznaczać treści powstałe przy użyciu sztucznej inteligencji.

Google również podejmuje działania mające zapobiegać dezinformacji opartej na sztucznej inteligencji w kontekście wyborów. W artykule opublikowanym przez firmę czytamy, że algorytmy YouTube’a wyświetlą na stronie głównej tylko te treści dotyczące wyborów, które pochodzą z wiarygodnych źródeł. Dodatkowo reklamy wyborcze będą podlegać weryfikacji. Ma znaleźć się w nich informacja, kto jest sponsorem danego spotu.

Przed wyborami do Parlamentu Europejskiego firma Google uruchomi także kampanię prebunkingową. Jej celem jest edukowanie odbiorców, w jaki sposób mogą rozpoznawać dezinformujące i manipulujące przekazy, zanim na nie natrafią. Twórcy reklam wyborczych będą musieli ujawnić, „kiedy ich reklamy zawierają treści wygenerowane przy użyciu AI, które nieautentycznie przedstawiają prawdziwe lub realistycznie wyglądające osoby”. Treści te zostaną oznaczone etykietą, która wskaże użytkownikom, że materiały są zmodyfikowane.

Firma wprowadziła również narzędzie SynthID, które identyfikuje treści tworzone przez sztuczną inteligencję i osadza na nich cyfrowy znak wodny. Jak czytamy:

„Dzięki temu narzędziu użytkownicy mogą osadzać cyfrowy znak wodny bezpośrednio w obrazach generowanych przez sztuczną inteligencję lub w tworzonym przez siebie dźwięku. Ten znak wodny jest niezauważalny dla ludzi, ale wykrywalny w celu identyfikacji”.

Czy prawo reguluje tworzenie i rozpowszechnianie deepfake’ów w trakcie kampanii wyborczych?

Deepfake’i są dużym zagrożeniem, ponieważ trudno je odróżnić od prawdziwych obrazów. Nierozpoznane fałszywe treści mogą wpłynąć na ostateczną decyzję wyborców.

- Unia Europejska

W celu zapobiegania powstawaniu i rozprzestrzenianiu deepfake’ów podczas wyborów Unia Europejska wprowadziła ustawę o usługach cyfrowych (Digital Services Act), która określa działanie „pośredników i platform internetowych, takich jak platformy handlowe, sieci społecznościowe, platformy udostępniania treści, sklepy z aplikacjami oraz internetowe platformy turystyczne i noclegowe”.

Jej zadaniem jest przeciwdziałanie powstawaniu nielegalnych i niebezpiecznych zachowań w internecie oraz powielaniu dezinformacji. Firmy będą musiały skuteczniej kontrolować zmanipulowane treści pojawiające się na ich platformach – zgodnie ze wskazaną ustawą.

- Polska

W Polsce także nie ma ogólnego prawa regulującego kwestię deepfake’ów. Jednak zgodnie z Kodeksem cywilnym ochronie podlegają dobra osobiste człowieka, w których zakres wchodzi m.in. wizerunek danej osoby. Oznacza to, że używanie czyjegoś wizerunku w celu tworzenia deepfake’ów jest naruszeniem jego dóbr osobistych.

Jak czytamy na stronie Rzecznika Praw Obywatelskich: „Zgodnie z prawem ten, kogo dobra osobiste naruszono, ma prawo żądać zaprzestania naruszenia, usunięcia jego skutków, w tym np. przedstawienia publicznie określonego oświadczenia, a także do zadośćuczynienia i naprawienia wyrządzonej w ten sposób szkody” (art. 24 Kodeksu cywilnego).

Ochrona wizerunku ma zastosowanie w sytuacji, gdy możliwe jest rozpoznanie danej osoby na zmanipulowanym obrazie wygenerowanym przez sztuczną inteligencję.

- Stany Zjednoczone

W Stanach Zjednoczonych nie ma prawa federalnego, które zakazywałoby tworzenia deepfake’ów. W artykule „USA Today” czytamy, że Federalna Komisja Łączności (FCC) w lutym 2024 roku wydała zakaz „używania głosów generowanych przez sztuczną inteligencję w automatycznych połączeniach telefonicznych”. Federalna Komisja Handlu (FTC) określiła z kolei nowe „Zasady regulacji handlu dotyczące podszywania się pod rząd i firmy”. Wprowadzenie tych reguł ma na celu eliminowanie zmanipulowanych treści stworzonych przez sztuczną inteligencję, które podszywają się pod inne osoby czy instytucje rządowe.

Niektóre stany, np.: Kalifornia, Minnesota czy Teksas, wdrożyły przepisy dotyczące deepfake’ów, w tym nieprawdziwych treści pornograficznych.

Deepfake i sztuczna inteligencja a wybory w 2024 roku. Podsumowanie

Szybki rozwój sztucznej inteligencji jest zagrożeniem dla informacji w związku z wyborami, które w 2024 roku odbywają się w wielu państwach na świecie. Pomimo że może być ona wykorzystywana w słusznych celach, często służy też do tworzenia fałszywych treści, obrazów, filmów czy dźwięków.

Takie treści przedstawiają różne osoby w sytuacjach, które się nie wydarzyły w prawdziwym życiu. Jest to szczególnie niebezpieczne w przypadku polityków prowadzących kampanie wyborcze. Deepfake’i, czyli zmanipulowane obrazy, filmy i nagrania stworzone przy użyciu sztucznej inteligencji, trudno jest odróżnić od prawdziwych. Mogą one znacząco wpływać na decyzje wyborców i zakłócać przebieg wyborów.

Od września 2019 roku jesteśmy członkiem Programu niezależnej weryfikacji treści firmy Meta. Od października 2023 roku – członkiem Programu factcheckingowego TikToka. Jesteśmy w pełni niezależni. Wyłączna odpowiedzialność merytoryczna za publikowane przez nas analizy spoczywa na zespole redakcji portalu demagog.org.pl.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter