Artykuł

Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

Deepfake w rosyjskich rękach – znane przypadki dezinformacji

Prezydent, premier, więzień, bloger czy osoba wygenerowana przez AI? Przegląd rosyjskich deepfake’ów.

Obraz wygenerowany przez sztuczną inteligencję w programie Midjourney5

Deepfake w rosyjskich rękach – znane przypadki dezinformacji

Prezydent, premier, więzień, bloger czy osoba wygenerowana przez AI? Przegląd rosyjskich deepfake’ów.

Zdyszany Oleksandr i jego oddział stanęli na skraju lasu. Żołnierz rzucił swój plecak na ziemię i oparł się ramieniem o wiekowy, już nieco próchniejący świerk. Wiatr powiewał delikatnie. Nagle zapach lasu zastąpił smród spalenizny pomieszany z wonią wilgotnej ziemi. Oleksandr przetarł ręką spoconą twarz i spojrzał przed siebie. W oddali dojrzał zgliszcza wsi Podcharkówki oraz porzucony czołg.

Źródło: demagog.org.pl / wygenerowane przez Aleksego Szymkiewicza i Adama Majchrzaka w Midjourney

Podcharkówka nie mogła zostać zniszczona. Nie ma jej na mapie. Nigdy nie istniała. Narzędzia sztucznej inteligencji (AI) do generowania obrazów zapewniają niesamowite możliwości pod kątem tworzenia wielu różnych historii, fikcyjnych osób, miast i światów, ale też dezinformacji.

Ryzyko wykorzystania takich historii do rozpowszechniania fałszywych treści to nie tylko czcze gadanie, lecz także realny problem – szczególnie jeżeli chodzi o wojnę. W jaki sposób Rosja użyła deepfake’ów w czasie wojny i czy były to udane próby? Czy od lutego 2022 roku – w związku z rozwojem narzędzi do tworzenia obrazów – zmienił się też sposób użycia deepfake’ów?

Deepfake – (nie)udany sposób na kradzież tożsamości ukraińskich polityków

Pierwszym wojennym deepfake’iem, który obiegł sieć w marcu 2022 roku, był ten z użyciem wizerunku prezydenta Ukrainy Wołodymyra Zełenskiego. Wydawało się, że na filmie prezydent wzywa ukraińskie wojsko do kapitulacji. Wiarygodność filmu można było łatwo podważyć z powodu słabej jakości wykonania oraz nienaturalnych ruchów głowy.

Co więcej, ukraińskie władze były przygotowane na pojawienie się takiej prowokacji i zaalarmowały społeczeństwo odpowiednio wcześniej. W tym przypadku deepfake nie był skutecznym narzędziem dezinformacji, ale czy bezcelowym?

Gdy deepfake pojawił się w sieci, prezydent Ukrainy ocenił go jako „dziecinną prowokację”. Takie próby ze strony Rosji mogą być elementem testowania deepfake’ów i doskonalenia dezinformacji w praktyce.

Nie tylko prezydent Zełenski padł ofiarą głębokiej fałszywki

Innym razem Rosjanie próbowali wykorzystać deepfake na mniejszą skalę. W październiku 2022 roku ukraiński wywiad wojskowy HUR udokumentował przypadek podszycia się pod premiera Ukrainy Denysa Szmyhala. Rosjanie wykorzystali jego wizerunek do zdalnego połączenia się z Halukiem Bayraktarem – szefem tureckiej firmy, która odpowiada za produkcję dronów wojskowych. Także w tym przypadku deepfake okazał się nieskuteczny, ponieważ rozmowa została przechwycona przez ukraiński wywiad.

Była to kolejna udaremniona próba użycia deepfake’a, ale pokazała, jakie ryzyko może nieść za sobą ta technologia. Ktoś może np. użyć jej, aby podszyć się pod osoby publiczne i dyskredytować relacje na arenie międzynarodowej, a w najgorszym przypadku – wywołać kryzys dyplomatyczny.

Nagrania z użyciem techniki deepfake można sprawdzić m.in. przy użyciu narzędzia Deepware Scanner. Narzędzie ocenia prawdopodobieństwo ingerencji sztucznej inteligencji w film. Więcej na ten temat znajdziesz w analizie o weryfikacji generowanych obrazów.

Oblicza nieistniejących Ukraińców – czyli fałszywe konta w mediach społecznościowych

Rosyjska dezinformacja ma już długą i skuteczną praktykę w kreowaniu fałszywych kont w mediach społecznościowych. Nie inaczej jest w czasie inwazji na Ukrainę.

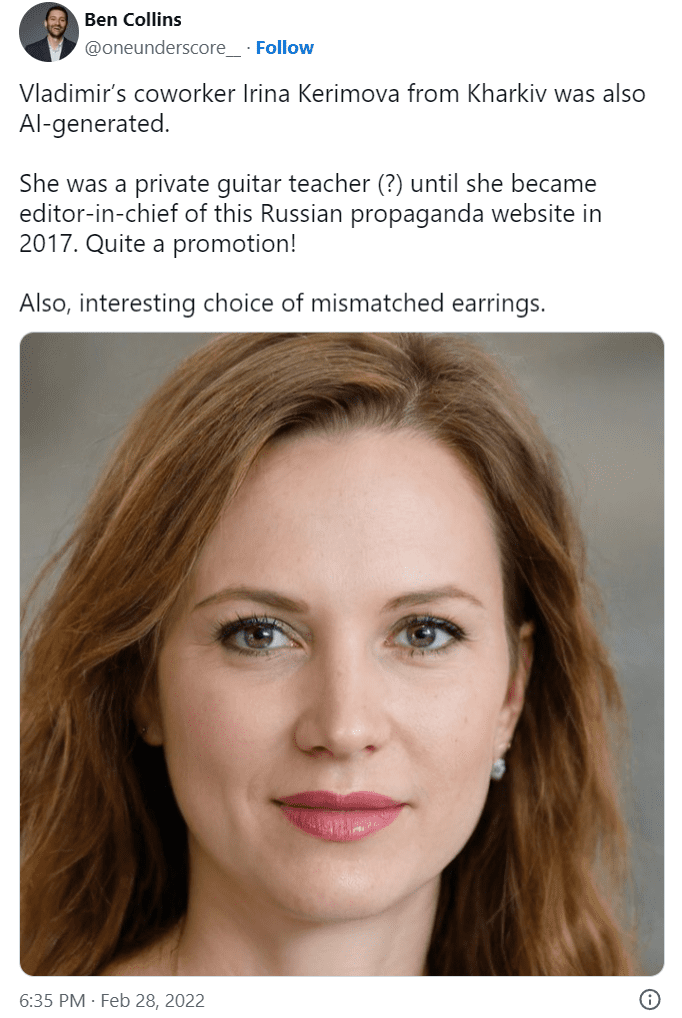

Reporter NBC News Ben Collins, nagłośnił sprawę m.in. dwóch kont, które posługiwały się wygenerowanymi wizerunkami. Dziennikarz zidentyfikował postać Władimira Bondarenko, który przedstawiał się jako bloger z Kijowa. Okazało się, że to fikcyjna osoba, której zadaniem było uwiarygodnienie kremlowskich narracji o wojnie w oczach Ukraińców i Rosjan.

Podobnie działać miała fikcyjna Irina Kerimova, nauczycielka gry na gitarze z Charkowa. Pod tym nazwiskiem publikowano nienawistne komentarze pod adresem ukraińskiego rządu. Bondarenko i Kerimowa to postaci, które nigdy nie istniały, a ich twarze zostały stworzone przez narzędzia AI.

Takie twarze mogą być tworzone przy użyciu narzędzia ze strony this-person-does-not-exist.com. Weryfikację grafik stworzonych przez AI umożliwiają m.in. wtyczka Fake Profile Detector V7 oraz narzędzie AI-Generated Image Detection od TheHive.ai, przy czym podkreślamy – nie warto przy weryfikacji polegać tylko i wyłącznie na narzędziach. Więcej na ten temat znajdziesz w analizie na temat weryfikacji generowanych obrazów.

Rosyjska ambasada i media. AI jako część fałszywych informacji z oficjalnych kanałów

W miarę rozwoju narzędzi, takich jak Midjourney czy DALL-E, tradycyjne deepfake’i mogą zostać wyparte przez szybsze rozwiązań. W przestrzeni informacyjnej zaobserwowano już kilka przypadków, gdy oficjalne kanały powiązane z rosyjskim rządem wspierały – choćby nieumyślnie – narracje tworzone na podstawie wygenerowanych obrazów.

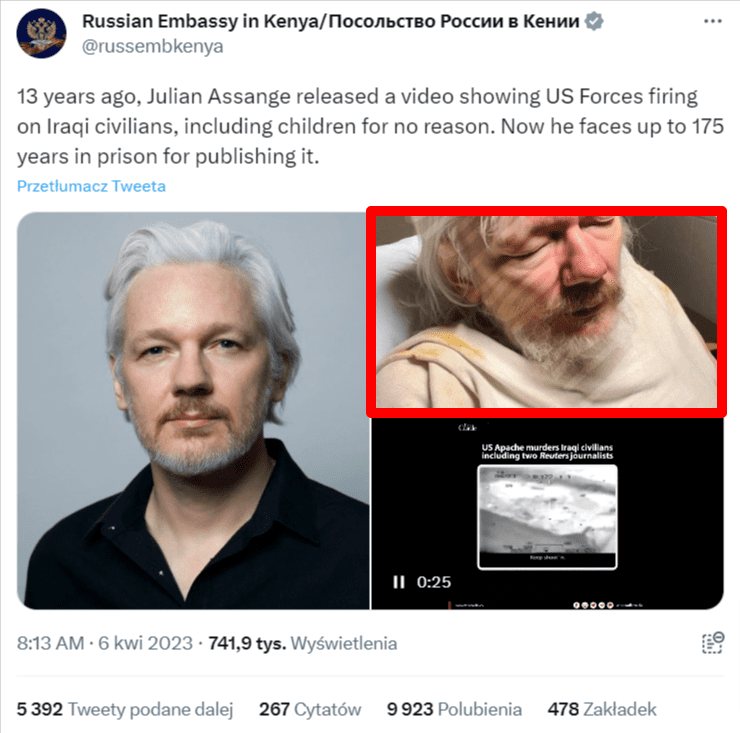

Redakcja The France 24 Observers wskazała, że 6 kwietnia 2023 roku rosyjska ambasada w Kenii udostępniła wygenerowany wizerunek wyczerpanego i zranionego Juliana Assange’a, założyciela portalu WikiLeaks, który od 2019 roku przebywa w brytyjskim więzieniu. W ten sposób próbowano uwiarygodnić narrację, jakoby więzień był traktowany w niehumanitarny sposób.

Fałszywe informacje o eksplozji w Waszyngtonie i rosyjskie media

W maju 2023 roku niektóre prorosyjskie źródła powieliły fałszywą informację o tym, że w okolicach Pentagonu doszło do eksplozji. Autor informacji nie jest znany, jednak treści na ten temat udostępniła propagandowa telewizja Russia Today (materiał usunięto).

Nie wiadomo, czy stacja uczyniła to celowo, czy powieliła fake news przypadkiem. Te same treści powielały też fałszywe konta, w tym m.in. twitterowe konto @BloombergFeed, które podszywało się pod redakcję Bloomberg.

This morning blue check accounts accounts claimed large explosions at the Pentagon.

… then the White House.

Russian state media amplified the faked Pentagon image from their gold check account.

The images look AI generated, as folks identified. 1/ pic.twitter.com/Bd9uu3jwPZ

— John Scott-Railton (@jsrailton) May 22, 2023

Okolice widoczne na wygenerowanym obrazie w ogóle nie przypominały tych wokół siedziby Departamentu Obrony Stanów Zjednoczonych, a poszczególne elementy otoczenia wyglądały nienaturalnie. Choć informację dość szybko zweryfikowano, to jednak chwilowo wpłynęła negatywnie na kursy akcji na giełdzie, co mogło słono kosztować niektórych inwestorów.

Obrazy wygenerowane m.in. przez Midjourney i DALL-E można sprawdzić m.in. przy użyciu narzędzia AI-Generated Image Detection od TheHive.ai. Trzeba pamiętać jednak, że nie jest to narzędzie w 100 proc. idealne. Zawsze warto dokładniej przyjrzeć się obrazom w sieci. Więcej na ten temat znajdziesz w analizie nt. weryfikacji generowanych obrazów.

Podsumowanie – udane czy nie… dezinformacja to proces ciągłego uczenia się

Dezinformacja to zwykle skoordynowany proces, którego celem jest wprowadzenie fałszywych lub mylących informacji. Jej nieodłącznym elementem jest aspekt uczenia się. Dziś z pozoru niegroźne i nieudolnie wykonane deepfake’i mogą być częścią testowania odporności na fałszywe informacje w społeczeństwie lub wśród przedstawicieli ośrodków decyzyjnych (np. służb specjalnych).

Duży problem tkwi też w tym, że „zwodniczość” deepfake’ów oceniamy na podstawie tylko tych obrazów, które udało się zweryfikować. Trudno stwierdzić, ile dokładnie takich obrazów krążyło w sieci i czy każdy z nich został w porę zidentyfikowany.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter