Artykuł

Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

Złowieszczy Obama i stylowy papież – ewolucja deepfake’ów

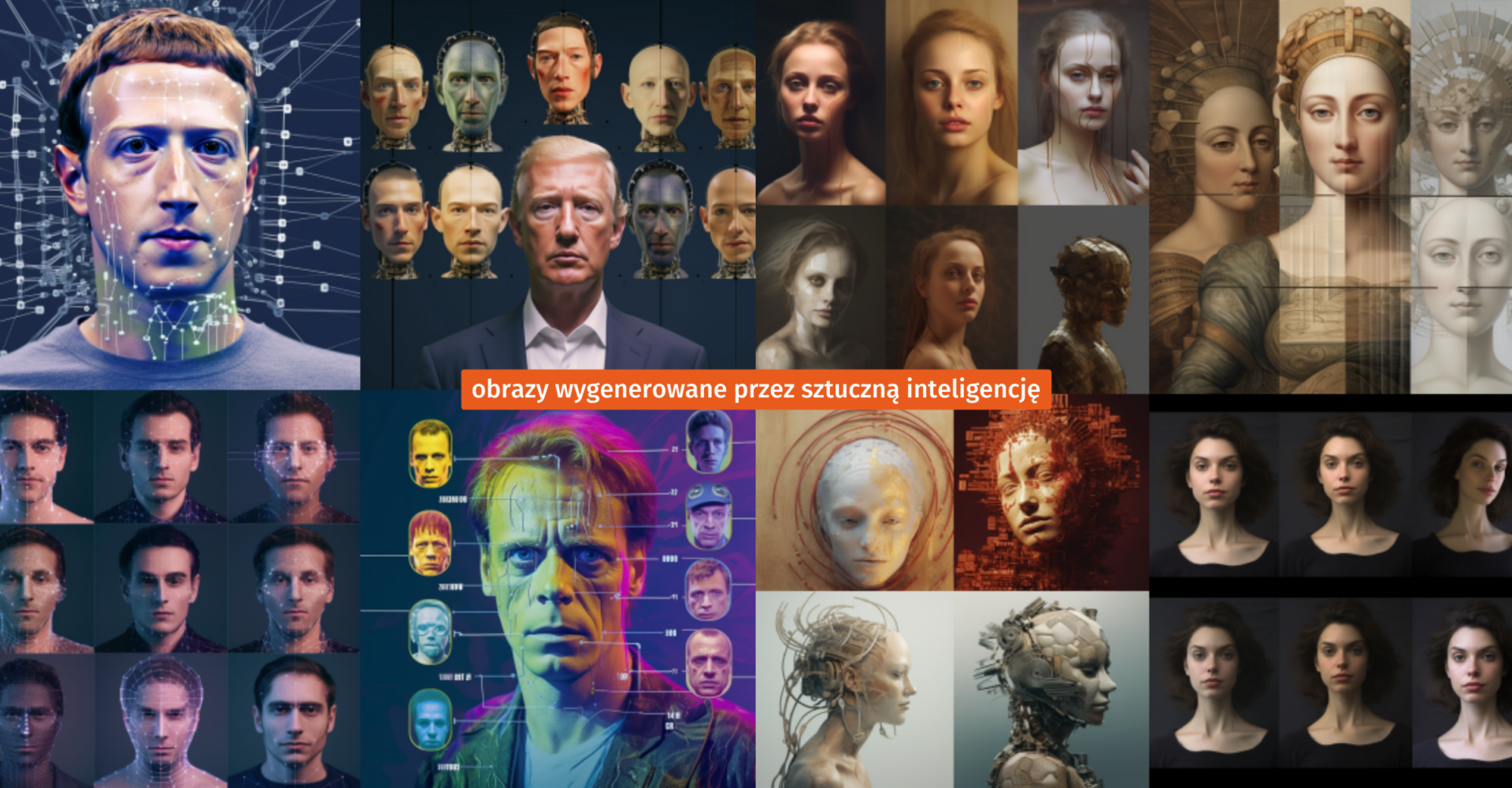

Obrazy generowane przez sztuczną inteligencję odmienią nasze życie. Tylko czy na dobre?

Obrazy wygenerowane przez sztuczną inteligencję w programie Midjourney

Złowieszczy Obama i stylowy papież – ewolucja deepfake’ów

Obrazy generowane przez sztuczną inteligencję odmienią nasze życie. Tylko czy na dobre?

Rok 2030. Godzina 18:58, właśnie siadasz do swojego ulubionego live streamu na Twitchu. Lampka na biurku delikatnie razi cię w oczy. Gasisz ją. Wybija godzina 19. Za chwilę na ekranie pojawia się „On”. Z gameplayem Half Life 3! Rzuca najlepszymi żartami, a widzowie zadają setki pytań – zabawa trwa w najlepsze… „On” – czyli AI z całkiem ludzką twarzą, zdolne do tworzenia rozrywki w czasie rzeczywistym. Brzmi jak science fiction?

To fikcja, ale w sieci od kilku lat funkcjonuje np. Lil Miquela („19-letni robot”), stworzona przez człowieka jako obraz generowany komputerowo (CGI). Jej publika na Instagramie przekroczyła ponad 2,8 mln obserwujących. Obecnie za prowadzenie tego konta odpowiadają ludzie, ale wydawałoby się, że przy obecnych możliwościach technologicznych związanych ze sztuczną inteligencją (AI) kontrolę można byłoby oddać jej samej. Co jednak, jeżeli celem fikcyjnej postaci nie będzie rozrywka, a ktoś wykorzysta to narzędzie do dezinformacji?

Rysowanie przyszłych scenariuszy dotyczących AI może przywodzić na myśl katastroficzne obrazy. Na nasze polecenie AI może – przy użyciu DALL-E czy Midjourney – wygenerować dowolne obrazy (np. fikcyjne zdarzenia). Jednak najpewniej nikt z nas nie musi obawiać się rzeczywistości rodem z filmów „Blade Runner” czy „Matrix”.

Wprowadzenie AI przyniesie nam wiele ułatwień, ale już teraz warto pochylić się nad zagrożeniami, które może za sobą pociągnąć. Tak samo jak energia atomowa: z jednej strony może być zabójcza, a z drugiej – daje światu potrzebną energię. Rozwój narzędzi, które generują grafiki przy użyciu AI, gwałtownie przyśpiesza, wobec czego zasadne wydaje się pytanie: technologia stanie się ułatwieniem czy może narzędziem do masowego rozpowszechniania dezinformacji?

Tekst Aleksego Szymkiewicza i Adama Majchrzaka – analityków Stowarzyszenia Demagog – to pierwszy z trzech artykułów nt. weryfikacji fałszywych obrazów generowanych przez AI. Z tej publikacji dowiesz się, jak przebiegała ewolucja narzędzi generatorów grafik oraz jak wraz z nią zmieniały się fałszywe przekazy wykorzystujące obrazy tworzone przez AI. Dzięki zawartym tu informacjom zyskasz świadomość, że technologia może zostać użyta do kreowania fałszywych informacji. W kolejnych tekstach poznasz prawdziwe możliwości AI i dowiesz się, czy faktycznie tak łatwo jest wykryć wygenerowany obraz oraz w jaki sposób go zweryfikować.

Żywe marionetki i ponury Barack Obama – wszystko zaczęło się w 2017 roku

Do niedawna deepfake’i (obrazy, które zostały poddane manipulacji przy użyciu sztucznej inteligencji) wydawały się tylko ciekawostką, a dziś powstają już pierwsze fake newsy z ich wykorzystaniem. Jednak tylko od nas zależy, jakie regulacje wypracujemy i w jaki sposób będziemy używać sztucznej inteligencji.

W listopadzie 2017 roku algorytmy do generowania deepfake’ów stały się publicznie dostępne. Już na początku 2018 roku udostępniono w sieci aplikację FakeApp, która umożliwiła prostą podmianę twarzy w filmach. Nicolas Cage jako Albus Dumbledore w filmie o Harrym Potterze? Czy może Tomasz Karolak w „Oszukać przeznaczenie” zamiast w klasycznej polskiej komedii? Wszystko to stało się możliwe na naszych oczach. Tylko na ile jest to rozrywka, a na ile problem?

Deepfake – to efekt działania algorytmów tworzonych ręcznie lub trenowanych na olbrzymich bazach danych. Takie algorytmy na polecenie człowieka mogą tworzyć materiały wizualne, przedstawiające nieistniejące osoby lub zmanipulowane obrazy. Pierwotnie termin mógł być kojarzony z filmami, w których pojawiały się postacie z zamienionymi twarzami, jednak obecnie coraz częściej używa się go także w kontekście wszystkich obrazów generowanych przez AI, które starają się odwzorować prawdziwe postacie.

W 2017 roku naukowcy z University of Washington stworzyli deepfake z Barackiem Obamą. Z kolei pierwszy popularny na całym świecie deepfake powstał w 2018 roku, a jego stworzeniem mógł pochwalić się komik i reżyser Jordan Peele, który przy użyciu Adobe After Effects i FakeApp wygenerował nieprawdziwy wizerunek Baracka Obamy. W materiale 44. prezydent USA miał opowiedzieć m.in. o ostatnich premierach filmowych i polityce, ale na koniec stwierdził ponuro: „sposób, w jaki posuniemy się naprzód w epoce informacji, będzie wpływać na to, czy przetrwamy, czy też staniemy się popieprzoną dystopią” – to przesłanie, które powinno towarzyszyć nam w każdej debacie nad etycznym wykorzystaniem AI.

Walki sieci neuronowych i olbrzymie bazy danych – jak to wszystko działa?

Pierwszym krokiem do wytrenowania sztucznej inteligencji była nauka rozpoznania odpowiednich wzorców i cech w obrazach cyfrowych. Dzięki temu algorytmy nauczyły się klasyfikować grafiki według zawartości, np. twarzy czy poszczególnych obiektów, i z czasem nabyły zdolność rozpoznawania charakterystycznych cech obrazów, co ostatecznie spowodowało, że tak wytrenowane programy potrafią kreować np. grafiki w stylu konkretnego artysty.

Algorytmy nauczyły się łączyć poszczególne elementy dzieł, ale także tworzyć nieistniejące twarze, obiekty czy zwierzęta, wzorując się na rzeczywistych obrazach. Dostępne generatory grafik bazują głównie na dwóch technologiach: GAN (Generative Adversarial Networks) oraz NST (Neutral Style Transfer).

GAN – czyli Generative Adversarial Networks – to technologia opracowana przez Iana Goodfellowa w 2014 roku. Oparta jest o dwie sieci neuronowe, które konkurują ze sobą. Jedna z nich, generator (zasilony zbiorem podobnych danych), stara się wygenerować autentyczną treść, natomiast druga – dyskryminator, ocenia ją jako prawdziwą lub fałszywą, czyli albo będącą „podróbką” innego obrazu, albo nie. W ten sposób wyuczona sieć może tworzyć wiarygodne – choć nieistniejące – zwierzęta, obiekty, ale i twarze.

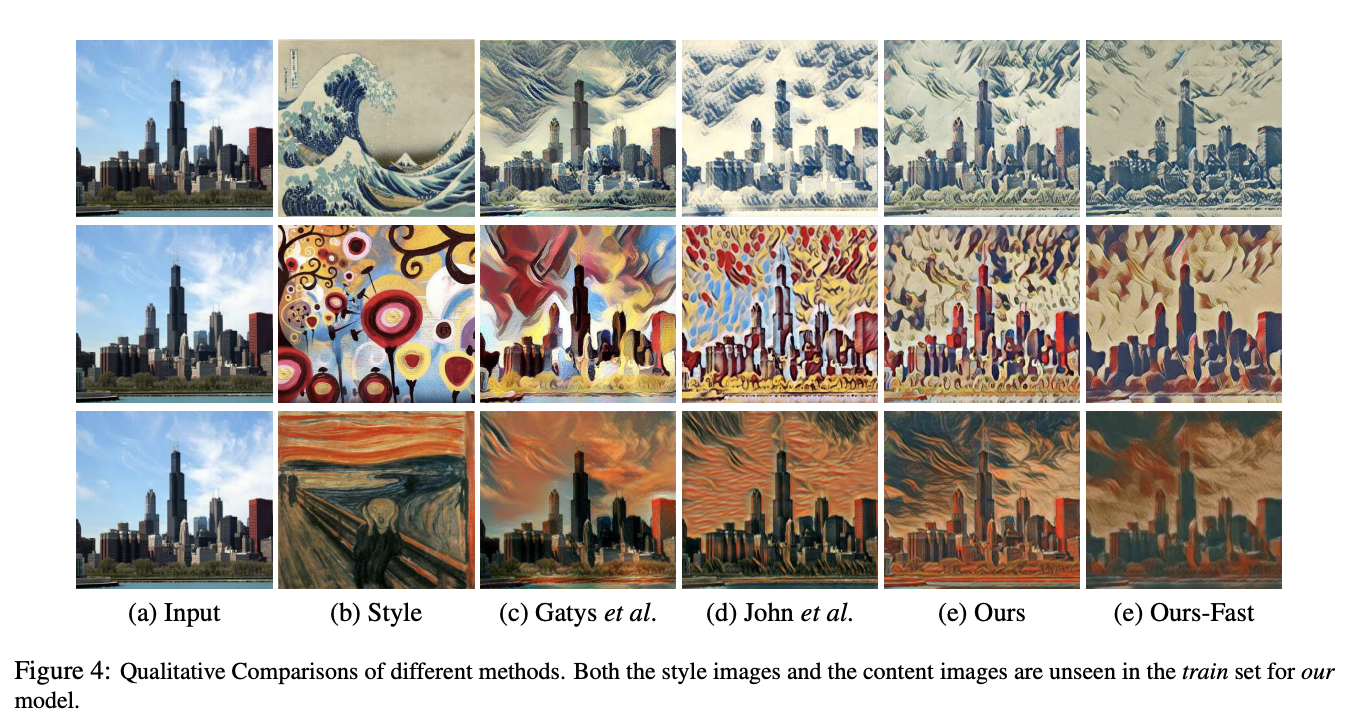

Z kolei technologia Neural Style Transfer wykorzystuje możliwość naśladowania stylu. Po dostarczeniu danych wejściowych (a) algorytm AI zasilony przykładem konkretnego stylu (b) może automatycznie wygenerować grafikę, która zestawi ze sobą oba pliki, zwracając grafiki lub zdjęcia w określonej konwencji. Technologia NST weszła do użytku w 2015 roku.

Czy ty w ogóle istniejesz? Przypadki deepfake’ów po 2018 roku

W 2018 roku firma NVIDIA opracowała technologię StyleGAN, która w założeniu miała służyć rozpoznawaniu twarzy, ale w efekcie ubocznym umożliwiła generowanie w kilka sekund całkowicie fikcyjnych ludzkich wizerunków. W 2019 światło dzienne ujrzała strona this-person-does-not-exist.com, dzięki której każdy może wygenerować nieprawdziwą twarz osoby o dowolnej płci i w dowolnym wieku.

Jakie są niebezpieczeństwa tej technologii? Dzięki niej każdy z nas może stać się władcą marionetek. Technologia została użyta do tworzenia wielu nieprawdziwych profili w mediach społecznościowych. W 2019 roku na platformie LinkedIn pojawiło się konto Kate Jones. Choć jej sieć kontaktów była skromna, to sugerowała, że związana jest ze światem waszyngtońskiej polityki.

Instytucje, w których miała pracować i zdobyć wykształcenie, zaprzeczały informacjom znajdującym się na jej profilu, a jej zdjęcie zostało prawdopodobnie wygenerowane przez GAN. Nie jest znana tożsamość osoby, która stała za stworzeniem fałszywego konta. Wkrótce po skontaktowaniu się agencji AP News z platformą profil został usunięty. W międzyczasie konto mogło zdobyć informacje o osobach, które zaakceptowały jej zaproszenie do grona kontaktów.

Mark Zuckerberg vs deepfake

W drugiej połowie 2019 roku Facebook stanął przed pewnym dylematem. Na portalu pojawiło się nagranie z udziałem Nancy Pelosi, której stan miał wskazywać na spożycie alkoholu. Jak dokonano manipulacji? Nagranie zostało odtworzone w zwolnionym tempie.

W mediach dyskutowano jednak nad potencjalnymi deepfake’ami, które pojawią się w niedalekiej przyszłości, i nad tym, czy materiał powinien zostać usunięty. Platformy YouTube, TikTok i Twitter usunęły film, ale Facebook ogłosił, że tego nie zrobi, i jedynie ograniczył jego widoczność poprzez skierowanie sprawy do fact-checkerów.

Tymczasem po miesiącu deepfake nawiedził samego Marka Zuckerberga – na jego platformie pojawiło się nagranie wygenerowane przez startup Canny AI. W filmie przedstawiono wykreowany awatar właściciela platformy. Ten kazał wyobrazić sobie, że „jeden człowiek (Mark Zuckerberg – przyp. Demagog) ma kontrolę nad miliardami skradzionych danych” – wyglądało to tak, jakby twórca Facebooka krytykował sam siebie. Tym samym deepfake stał się narzędziem nacisku wobec dużej platformy.

W 2020 roku deepfake dał o sobie znać ponownie – tym razem opublikowano nagranie z wizerunkiem Shophie Wilmès – byłej belgijskiej premier. Z wypowiedzi miało wynikać, że polityczka uważała, że wszystkie niedawne epidemie były efektem działalności człowieka, która wpływa na klimat. Niektórzy internauci uwierzyli, że naprawdę były to jej słowa. Tymczasem polityczka nigdy ich nie wypowiedziała. Nagranie zostało stworzone przez aktywistów grupy Extinction Rebellion Belgium.

Nowe zagrożenia związane z użyciem obrazów generowanych przez AI

Fałszywe nagrania i obrazy generowane przez AI są coraz bardziej niebezpieczne. I to nie tylko dla osób publicznych – w 2019 roku opublikowano raport Deeptrace, z którego wynikało, że liczba deepfake’ów w sieci przekroczyła 14 tys., a 96 proc. fałszywych filmów opublikowanych online miało charakter pornograficzny. Taki rodzaj pornografii w wielu przypadkach może być tworzony bez zgody na wykorzystanie wizerunku – tak, jak to było w przypadku youtuberki Sunpi, która o deepfake’u ze swoim wizerunkiem dowiedziała się od jednego z fanów.

Na dużą uwagę zasługuje najpewniej pierwsze w historii świata użycie deepfake’a w dezinformacji wojennej. W marcu 2022 roku na krótkim nagraniu postać przypominająca Wołodymyra Zełenskiego wzywała ukraińskich żołnierzy do złożenia broni i poddania się Federacji Rosyjskiej.

Nagranie wyglądało dość nienaturalnie, ponieważ prezydent miał za dużą głowę. Ukraińskie władze jeszcze przed publikacją materiału spodziewały się powstania takiej fałszywki i jej użycia na szeroką skalę, co pozwoliło zaalarmować społeczeństwo.

Franciszek, Trump i Macron wchodzą do baru… AI na sterydach po 2022 roku

W ostatnich latach deepfake przybierał głównie formę wideo, ale po roku 2022 sytuacja może ulec diametralnym zmianom. Najnowsze generatory obrazów AI, takie jak Midjourney czy DALL-E, wykorzystują możliwość tworzenia plików graficznych na podstawie komend tekstowych. W dodatku generowane przez nie treści graficzne coraz trudniej odróżnić od faktycznych zdjęć, a niewykluczone, że w niedługiej perspektywie czasowej w ogóle nie będzie można ich odróżnić gołym okiem. Będą potrzebne do tego odpowiednie umiejętności i narzędzia.

Robot WALL-E albo Salvador Dalí. A może jedno i drugie?

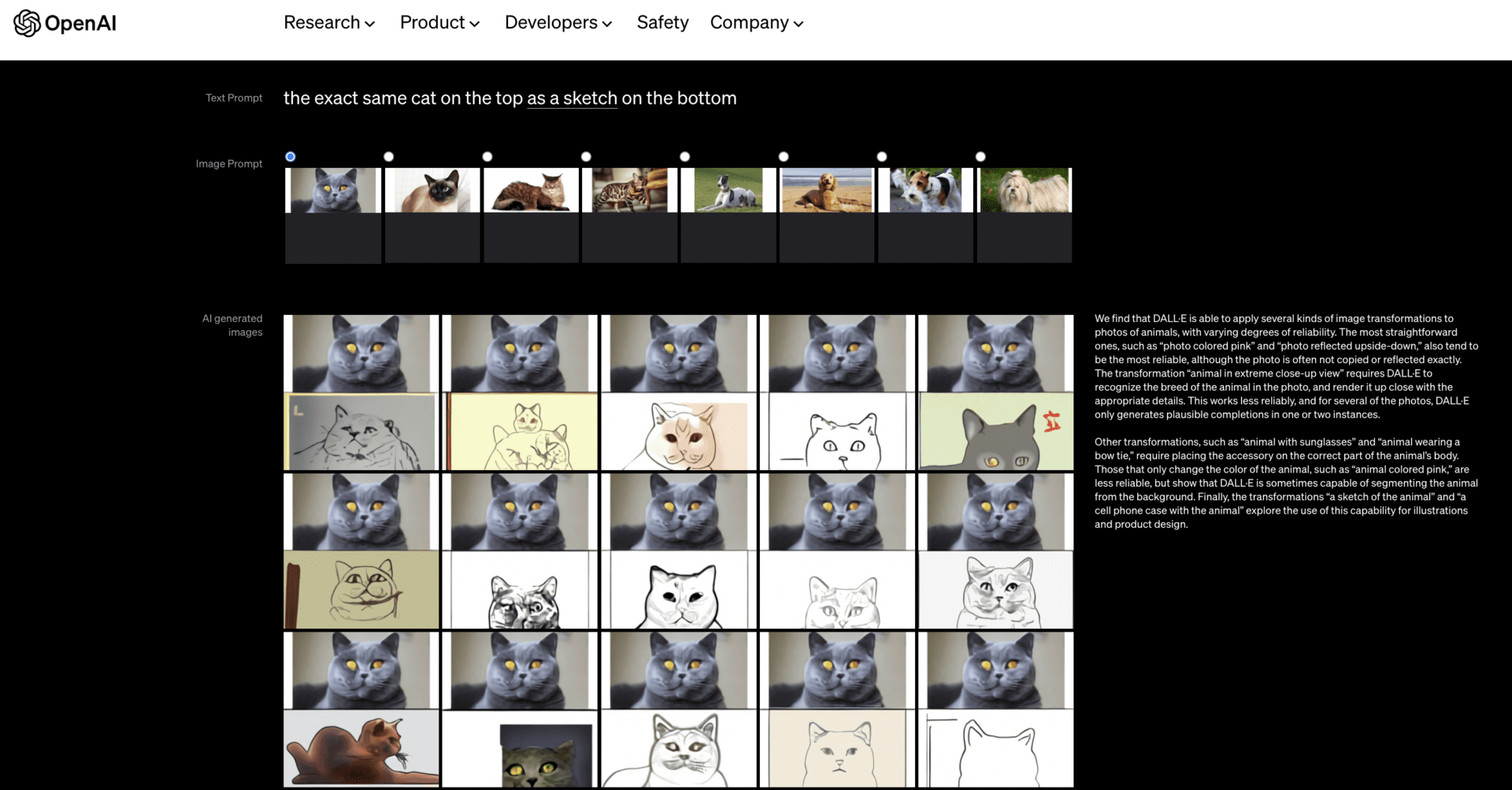

DALL-E to narzędzie stworzone przez firmę OpenAI w styczniu 2021 roku. Przy pracy nad ChatGPT okazało się, że algorytm nie tylko generuje treści tekstowe, lecz także dobrze sobie radzi z produkcją treści graficznych. Tak właśnie powstał algorytmiczny artysta DALL-E, którego nazwa wywodzi się od filmowego WALL-E i znanego malarza – Salvadora Dalí.

Narzędzie może edytować istniejące obrazy oraz tworzyć wariacje dostarczonych mu plików cyfrowych przy zachowaniu ich charakterystycznych cech. Pierwsza z wersji programu bazowała na technologii GPT-3 (Generative Pre-trained Transformer), czyli na modelu językowym wytrenowanym na olbrzymich bazach, który potrafi generować treści na podstawie kontekstu.

Poprzez tzw. prompty (odpowiednie komendy dla AI) użytkownicy podają charakterystyczne cechy grafiki i jednocześnie instruują narzędzie do przeszukiwania bazy w odpowiednim kierunku. Dzięki instrukcjom tekstowym narzędzie działające na podstawie chatbota GPT może generować precyzyjne treści graficzne w krótkim czasie.

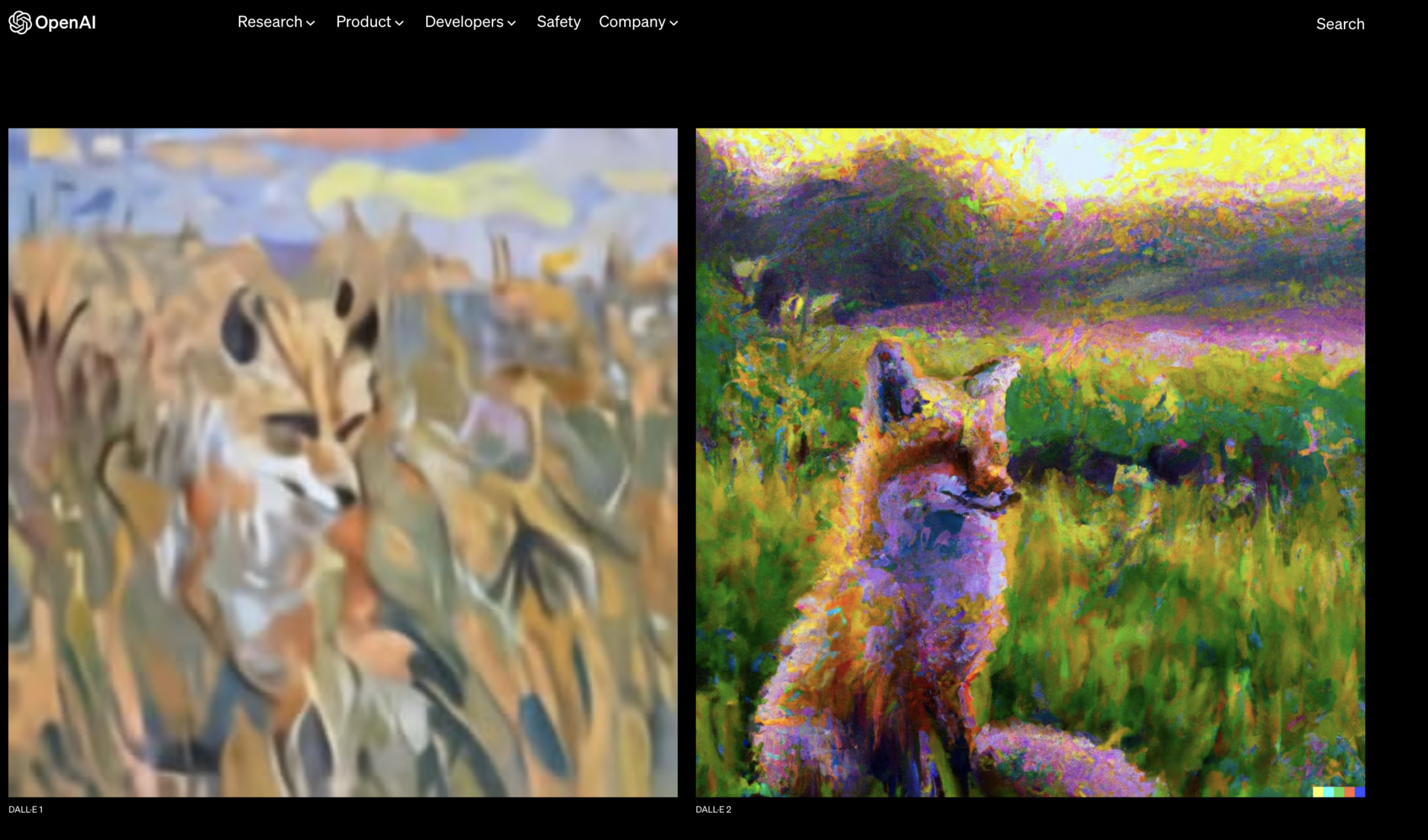

Aktualnie dostępna jest nowa wersja narzędzia DALL-2. Ta generuje zdecydowanie bardziej zaawansowane i szczegółowe grafiki niż jej poprzedniczka – nierzadko z artystycznym zacięciem. Wszystko zależy jednak od naszego pomysłu i odpowiedniego łączenia kontekstów.

Donald Trump w areszcie, torturowany Julian Assange – Midjourney V5 w akcji

Midjourney – podobnie jak DALL-E – pozwala na generowanie grafik na podstawie dostarczonych mu podpowiedzi. Po wybraniu odpowiednich kanałów i parametrów wystarczy sformułować instrukcję zawierającą charakterystyczne cechy grafiki, a algorytm błyskawicznie zwróci cyfrowy plik. Dostęp do aplikacji odbywa się przez platformę Discord.

To właśnie przy wykorzystaniu tego narzędzia Elliot Higgins – założyciel redakcji Bellingcat – stworzył grafiki obrazujące możliwe aresztowanie Donalda Trumpa. Higgins wygenerował cyfrowe obrazy, aby sprawdzić, do czego zdolne jest to narzędzie. Chwilę później wybrane treści obiegły media społecznościowe.

Making pictures of Trump getting arrested while waiting for Trump's arrest. pic.twitter.com/4D2QQfUpLZ

— Eliot Higgins (@EliotHiggins) March 20, 2023

Aktualnie dostępna jest piąta edycja narzędzia. Ze względu na zbyt wysoki popyt i pojawiające się nadużycia związane z generowaniem fikcyjnych obrazów Midjourney wycofało się z darmowego pakietu dostępu. Tempo rozwoju AI zaczyna mocno przyspieszać i trudno powiedzieć, jakie konsekwencje będzie to miało dla nas wszystkich.

Największym echem w marcu 2023 roku w mediach odbił się wygenerowany obraz papieża Franciszka ubranego w stylową kurtkę, na temat którego pisał analityk Demagoga – Mateusz Cholewa. Wielu internautów było zaskoczonych tym, jak bardzo realna wydawała się ta ilustracja.

🤨 Czy #Papież pozazdrościł dripu amerykańskim raperom i zaczął chodzić w ogromnej, pikowanej kurtce? #Zdjęcia papieża Franciszka, które zalały internet, to najnowsze dzieło #MidJourney AI do generowania grafik, której użytkownicy dają coraz większe pole https://t.co/IW7fXoPEXd… pic.twitter.com/2rpobZyOhM

— 🔎 DEMAGOG (@DemagogPL) March 28, 2023

Wydaje się, że takie obrazy będą coraz częściej stosowane w dezinformacji. W kwietniu 2023 roku w sieci została rozpowszechniona wygenerowana grafika z Julianem Assangem – założycielem WikiLeaks. Na obrazie opublikowanym przez rosyjską ambasadę w Kenii przedstawiono pobitego mężczyznę, który zgodnie z sugestią miał być przetrzymywany w niehumanitarnych warunkach w więzieniu w Wielkiej Brytanii.

Podsumowanie – deepfake rodzi jeszcze więcej pytań o bezpieczeństwo

W tej chwili trudno jest określić, na jak dużą skalę obrazy AI mogą wyrządzić szkodę. Odkrycie wielu zagrożeń jeszcze przed nami, ale już teraz AI może zrobić na nas imponujące wrażenie.

- W którym miejscu historii rozwoju AI się znajdujemy?

- Jak bardzo zwodnicze mogą być obrazy generowane przez AI?

- I w końcu… czy AI faktycznie ma problem z generowaniem detali, takich jak dłonie, zęby i ręce?

Odpowiedzi na te pytania poznasz w kolejnej analizie.

Drugi tekst znajdziesz tutaj (po kliknięciu).

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter