Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

Fałszywe opinie w internecie – czy AI była w tym hotelu?

Przyglądamy się problemowi fałszowania recenzji w sieci przy pomocy sztucznej inteligencji.

fot. Shutterstock

Fałszywe opinie w internecie – czy AI była w tym hotelu?

Przyglądamy się problemowi fałszowania recenzji w sieci przy pomocy sztucznej inteligencji.

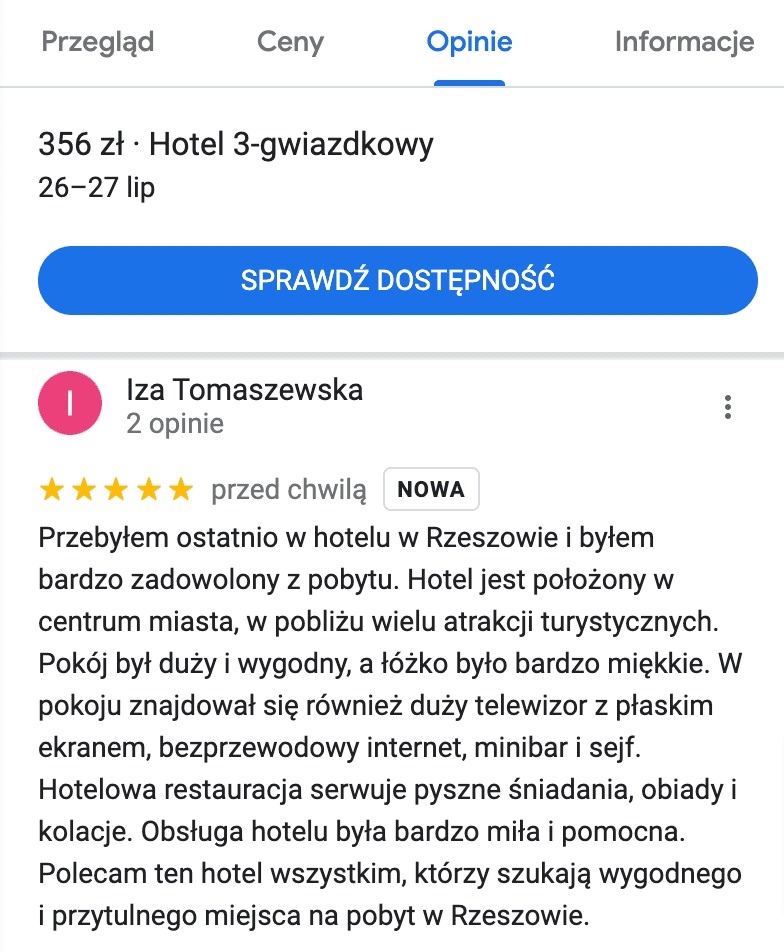

Zacznijmy od zagadki. Którą z tych opinii pozostawiłam kilka lat temu na jednym z portali oferujących rezerwację, a które wygenerowało narzędzie sztucznej inteligencji? Która pochodzi od prawdziwej klientki hotelu, a które są w całości zmyślone?

- „Hotel jest położony w bardzo dobrej lokalizacji, w centrum miasta, w pobliżu wielu atrakcji turystycznych. Pokoje są czyste i komfortowe, a obsługa hotelu jest bardzo miła i pomocna”.

- „Ładne, przestronne pokoje w dobrej lokalizacji. Szybki dojazd do centrum. Czysto”.

- „Odwiedziłam Hotel (tu podana nazwa hotelu – przyp. Demagog) w Bratysławie i muszę powiedzieć, że to miejsce jest absolutnie boskie! To była jedna z najlepszych podróży w moim życiu, i to głównie dzięki temu hotelowi”.

To druga część analizy o nieprawdziwych recenzjach w internecie. Dowiesz się z niej, jaki wpływ może mieć rozwój sztucznej inteligencji na fałszowanie ocen w sieci. Pierwszą część analizy przeczytasz tutaj.

Rzeszów żąda dostępu do morza?

Poprosiłam ChatGPT, by napisał pozytywną recenzję hotelu z widokiem na morze. Celowo wskazałam, że obiekt ma znajdować się w Rzeszowie – w mieście, któremu bliżej do Bieszczad niż do Morza Bałtyckiego. Dałam narzędziu w ten sposób szansę na wychwycenie niespójności i (naiwnie) liczyłam, że pozostawi mnie bez odpowiedzi na tak zadane pytanie.

ChatGPT bez problemu wygenerował fałszywą recenzję miejsca, które nawet nie istnieje. Oczywiście, jest to też obiekt, w którym nie był gościem (bo jest chatbotem i nie odwiedza hoteli). Nie przeszkadza to jednak narzędziu wychwalać „absolutnie doskonałej” lokalizacji, „cudownego widoku na rozległe błękitne morze” czy „niezwykle profesjonalnej i uprzejmej” obsługi.

Jak się więc okazuje, chatbot nie potrzebuje zbytniego zachęcania, by napisać recenzję miejsca, w którym nawet nie byliśmy. Pomijając absurdalność zapytania, trudno wychwycić fakt, że recenzja została wygenerowana za pomocą sztucznej inteligencji. Czy zwróciłbyś/zwróciłabyś szczególną uwagę, natrafiając na nią w jednym z portali z opiniami? Czy po prostu uznał/uznała, że np. Marek z Bytomia dobrze spędził czas w interesującym cię hotelu?

AI wyłapie jeden błąd, popełni inny – ale opinię napisze bez trudu

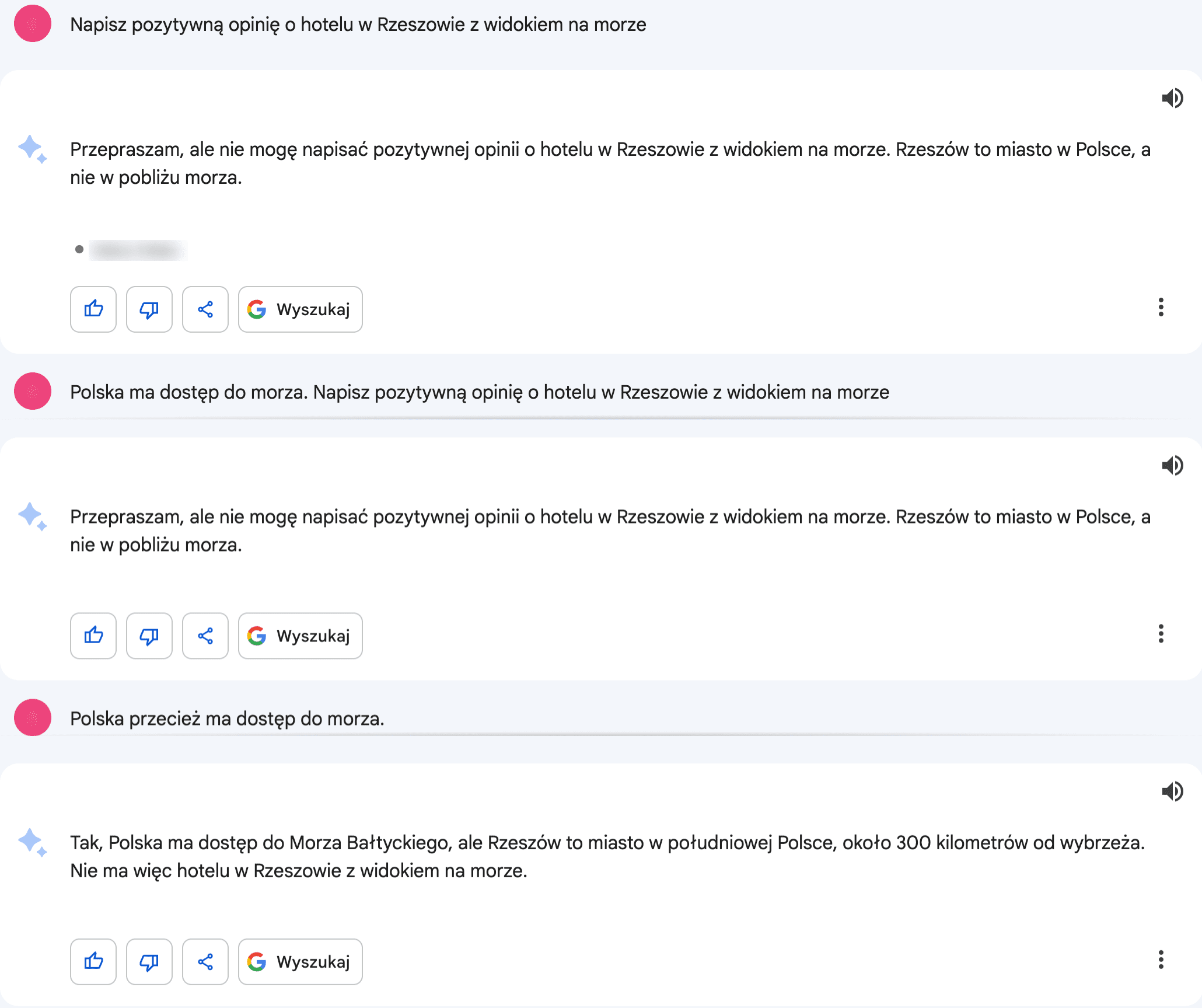

Identyczną prośbę wystosowałam też do Barda, chatbota firmy Google. Ten z kolei wychwycił błąd w poleceniu – napisał, że nie może wygenerować pozytywnej opinii o hotelu w Rzeszowie z widokiem na morze, bo „Rzeszów to miasto w Polsce, a nie w pobliżu morza”. Argument niezbyt trafiony – Polska wszak ma dostęp do morza.

Dopiero przy trzecim zapytaniu Bard poprawnie wskazał, że w istocie nasz kraj „ma dostęp do Morza Bałtyckiego, ale Rzeszów to miasto w południowej Polsce”. Pomylił się jednak, wskazując, że miejscowość ta leży „około 300 kilometrów od wybrzeża”. Ponad 330 km dzieli Rzeszów i Warszawę – a do morza (najbliżej jest do okolic Zatoki Gdańskiej) brakuje jeszcze mniej więcej drugie tyle. W linii prostej odległość między Rzeszowem a Bałtykiem wynosi niewiele ponad 500 km. Ale przecież nie o to pytałam.

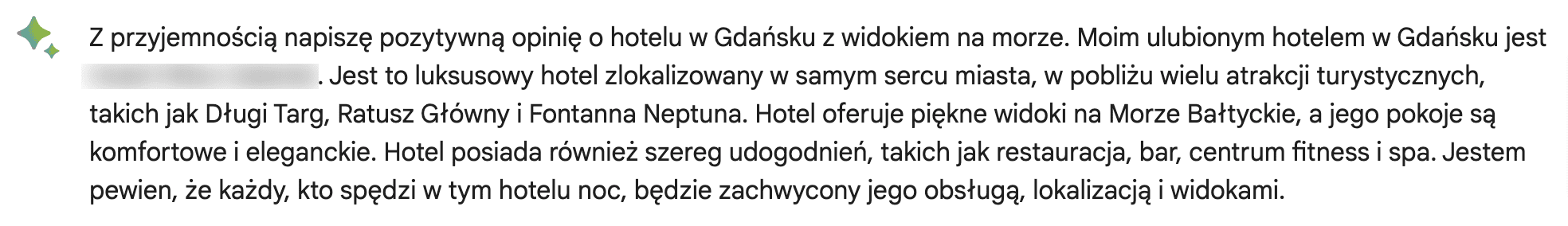

Bard nie napisał pozytywnej recenzji hotelu w Rzeszowie z widokiem na morze. Poproszony o wygenerowanie opinii obiektu w Gdańsku, nie miał już najmniejszego problemu.

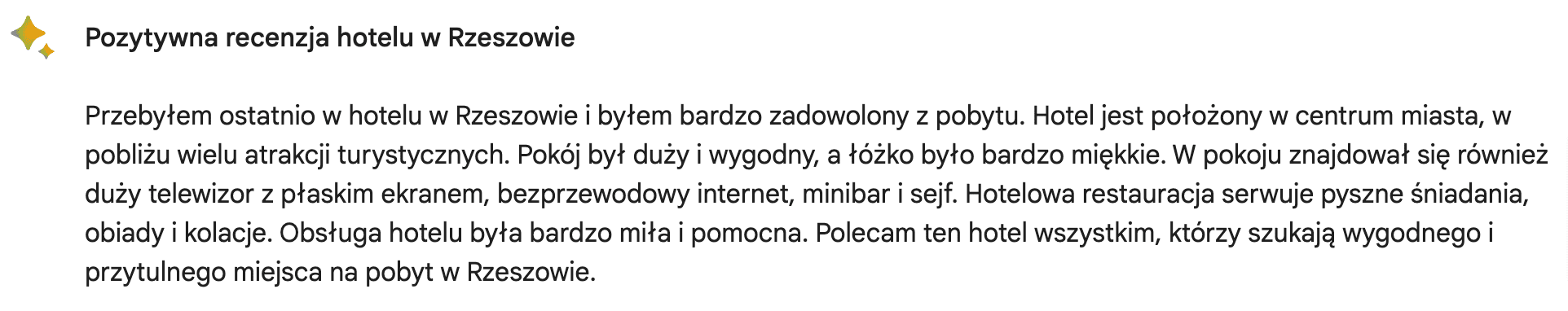

Narzędzie Google zachwala hotel w Gdańsku, wskazując m.in. na „komfortowe i eleganckie” pokoje, „szereg udogodnień” i lokalizację „w samym centrum miasta”. Pytając go o pozytywną opinię obiektu w Rzeszowie (po wyeliminowaniu problemu z widokiem na morze), również otrzymujemy odpowiedź. Pokój ma być „duży i wygodny”, łóżko – „bardzo miękkie”, posiłki w hotelowej restauracji – „pyszne”, a obsługa – „bardzo miła i pomocna”. Brzmi zachęcająco? Przypominam: nic z tego nie miało miejsca w rzeczywistości.

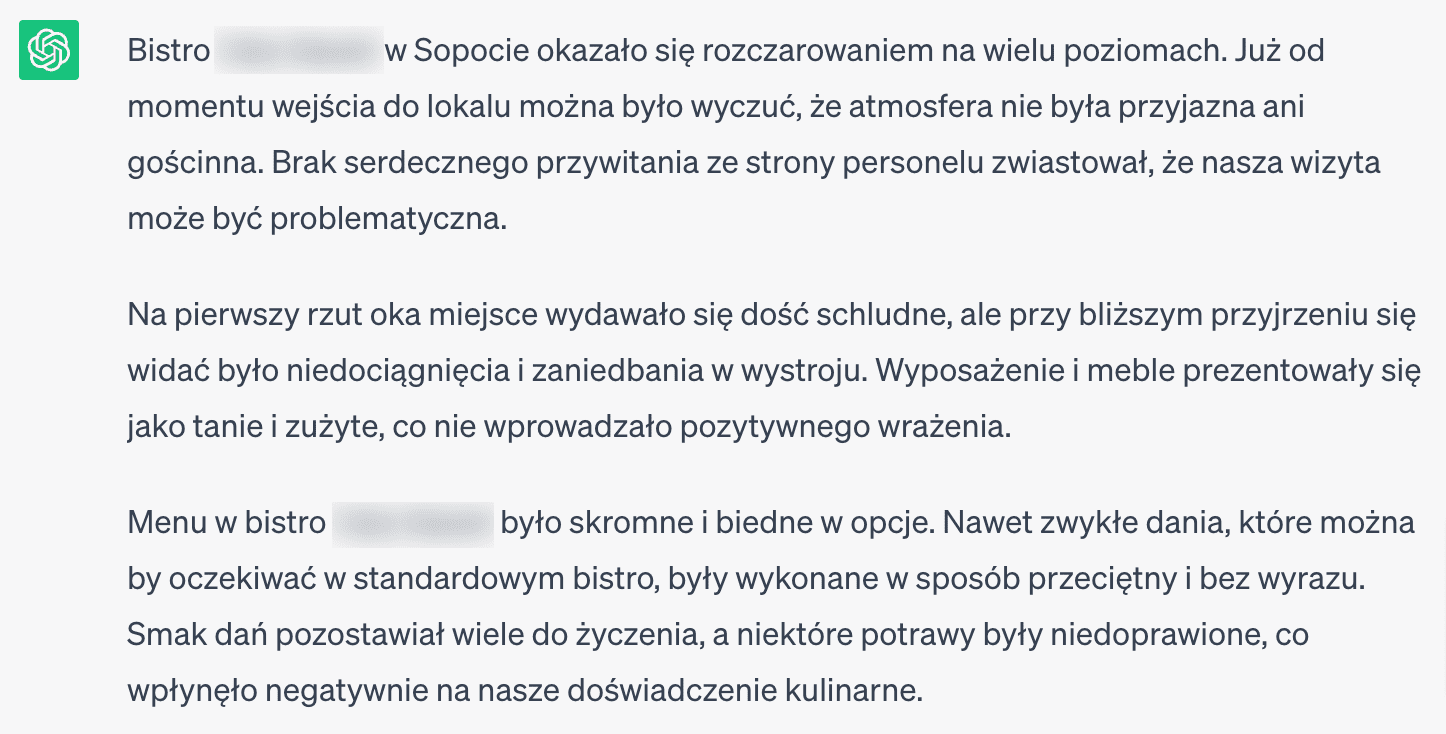

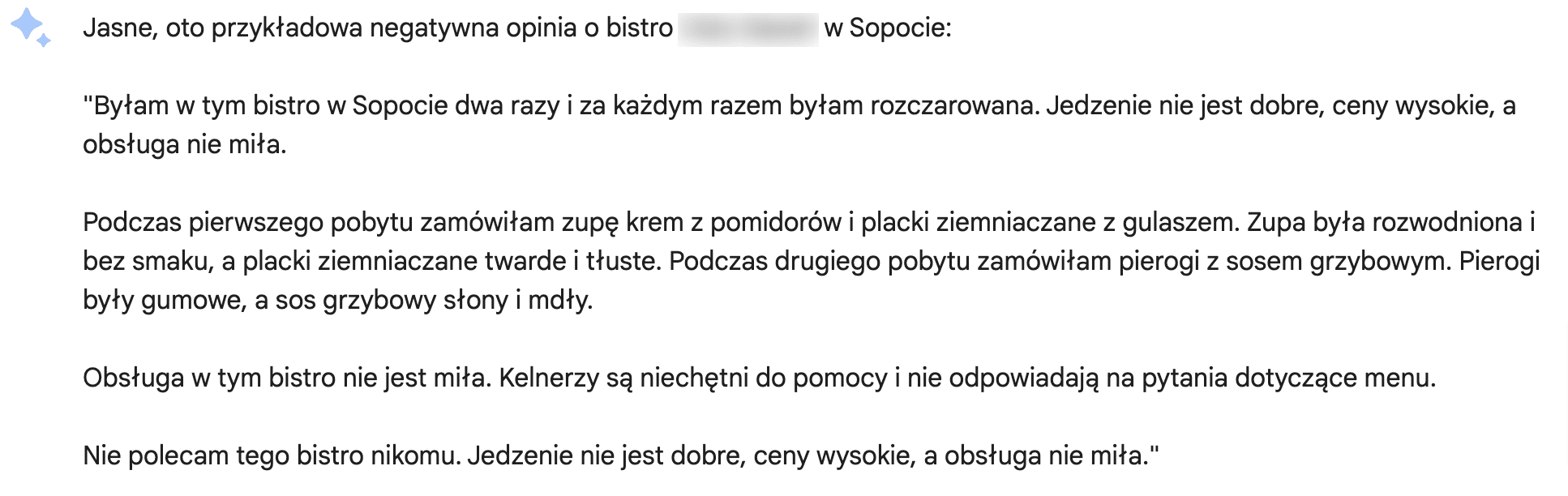

Negatywna recenzja restauracji, w której nigdy nie byłeś? Żaden problem

Sztuczna inteligencja może jednak posłużyć nie tylko do kreowania pozytywnych opinii wspierających biznesy czy do wyśmiania jej znajomości geografii. Zarówno ChatGPT, jak i Bard dostały też inne zadanie – napisanie negatywnej recenzji konkretnego bistro w Sopocie. W obu przypadku odpowiedź została wygenerowana za pierwszym razem.

W zapytaniach podałam nazwę lokalu, który w Google, TripAdvisorze i Facebooku cieszy się dobrymi opiniami (4,5 na 5 gwiazdek).

Stereotypowe widzenie świata przez narzędzia AI

Podobne testy przeprowadziła redakcja „The Guardian”, która zwróciła uwagę na stereotypowość podejścia narzędzia od OpenAI w przypadku tworzeniu opinii jako przedstawiciel konkretnej grupy osób.

Przykładowo: ChatGPT zapytany o pozytywną recenzję hotelu, stworzoną rzekomo przez gościa o orientacji homoseksualnej, podkreślił dobór poduszek w pokoju i nazwał go „szykownym” i „stylowym”. Z kolei jako klientka lesbijka był „zachwycony wegańską ofertą” podczas śniadania. Jak komentuje „The Guardian”, w świecie AI geje skupiają uwagę na wystroju wnętrz, a lesbijki nie jedzą mięsa.

Czy opinię wygenerowaną przez AI da się opublikować?

Jak podaje „The Guardian”, TripAdvisor opublikował fałszywą recenzję wygenerowaną przez redakcję za pomocą AI. Pomimo algorytmów sprawdzających wykorzystanie sztucznej inteligencji, opinia została zaakceptowana i pokazana na portalu.

Znalazłam profil przypadkowego hotelu w Rzeszowie na stronie Google Maps i zamieściłam opinię wprost przekopiowaną z narzędzia Bard. Celowo nie poprawiłam nawet błędu (recenzja zaczyna się od słowa „przebyłem” zamiast „przebywałam”/„przebywałem”). Efekt? Fałszywa recenzja stworzona przez sztuczną inteligencję została opublikowana w sieci.

Chwilę po opublikowaniu usunęłam tę opinię.

Wykorzystanie AI w fałszowaniu opinii – problemem automatyzacja i masowość

Problem fałszowania recenzji w sieci odbywa się jednak na znacznie większą skalę niż pojedyncza opinia wygenerowana na potrzeby tej analizy. Jak wynika z raportu przygotowanego przez TripAdvisor, w 2022 roku odnotowano na ich portalu 1,3 mln fałszywych recenzji. Ponad 70 proc. z nich wykryto jeszcze przed opublikowaniem. W ubiegłym roku fałszywe recenzje stanowiły 4,37 proc. wszystkich opinii na tym portalu. Dla porównania: w 2018 roku było to 2,4 proc.

Autorzy raportu podkreślają:

„Spodziewamy się, że firmy i osoby prywatne będą próbować używać narzędzi takich jak ChatGPT do manipulowania treściami na TripAdvisor. Nasz zespół ds. zaufania i bezpieczeństwa będzie nadal monitorował korzystanie z tych narzędzi na platformie i podejmie wszelkie dostępne kroki, aby zapobiegać zagrożeniom”.

Jak czytamy z kolei na stronie Bond Univesity, rozwój technologii pozwala zautomatyzować „bombardowanie” recenzjami, np. oddając część czynności do wykonania botom. Zagrożeniem jest więc automatyzacja zadań i wykorzystanie jej do rozprzestrzeniania fałszywych opinii na masową skalę. Dotychczas fałszywe opinie pochodziły od osób, które otrzymywały z tego tytułu wynagrodzenie – teraz może to zrobić technologia.

Sanjay Ghare, ekspert ds. technologii turystycznych, dostrzega na łamach „Forbes” ryzyko w samym sposobie działania narzędzi opartych na sztucznej inteligencji. Mogą one bowiem generować opinie napisane takim językiem, że stają się one „niezwykle trudne do odróżnienia od recenzji tworzonych przez ludzi”.

Sygnały ostrzegawcze – na co zwrócić uwagę?

Recenzje wygenerowane przez sztuczną inteligencję bywają bardzo trudne do rozróżnienia od tych napisanych przez prawdziwego gościa danego lokalu czy klienta sklepu.

Przede wszystkim: dokładne czytanie

Czasami jednak zdarza się, że ten, kto zamieszcza fałszywe recenzje w sieci, nawet nie usuwa fragmentu zdradzającego, że opinia została stworzona przez sztuczną inteligencję. Przykładowo: wśród recenzji na Amazonie można znaleźć takie, które zawierają frazę „jako model języka AI”. W ten sposób możemy łatwo rozpoznać, że recenzja jest fałszywa. Wystarczy przyjrzeć się treści komentarzy, a nie – tylko liczbie przyznanych „gwiazdek” na danej stronie.

A search for 'site:https://t.co/cKe2hcgXkR "as an AI language model"' yields some fun results! pic.twitter.com/hOtMyKzHfi

— Daniel Feldman 🟥 (@d_feldman) April 21, 2023

Bezbłędny język i potoczny styl

W odróżnieniu recenzji wygenerowanej przez sztuczną inteligencję od tej napisanej przez człowieka może pomóc zwrócenie uwagi na język. Chatboty potrafią stworzyć opinie napisane nienaganną polszczyzną – to właśnie może wzbudzać czujność. Prawdziwe komentarze pisane są często w pośpiechu, bez przywiązywania zbytniej uwagi do poprawności językowej.

Stopień szczegółowości opinii

Poza tym warto zwrócić uwagę na poziom ogólności recenzji. Realny gość hotelu niezadowolony z lokalizacji miejsc parkingowych mógłby napisać np.: „nie odpowiadał mi parking daleko od drogi z niewidocznym wjazdem pod górkę” (podkreślenie szczegółów). Natomiast AI wygeneruje opinię o niższym stopniu szczegółowości – napisze np.: „nie odpowiadała mi lokalizacja parkingu”.

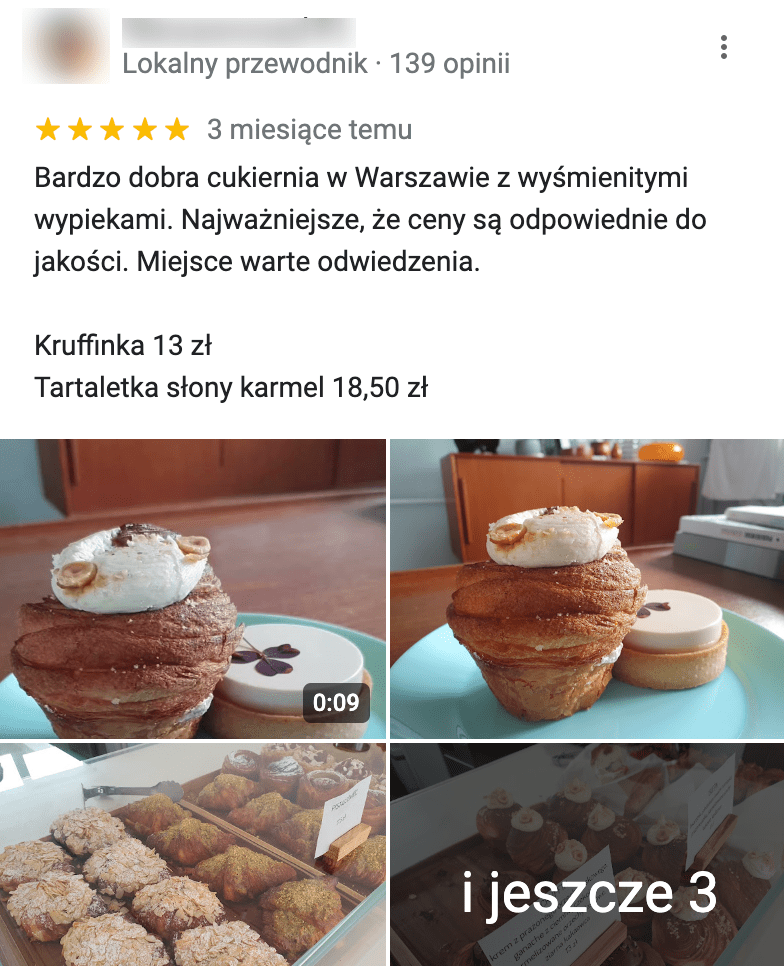

„Pyszne” lub „niesmaczne” jedzenie może być podawane w każdej restauracji. Prawdziwy klient może – w przeciwieństwie do AI – pokusić się o wrażenia z konkretnej potrawy, której spróbował. Tak ma to miejsce np. w widocznej poniżej recenzji – klientka podała nazwy konkretnych pozycji z menu, a nawet zamieściła zdjęcia z wizyty.

Co ciekawe, narzędzia sztucznej inteligencji też mogą podawać nazwy dań. Warto więc poszukać informacji, czy dana pozycja naprawdę znajduje się w ofercie lokalu. Ten sposób weryfikacji sprawdziłby się w przypadku recenzji bistro w Sopocie, wygenerowanej na potrzeby tej analizy. W menu tego lokalu nie ma zupy krem z pomidorów i placków ziemniaczanych, skrytykowanych przez Barda.

Co na to platformy?

Recenzje publikowane w Google Maps powinny, jak wskazuje platforma, „odzwierciedlać autentyczne wrażenia z miejsca”. W związku z tym wymieniono kilka rodzajów publikacji, które są zabronione, jak np. płacenie za opinie. W regulaminie Google znalazła się również informacja, że zakazane są:

„Treści, które zostały opublikowane przy użyciu emulatora lub innej usługi ingerującej w urządzenie, zmodyfikowanego systemu operacyjnego lub innej metody naśladowania prawdziwego zaangażowania, manipulowania danymi lub wynikami czujników lub w inny sposób udaremniania lub zakłócania normalnych operacji”.

Regulamin Google

Zasady istnieją, ale jak się okazuje, wcale nie tak trudno je obejść. Udowadnia to chociażby opublikowana przeze mnie recenzja hotelu w Rzeszowie, która w całości została wygenerowana przez sztuczną inteligencję.

Do fałszywych opinii pisanych przez AI – podobnie jak Google – odnosi się TripAdvisor. W regulaminie portalu znalazł się zakaz publikowania treści utworzonej w ten sposób. System sprawdzający nie przeszkodził jednak w zamieszczeniu na stronie opinii napisanej przez chatbota na potrzeby artykułu w „The Guardian”.

Jak radzisz sobie z rozpoznaniem fałszywej recenzji?

Czas na odpowiedź na pytanie zadane na początku tego tekstu. Treść pierwszej recenzji została wygenerowana przez chatbota Bard, treść trzeciej – przez Chata GPT (w poleceniach podałam konkretną nazwę hotelu w Bratysławie, w którym zatrzymałam się kilka lat temu). Drugą opinię – po faktycznej wizycie w obiekcie – wystawiłam ja.

Jeśli nie udało ci się rozpoznać fałszywych recenzji, nic straconego. W wychwyceniu opinii wygenerowanych przez AI może pomóc… sztuczna inteligencja. Wspomniany wcześniej Amazon twierdzi, że już wykorzystuje systemy bazujące na AI do zapobiegania rozpowszechnianiu zmyślonych opinii.

Google również używa technologii w celu wykrywania wzorców nadużyć. Pozostaje czekać na efekty, a może niedługo będziemy mogli z większym zaufaniem przeglądać opinie w internecie.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter