Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

Głos wygenerowany przez AI. Eksperymenty niosące zagrożenie

Generatywna AI budzi dzisiaj wiele dyskusji i kontrowersji. Oprócz kwestii związanych m.in. z prawami autorskimi istotną sprawą jest również generowanie głosu – zwłaszcza w przypadku osób publicznych, co już dzisiaj wykorzystują oszuści do osiągania swoich celów.

fot. Pexels / Modyfikacje: Demagog

Głos wygenerowany przez AI. Eksperymenty niosące zagrożenie

Generatywna AI budzi dzisiaj wiele dyskusji i kontrowersji. Oprócz kwestii związanych m.in. z prawami autorskimi istotną sprawą jest również generowanie głosu – zwłaszcza w przypadku osób publicznych, co już dzisiaj wykorzystują oszuści do osiągania swoich celów.

O eksperymentach związanych z modyfikacją i tworzeniem nagrań ludzkiego głosu mówiło się [1, 2] już w pierwszej dekadzie XXI wieku. Niestety, o tym temacie nie mówiło się najgłośniej w kontekście naukowym czy technologicznym. Po dwóch dekadach problem manipulacji ludzkim głosem stał się poważny ze względu na rozwój sztucznej inteligencji.

USA: prezydent zniechęcający do głosowania w prawyborach

Opracowanie i udostępnienie publice narzędzi umożliwiających klonowanie głosu na początku lat 20. sprawiło, że wybuchło zainteresowanie generacją fałszywych wypowiedzi. Dlaczego? Jeżeli ktoś chce usłyszeć ulubioną postać wypowiadającą daną kwestię, to przy odrobinie wysiłku nie musi nic za to płacić.

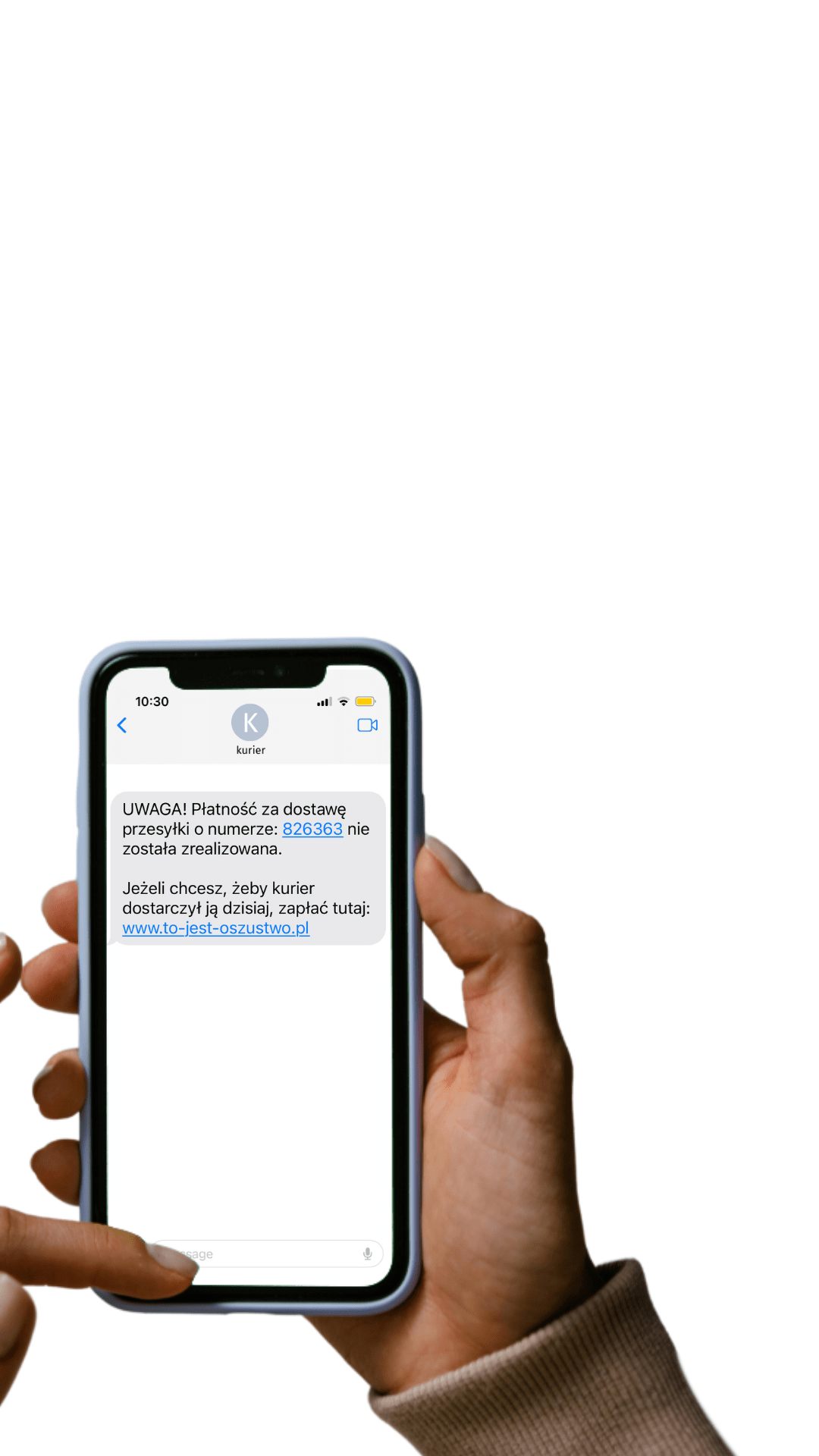

Korzystają na tym również oszuści – i to na niespotykaną dotąd skalę. Wbrew pozorom niesławne telefony reklamujące instalacje fotowoltaiczne nie wykorzystywały głosu wygenerowanego przez AI [1, 2]. Za to w ten sposób działał na przykład Amerykanin, który na początku tego roku sklonował głos prezydenta Joe Bidena, a następnie wykorzystał stworzone nagrania do zniechęcania mieszkańców do głosowania w prawyborach, które odbywały się w stanie New Hampshire.

Pod koniec maja FCC (pl. Federalna Komisja Łączności) nałożyła karę na doradcę politycznego odpowiedzialnego za cały proceder z powodu spoofingu. Pieniądze musiał również zapłacić operator VoIP (ang. Voice over Internet Protocol, czyli telefonia internetowa) za brak weryfikacji informacji podawanych przez dzwoniącego w momencie wykonywania połączenia.

Wielka Brytania: politycy wysadzają domy w grach

Nie tylko oszuści wykorzystują sztuczną inteligencję w kontekście politycznym. W połowie czerwca na platformie X (dawniej Twitter) pojawił się film, który rzekomo ukazywał brytyjskiego polityka Nigela Farage’a grającego w Minecrafta.

🚨NEW | Reform UK launch brand new electoral broadcast 👇 pic.twitter.com/S8DtRcxAL7

— Irish Patriot 🇮🇪 (@IrishPatri0t) June 17, 2024

W nagraniu, które oprócz głosu wygenerowanego przez AI wykorzystuje także zmanipulowany materiał wideo z politykiem z dopasowanym ruchem warg, Farage rzekomo wysadza dom zbudowany w grze brytyjski przez premiera Rishi Sunaka. Większość odbiorców portalu odebrała ten materiał jako żart; część komentujących zwróciła jednak uwagę na to, że wygenerowany głos Farage’a był bardzo podobny do autentycznego głosu polityka.

Polska: zamiast gier politycznych – oszustwa inwestycyjne

W Polsce w ramach tego typu incydentów wykorzystuje się wizerunek osób publicznych, jednak nie chodzi w nich o działania polityczne. W zdecydowanej większości przypadków z możliwości oferowanych przez klonowanie głosu korzystają oszuści, głównie reklamujący fałszywe inwestycje. W listopadzie 2023 roku w serwisie X poruszenie wywołało nagranie byłego prezydenta Aleksandra Kwaśniewskiego.

Scam wchodzi na wyższy poziom i korzysta z generatora głosu AI. pic.twitter.com/vezMmRe4e5

— Marian Baczał 🇵🇱🇱🇦 (@marian_baczal) November 2, 2023

Problem polegał na tym, że wygenerowany głos byłego prezydenta namawiał do inwestowania środków pieniężnych, co można było rozpoznać chociażby w postaci dołączonego pytania „Jak uniknąć płacenia za energię w 2023 roku w Polsce?”. Na szczęście, spora część komentujących szybko zauważyła, że „głos” Kwaśniewskiego nie brzmi tak. jak jego rzeczywista wersja.

Powyższe przykłady nie oznaczają oczywiście, że określone państwo ma lepszą lub gorszą ochronę przed wykorzystaniem wypowiedzi znanych osób, wygenerowanych przez AI do niewłaściwych celów. Sytuacja może się zmienić o 180 stopni.

Przykładowo: brytyjskie żarty o wysadzaniu domów w grze czy oszustwa inwestycyjne w Polsce mogą przeistoczyć się w generowanie perfekcyjnych materiałów zniesławiających przeciwników politycznych. Z kolei udowodnienie, że było inaczej, może być bardzo trudne w przypadku materiałów powstałych z pomocą sztucznej inteligencji.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter