Analiza

Omawiamy ważne fakty dla debaty publicznej, a także przedstawiamy istotne raporty i badania.

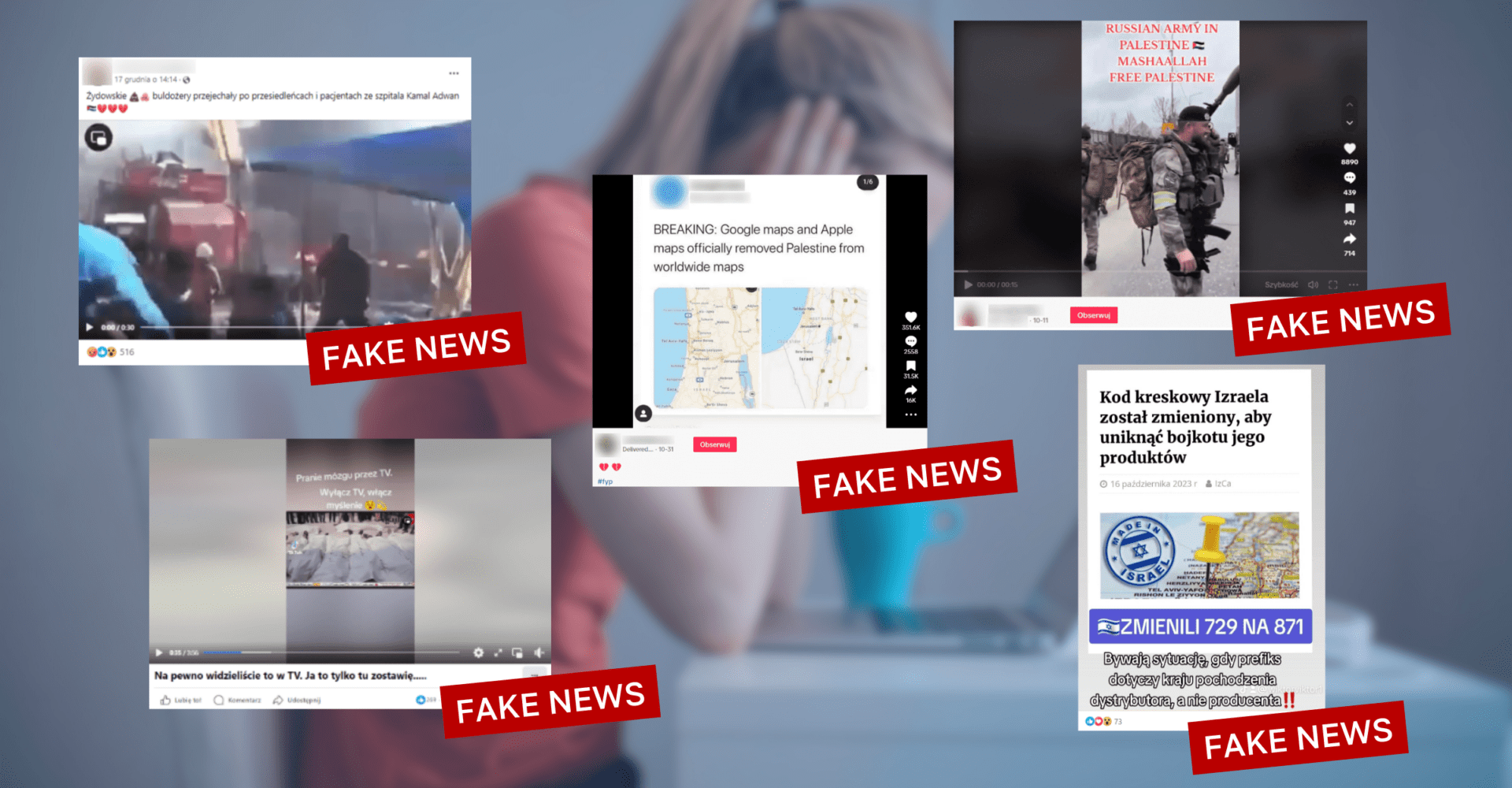

Raport BOOM: fałszywe treści o wojnie Izrael-Hamas

„Fałszywe/wprowadzające w błąd twierdzenia popierające Izrael dominowały i stanowiły 44% [zanalizowanych fałszywych treści, przyp. Demagog], tuż za nimi plasowały się twierdzenia popierające Palestynę (38%)” – do takich wniosków doszła indyjska organizacja BOOM w swoim raporcie. Czy fałszywe treści, które docierają do tego kraju, są inne niż te w Europie?

fot. Facebook, TikTok i Pexels / Modyfikacje: Demagog

Raport BOOM: fałszywe treści o wojnie Izrael-Hamas

„Fałszywe/wprowadzające w błąd twierdzenia popierające Izrael dominowały i stanowiły 44% [zanalizowanych fałszywych treści, przyp. Demagog], tuż za nimi plasowały się twierdzenia popierające Palestynę (38%)” – do takich wniosków doszła indyjska organizacja BOOM w swoim raporcie. Czy fałszywe treści, które docierają do tego kraju, są inne niż te w Europie?

Od 7 października 2023 roku obserwujemy w sieci znaczący wzrost liczby fałszywych treści dotyczących Izraela i Palestyny. Tego dnia Hamas zaatakował Izrael, który odpowiedział nalotami, a później naziemnym wejściem wojska do Strefy Gazy.

Opisywaliśmy już kilka raportów Europejskiego Obserwatorium Mediów Cyfrowych (EDMO), które dotyczyły infosfery europejskiej (1, 2). Pod koniec ubiegłego roku redakcja BOOM opublikowała analizę 100 materiałów, które pojawiły się w przestrzeni informacyjnej.

Fałszywe treści: propalestyńskie czy proizraelskie?

Jak podają analitycy, część fałszywych treści można podzielić na takie, które wyraźnie opowiadają się po stronie izraelskiej albo palestyńskiej. Według ich oceny różnica nie jest duża:

- proizraelskie: 44 proc.,

- propalestyńskie: 38 proc.,

- neutralne: 17 proc.

Jedno twierdzenie ze sprawdzanych podane było w kontekście popierającym Hamas.

Treści przeanalizowano również pod kątem tego, kto był ich celem:

- Palestyńczycy: 27 proc.,

- Hamas: 21 proc.,

- Izraelczycy: 16 proc.,

- muzułmanie: 2 proc.,

- dziennikarze: 2 proc.

Treści propalestyńskie częściej opierały się na wzbudzeniu sensacji

Jak wynika z danych, fałszywe treści – zarówno propalestyńskie, jak i proizraelskie – wykorzystywały sensacyjny ton, który miał wzbudzić w odbiorcach silne emocje. W treściach wspierających stronę palestyńską pojawiło się 11 twierdzeń tego typu, a więc więcej niż w kontekście proizraelskim (8 twierdzeń).

Kolejną kategorią, w której pojawiło się najwięcej propalestyńskich fałszywych treści, była dezinformacja wiążąca z wojną konkretne osoby publiczne i różne światowe organizacje (8 twierdzeń).

Najczęściej powtarzającymi się słowami w tych treściach były „dzieci”, „bombardowania” i „wojna”.

Wiele treści proizraelskich odnosiło się do tzw. Pallywood

Wśród treści proizraelskich najczęściej pojawiała się teza o tzw. Pallywood (połączenie słów Palestyna i Hollywood). To termin odnoszący się do rzekomego produkowania przez Gazańczyków inscenizowanych nagrań, na których mają udawać ofiary izraelskiej przemocy. Takie fałszywe treści mają na celu umniejszenie lub całkowite podważenie krzywdy Palestyńczyków. Warto dodać, że jedno nagranie miało rzekomo przedstawiać sytuację odwrotną, w której to Izraelczycy mieli udawać ofiary zamachu Hamasu.

Tezy o „Pallywood” pojawiły się również w Europie, o czym pisaliśmy w naszej analizie. W Indiach do tego tematu odnosiło się 13 ze 100 sprawdzanych przez BOOM twierdzeń.

Na drugim miejscu, obok treści wykorzystujących sensacyjny ton (8 przykładów), uplasowały się twierdzenia o charakterze islamofobicznym.

W tych treściach najczęściej pojawiającymi się słowami (z pominięciem tych, które powtarzają się często w obu narracjach) są „terroryści”, „islamski” i „dziecko”. Na grafie dołączonym do raportu widzimy, że często używane są również słowa „propaganda” i „niewinny”.

„Recykling treści”: jak Syria „odgrywa” Gazę

Zdarza się, że autorzy fałszywych treści w celu uwiarygodnienia przekazu wykorzystują w swoich postach nagrania lub zdjęcia niezwiązane z opisywanymi wydarzeniami – i nie jest to rzadkie zjawisko. W Demagogu wielokrotnie opisywaliśmy takie przypadki w kontekście różnych tematów, takich jak pandemia COVID-19 czy wojna w Ukrainie.

Nie inaczej jest w przypadku wojny w Gazie. 56 proc. przeanalizowanych przez organizację BOOM tez zostało zilustrowanych przez nieaktualne i wyrwane z prawidłowego kontekstu materiały. Jako przykład autorzy podali nakręcone w 2016 roku drastyczne wideo, w którym przedstawiono syryjskich rebeliantów dekapitujących chłopca. Inny materiał prezentował indonezyjski rytuał, który został błędnie opisany jako palestyńskie ofiary izraelskich ataków.

Podobny film analizowaliśmy w Demagogu. W tym przypadku błędnie opisano nagranie z 2013 roku, zrobione podczas protestu studentów z uniwersytetu w Kairze.

Sensacyjny ton i drastyczne treści

Jak możemy przeczytać w raporcie BOOM, celem 27 proc. przeanalizowanych tez było „wyłącznie wywołanie sensacji na temat wojny przy użyciu fałszywych/wprowadzających w błąd informacji”. W 24 proc. twierdzeń do stworzenia takich treści wykorzystano drastyczne materiały. Jako przykład podano filmy z egzekucji więźniów czy dekapitacji dzieci.

Kto wprowadza w błąd? Zweryfikowane konta na X

Raport zwraca uwagę na to, że na X (dawniej Twitter) 64 proc. sprawdzanych tez pojawiło się na przynajmniej jednym koncie z tzw. „niebieskiem znaczkiem”, który sygnalizuje, że właściciel wykupił subskrypcję na platformie. 13 proc. twierdzeń udostępniły osoby publiczne związane z rządem lub inną organizacją.

Gry wideo jako materiał do fałszywych treści

Podobnie jak w Europie, również w Indiach pojawiły się fałszywe treści, które wykorzystywały fragmenty z gier wideo (8 proc.). Chodziło m.in. o grę taktyczną Arma 3 – nagranie przedstawiono jako relację z wojny w Gazie.

W raporcie odnotowano również przypadki fake newsów, które wykorzystywały materiały w całości wygenerowane przez sztuczną inteligencję (4 proc.) oraz za pomocą technologii deepfake (2 proc.), dzięki której można modyfikować istniejące już nagrania. Jednym z podanych przykładów było zdjęcie kibiców Atletico Madrid, którzy mieli rozłożyć na trybunach ogromną flagę Palestyny.

Podsumowanie: podobne treści, podobne taktyki

Jeśli porównamy analizę redakcji BOOM z raportami EDMO, znajdziemy pewne punkty wspólne. Europejskie dane z ostatnich miesięcy wskazują na to, że fałszywe treści rozprowadzane pod szyldem „Pallywood” były popularne w listopadzie 2023 roku.

Pojawiły się też treści polaryzujące oraz przykłady konkretnych tez (flaga Palestyny na trybunach czy zestrzelenie helikopterów przez Hamas), które znalazły się w europejskiej i indyjskiej przestrzeni informacyjnej. Fałszywe treści roznoszą się ponad granicami państw i nie potrzebują do tego wiele czasu.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter