Analiza

Omawiamy ważne fakty dla debaty publicznej, a także przedstawiamy istotne raporty i badania.

Sztuczna inteligencja i dezinformacja. Co je łączy?

Kampanie dezinformacyjne stały się stałym elementem globalnej przestrzeni informacyjnej. Przyczynił się do tego rozwój sztucznej inteligencji, przede wszystkim wygenerowanych zdjęć i deepfake’ów. Rozpowszechnianie fake newsów stało się lukratywnym biznesem. Niektóre rządy zatrudniają firmy, których zadaniem jest poprawa wizerunku kraju lub polaryzowanie społeczeństw w innych państwach.

fot. Pexels / Modyfikacje: Demagog

Sztuczna inteligencja i dezinformacja. Co je łączy?

Kampanie dezinformacyjne stały się stałym elementem globalnej przestrzeni informacyjnej. Przyczynił się do tego rozwój sztucznej inteligencji, przede wszystkim wygenerowanych zdjęć i deepfake’ów. Rozpowszechnianie fake newsów stało się lukratywnym biznesem. Niektóre rządy zatrudniają firmy, których zadaniem jest poprawa wizerunku kraju lub polaryzowanie społeczeństw w innych państwach.

Na początku października amerykańska organizacja pozarządowa Freedom House opublikowała raport dotyczący wpływu sztucznej inteligencji (AI) na treści w internecie. Nie płyną z niego pozytywne wnioski.

AI jest coraz częściej wykorzystywana w kampaniach dezinformacyjnych. Jednym z głównych problemów jest rosnąca liczba deepfake’ów. Deepfake to sztucznie wygenerowane wideo przedstawiające osobę wypowiadającą słowa, które nigdy z jej ust nie padły. Równie niebezpieczne są sfabrykowane zdjęcia przedstawiające sytuacje, które nigdy nie miały miejsca.

Analitycy z Freedom House odkryli, że narzędzia oparte na sztucznej inteligencji, które mogą generować obrazy, tekst lub dźwięk, były wykorzystywane w celach dezinformacyjnych w co najmniej 16 krajach.

Deepfake i brudna polityka

W czerwcu w Stanach Zjednoczonych deepfake’ami posłużył się Ron DeSantis, gubernator Florydy. Polityk rywalizuje z Donaldem Trumpem o nominację Partii Republikańskiej w przyszłorocznych wyborach prezydenckich.

DeSantis opublikował filmik ze sfabrykowanymi zdjęciami, które przedstawiały Trumpa obejmującego i całującego dr. Anthony’ego Fauciego – lekarza i doradcę prezydentów USA, wielokrotnie atakowanego przez przeciwników ograniczeń podczas pandemii COVID-19. Wiarygodność Fauciego jeszcze jako prezydent podważał również sam Trump, dlatego fałszywe zdjęcia opublikowane przez DeSantisa miały podkopać jego wiarygodność.

Donald Trump became a household name by FIRING countless people *on television*

But when it came to Fauci… pic.twitter.com/7Lxwf75NQm

— DeSantis War Room 🐊 (@DeSantisWarRoom) June 5, 2023

Wcześniej, w lutym 2023 roku, w amerykańskich mediach społecznościowych krążył zmanipulowany film przedstawiający prezydenta Joe Bidena wypowiadającego transfobiczne komentarze.

Również w Polsce mieliśmy do czynienia z deepfake’ami przedstawiającymi polityków. Przykłady znajdziesz w jednej z naszych analiz.

AI w służbie władz, czyli sposób na poprawę wizerunku rządu

Po deepfake’i zaczynają również sięgać władze niektórych krajów. Na początku 2023 roku wenezuelskie media państwowe rozpowszechniały na portalach społecznościowych filmy przedstawiające prezenterów z nieistniejącego międzynarodowego anglojęzycznego kanału. Filmy zawierały treści prorządowe.

Jak się okazuje, firma odpowiedzialna za produkcję nagrań (Synthesia) ma powiązania z kampanią internetową wspierającą Komunistyczną Partię Chin w Stanach Zjednoczonych.

Nie tylko deepfake. Jak AI wspiera państwową cenzurę

Rządy wykorzystują AI nie tylko do manipulowania informacjami, ale też do cenzurowania treści w internecie. Taka sytuacja ma miejsce chociażby w Rosji, gdzie za rządowe pieniądze powstał system blokujący przekazy krytyczne wobec inwazji na Ukrainę. Cenzura dotyczy też treści wspierających osoby LGBT+.

Podobne represje panują w Białorusi: reżim Aleksandra Łukaszenki zablokował w ostatnim czasie ponad 9 tys. stron internetowych, w tym niezależne serwisy informacyjne i media prowadzone przez dziennikarzy pracujących na emigracji.

Internet areną wojny informacyjnej

Deepfake czy wygenerowane zdjęcia to ekstremalne przykłady dezinformacji. W rozpowszechnianiu fake newsów ważną rolę odgrywają też boty oraz tzw. trolle. O ile boty również opierają się na sztucznej inteligencji, tak trollami są prawdziwi użytkownicy publikujący w sieci nieprawdziwe lub polaryzujące treści. Często robią to na zlecenie rządów.

Według badań Freedom House w co najmniej 47 krajach pracują komentatorzy, którzy manipulują informacjami w internecie. Takich państw jest dziś dwukrotnie więcej niż dziesięć lat temu.

W tym czasie powstał cały rynek usług polegających na manipulacji treścią. Firmy prowadzące taką działalność są wynajmowane przez rządy na zasadach outsourcingu. W ten sposób władze mogą łatwo zaprzeczyć, że mają cokolwiek wspólnego z akcjami dezinformacyjnymi. Trudniej jest też ustalić właściwego zleceniodawcę.

Trolling po rosyjsku

Jednym z najjaskrawszych przykładów kraju, który korzysta z usług manipulowania informacjami w internecie, jest Rosja. Po inwazji na Ukrainę internet wypełnił się treściami uzasadniającymi napaść i dyskredytującymi Ukraińców oraz Zachód. Twórcy takich materiałów są wspierani przez Kreml.

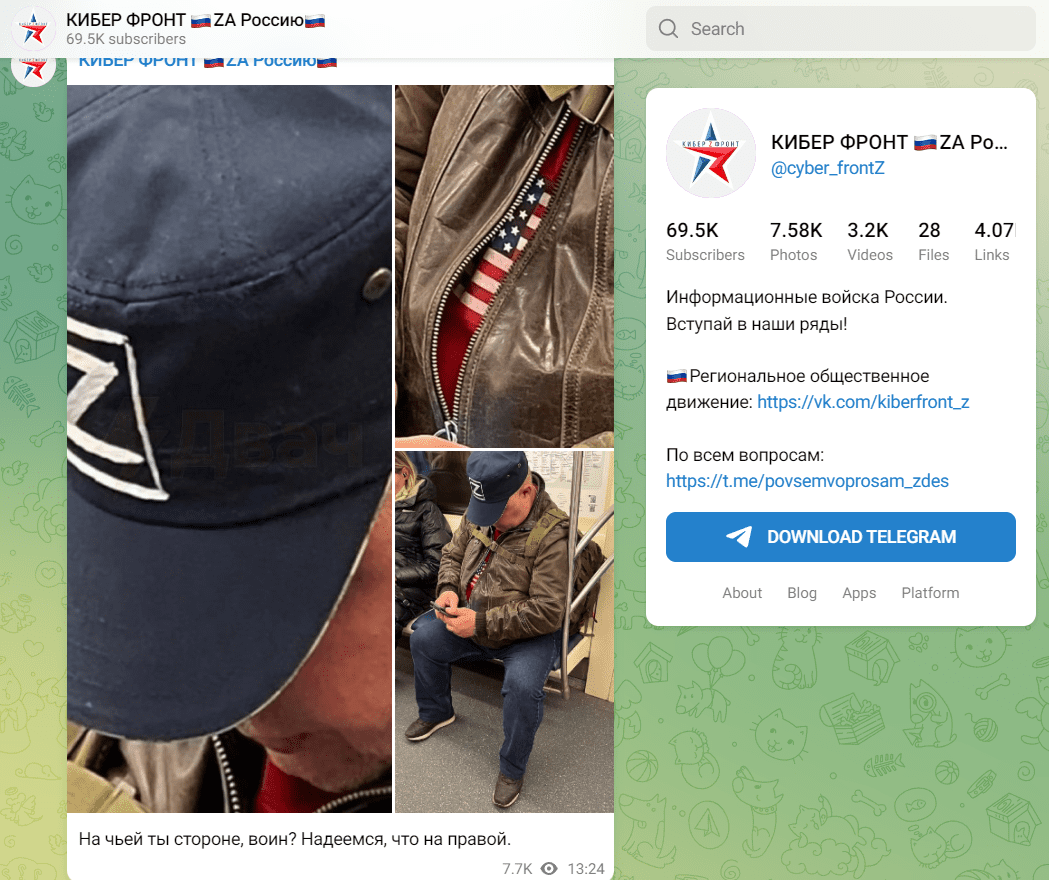

Fałszywe treści rozpowszechnia m.in. sieć Cyber Front Z. Jak ustalił rosyjski portal Fontanka, osoby zatrudnione w niej jako trolle muszą publikować dziennie 200 komentarzy. Wynagrodzenie wynosi 45 tys. rubli miesięcznie. Według aktualnego kursu to około 2 tys. zł.

Przykład polaryzującego wpisu na Telegramie Cyber Front Z. Treść posta głosi: „Po której stronie jesteś, wojowniku? Mamy nadzieję, że po właściwej”. Fot. Telegram / @cyber_frontZ

Innym przykładem prorosyjskich działań w sieci była akcja „Doppelgänger” z 2022 roku. Polegała ona na stworzeniu wizualnych kopii (tzw. strony lustrzane) co najmniej 17 europejskich portali newsowych i publikowaniu na nich materiałów zawierających fałszywe informacje. W efekcie powstały „klony” m.in. niemieckiego „Bilda” czy brytyjskiego „Guardiana”.

Dezinformacja i polaryzacja

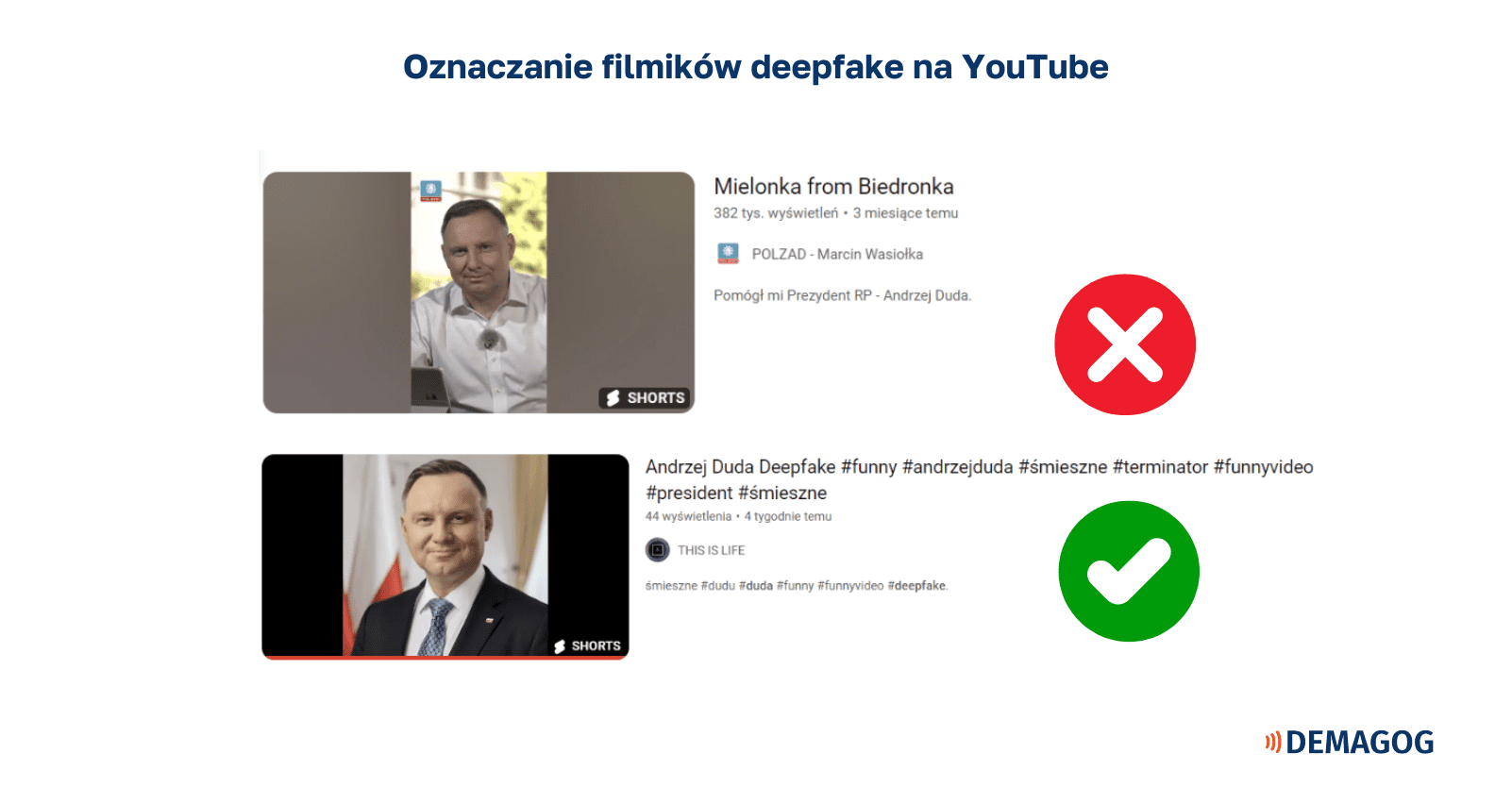

Treści generowane przez AI są niezwykle trudne do wychwycenia. Wynika to przede wszystkim z faktu, że wiele platform społecznościowych nie wymaga oznaczania tego typu treści lub nie egzekwuje skutecznie własnych regulaminów.

Fałszywe obrazy i filmy stają się w efekcie potężnym narzędziem w rękach grup manipulujących informacjami w internecie.

„Obrazy generowane przez sztuczną inteligencję, które wywołują sensację oburzenia na wywołujące podziały tematy, mogą utrwalić polaryzację i inne istniejące napięcia w społeczeństwie. W skrajnych przypadkach może to pobudzić przemoc wobec pojedynczych osób lub całych społeczności” – alarmują autorzy raportu Freedom House.

Deepfake staje się łatwą wymówką. Uwaga również na taką dezinformację

Coraz większe wymieszanie informacji prawdziwych i fałszywych utrudnia weryfikowanie treści. Z jednej strony mamy faktyczne deepfake’i oraz wygenerowane zdjęcia, których celem jest dezinformacja. Z drugiej strony, ponieważ produkty AI wciąż są trudne do rozpoznania, wiele osób może chcieć wykorzystać argument o rzekomym deepfake’u do odsunięcia od siebie oskarżeń.

Przykładowo w kwietniu 2023 roku w Indiach wyciekły nagrania, na których lokalny polityk związany z rządzącą stanem partią dyskredytuje innych członków ugrupowania. Działacz bronił się, że nagrania zostały wygenerowane przez sztuczną inteligencję. Niezależni badacze ustalili jednak, że co najmniej jedno z nich było autentyczne.

Nie możemy dłużej ignorować wpływu AI na treści w internecie

Skoro już nawet rządy instrumentalnie wykorzystują sztuczną inteligencję, użytkownicy coraz częściej mogą ulegać przekonaniu, że nikomu nie można wierzyć. To może popychać wiele osób w stronę środowisk promujących skrajne dezinformacje lub teorie spiskowe, co tylko nakręca błędne koło.

Dlatego sztuczna inteligencja wymaga pilnego uregulowania. Wygenerowane przez nią treści powinny być wyraźnie oznaczane w sieci (niedawno taką funkcję wprowadził TikTok), platformy społecznościowe powinny w większym stopniu promować wiarygodne treści, a państwa powinny zadbać o lepszą edukację w zakresie weryfikowania informacji. W przeciwnym wypadku zagrożenia dla wolności słowa i dostępu do informacji będą się tylko pogłębiać.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter