Artykuł

Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

Test 4 narzędzi do weryfikacji obrazów AI. Które jest najlepsze?

W ciągu ostatniego roku generatory grafik, które wykorzystują sztuczną inteligencję (AI), przeszły szybką ewolucję od nowinek technologicznych aż po imponujące narzędzia umożliwiające stworzenie dość wiarygodnych obrazów. W niektórych przypadkach – nawet takich, które wyglądają niemal jak fotografie i na pierwszy rzut oka są nie do odróżnienia. Nietrudno było przewidzieć, że w niedługim czasie pojawią się też narzędzia, które ułatwią i przyśpieszą rozpoznanie obrazów sztucznie stworzonych.

fot. pixabay / geralt / Modyfikacje: Demagog

Test 4 narzędzi do weryfikacji obrazów AI. Które jest najlepsze?

W ciągu ostatniego roku generatory grafik, które wykorzystują sztuczną inteligencję (AI), przeszły szybką ewolucję od nowinek technologicznych aż po imponujące narzędzia umożliwiające stworzenie dość wiarygodnych obrazów. W niektórych przypadkach – nawet takich, które wyglądają niemal jak fotografie i na pierwszy rzut oka są nie do odróżnienia. Nietrudno było przewidzieć, że w niedługim czasie pojawią się też narzędzia, które ułatwią i przyśpieszą rozpoznanie obrazów sztucznie stworzonych.

Obecnie na rynku działa kilka darmowych rozwiązań, które pomagają ocenić, czy obraz został wygenerowany dzięki AI. Są to m.in.:

Zasady testu – jak oceniliśmy skuteczność narzędzi do weryfikacji?

W ramach testu przyjrzeliśmy się powyższym narzędziom i sprawdziliśmy je pod kątem skuteczności wykrywania wpływu sztucznej inteligencji. Podjęliśmy próbę odpowiedzi na następujące pytania: Jak używa się tych narzędzi i czy są intuicyjne w obsłudze oraz w działaniu? Które z tych narzędzi było w ramach testu najlepsze w weryfikacji obrazów?

Test ma odzwierciedlać próby użytkownika, który chciałby sprawdzić wiarygodność 6 wybranych obrazów prawdziwych i wygenerowanych, o różnej specyfice i z ewentualnymi modyfikacjami. Każdy z nich przedstawia różne zdarzenia, osoby lub obiekty:

- prawdziwe zdjęcie – samolot na niebie,

- prawdziwe zdjęcie z doklejonym obiektem – wypadek,

- obraz wygenerowany przez sztuczną inteligencję – czołg w błocie,

- obraz wygenerowany przez sztuczną inteligencję z doklejonym obiektem – karetki na sygnale.

Oprócz tworzenia grafik na podstawie tysięcy zdjęć znalezionych w sieci Midjourney zapewnia też możliwość wgrania wybranego przez nas obrazu i stworzenia – na jego podstawie – nowego. Z tego powodu do testów włączono też:

- obraz wygenerowany przez sztuczną inteligencję na podstawie prawdziwego zdjęcia – zestawienie sylwetek różnych mężczyzn,

- obraz wygenerowany przez sztuczną inteligencję na podstawie innego wygenerowanego obrazu – zestawienie obrazów z czterema mężczyznami.

Test został przeprowadzony 10 sierpnia 2023 roku – co ma znaczenie pod kątem ewentualnych aktualizacji sprawdzanych narzędzi. Każdy z 6 obrazów został przetestowany po 3 razy (w sumie 18 prób) na każdej z podanych wyżej stron. W ten sposób na wszelki wypadek sprawdzaliśmy, czy ten sam obraz może wiązać się z rozbieżnymi wynikami, czy też wyniki są powtarzalne.

Niniejszy test może dawać ogólny pogląd co do działania narzędzi do weryfikacji obrazów AI, ale trzeba pamiętać, że ma on swoje ograniczenia, m.in. w postaci doboru próby, a także odmiennych sposobów działania każdego narzędzia, przez co w niektórych przypadkach trudno jest je porównać. Zawsze koncentrowaliśmy się na darmowej i publicznie dostępnej wersji wybranych narzędzi (nawet jeżeli strona oferowała udoskonalone pakiety za opłatą). W dodatku do testów użyto wygenerowanych grafik z tylko jednego generatora – Midjourney.

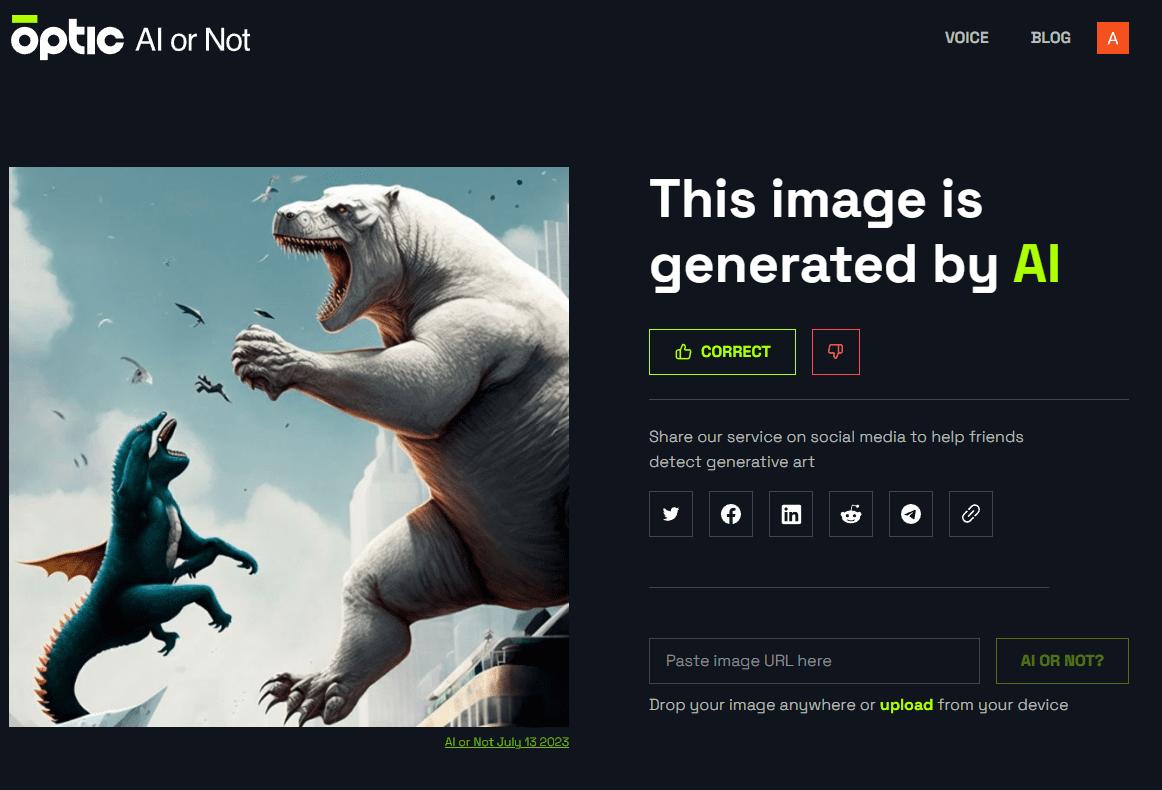

AI or Not – zgadnie, nie zgadnie, a może wcale nie odpowie?

Internetowa strona www.aiornot.com od firmy Optic wita nas przejrzystym interfejsem. By ocenić wiarygodność obrazu, wystarczy wgrać plik zapisany na dysku lub przesłać adres do grafiki na stronie. Zgodnie z opisem, zawartym na stronie Optic AI or Not, narzędzie: „wykorzystuje zaawansowane algorytmy i techniki uczenia maszynowego do analizy obrazów i wykrywania oznak generowania sztucznej inteligencji”.

Narzędzie może wydać następujące komunikaty: „this image is generated by human” (tłum. ten obraz został stworzony przez człowieka), „this image is generated by AI” (tłum. ten obraz został wygenerowany przez AI) oraz gdy narzędzie nie ma pewności co do obrazu: „in this case we can’t really say if it’s AI or not” (tłum. w tym przypadku nie możemy powiedzieć czy to AI, czy nie).

Jak dobrze AI or Not poradził sobie z naszymi obrazami?

Prawdziwe zdjęcie, które przedstawiało samolot, zostało prawidłowo ocenione jako stworzone przez człowieka. Narzędzie było równie skuteczne, gdy wgraliśmy do niego prawdziwe zdjęcie wypadku z doklejonym obiektem – to również oceniono trafnie jako stworzone przez człowieka.

W przypadku wygenerowanego obrazu, który przedstawiał czołg, narzędzie także udzieliło dobrej odpowiedzi, oceniając, że obraz został stworzony przez AI. Jednak, gdy użyliśmy wygenerowanego obrazu z doklejonym obiektem, który przedstawiał karetki na sygnale, to narzędzie podało błędną odpowiedź i nie wykryło ingerencji sztucznej inteligencji.

Gdy narzędzie otrzymało obraz wygenerowany na podstawie prawdziwego zdjęcia z sylwetkami mężczyzn, to oceniło je prawidłowo jako stworzone przez AI. Tak samo, gdy wgrano do niego obraz wygenerowany na podstawie innego wygenerowanego obrazu – trafnie oceniło, że to dzieło AI.

PODSUMOWANIE: 5 prawidłowych odpowiedzi i 1 błędna w przypadku wygenerowanego obrazu z doklejonym obiektem.

DODATKOWE UWAGI: Bardzo łatwe w użyciu i czytelne oceny, które nie pozostawiają wątpliwości, ale może być dość mylące w przypadku potencjalnych błędów, które występują.

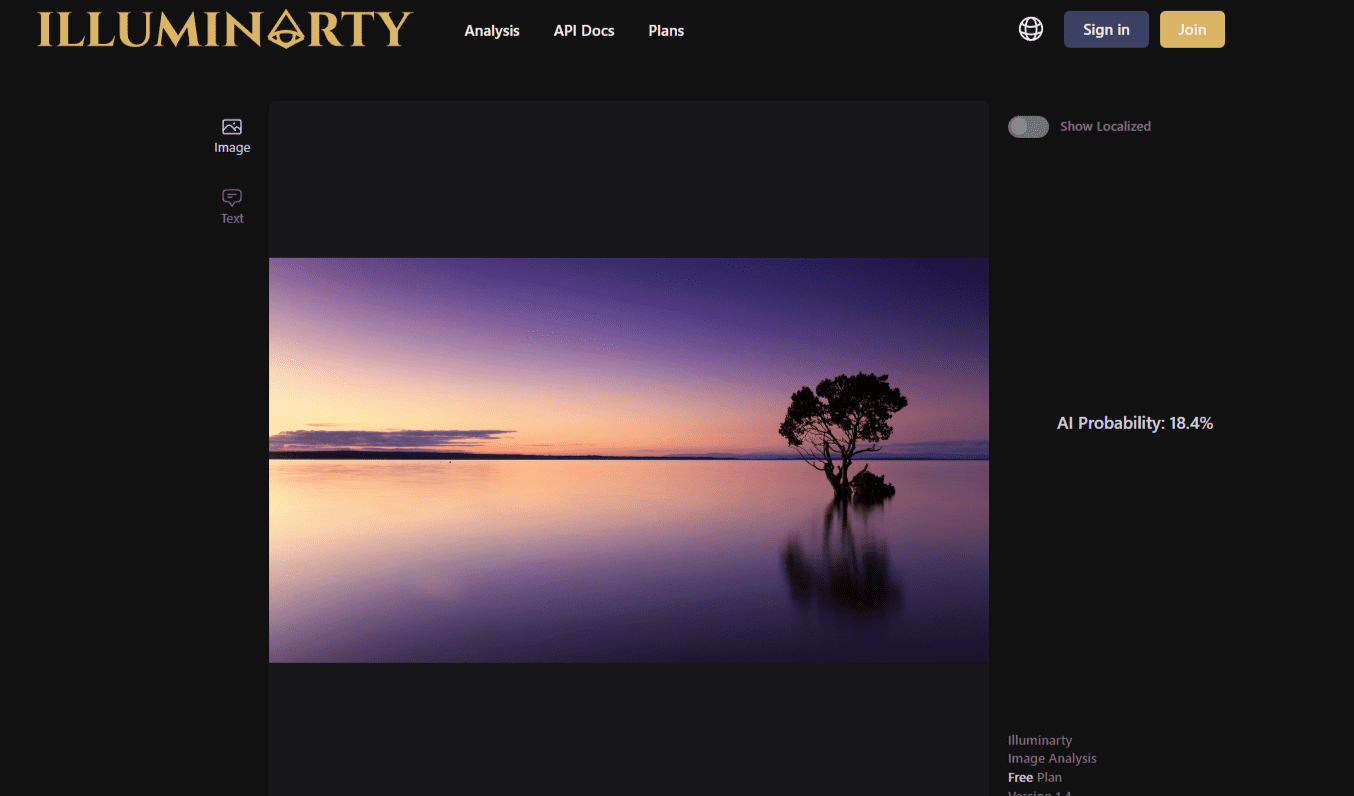

Illuminarty – czy oko w trójkącie dojrzy absolutnie wszystko?

Na stronie głównej illuminarty.ai od KI-Tech Hertig widzimy wielkie oko opatrzności znane z teorii spiskowej o zakonie Illuminati. Czy zatem jest to tak dobre narzędzie, że przejrzy na wylot każdy obraz? Na stronie podano, że: „Illuminarty łączy różne algorytmy komputerowe, aby ocenić prawdopodobieństwo wygenerowania obrazu z użyciem publicznych modeli generowania sztucznej inteligencji”.

By przekonać się o tym, jak działa narzędzie, wystarczy kliknąć przycisk „Get Started” i przekieruje nas do panelu, w którym można wgrać obraz (w tym przypadku tylko taki, który zapisaliśmy wcześniej na dysku). W darmowej wersji narzędzie oceni prawdopodobieństwo ingerencji AI w obraz – w skali od 0 do 100 proc., czyli bez jednoznacznej oceny.

Jak dobrze Illuminarty poradził sobie z naszymi obrazami?

Prawdziwe zdjęcie, które przedstawiało samolot, zostało ocenione prawidłowo – prawdopodobieństwo ingerencji AI oceniono jedynie na 5,1 proc. W przypadku prawdziwego zdjęcia wypadku z doklejonym obiektem narzędzie było jeszcze dokładniejsze i podało, że prawdopodobieństwo ingerencji AI wynosi tylko 0,1 proc. – to również trafna ocena.

W przypadku wygenerowanego obrazu, który przedstawiał czołg, narzędzie udzieliło poprawnej odpowiedzi, ale trzeba odnotować, że wynik był dość niepewny (prawdopodobieństwo ingerencji AI oceniono na 68,5 proc.). Znacznie gorzej było w przypadku wygenerowanego obrazu z doklejonym obiektem, który przedstawiał karetki na sygnale. Narzędzie oceniło, że ingerencja AI to jedynie 0,7 proc. – ocena była więc błędna.

Gdy narzędzie otrzymało obraz wygenerowany na podstawie prawdziwego zdjęcia z sylwetkami mężczyzn, oceniło je dobrze i wskazało, że ingerencja AI wynosi 98,5 proc. Podobnie trafnie było, gdy wgrano do niego obraz wygenerowany na podstawie innego wygenerowanego – dobrze oceniono, że to dzieło AI, wskazując na wysokie prawdopodobieństwo użycia tej technologii, które sięgało 90,7 proc.

PODSUMOWANIE: 5 prawidłowych odpowiedzi i 1 błędna w przypadku wygenerowanego obrazu z doklejonym obiektem.

DODATKOWE UWAGI: Bardzo łatwe w użyciu, stara się być dokładne w swoich ocenach, ale trzeba odnotować, że czasami się myli, ponadto jeden prawidłowy wynik był dość niepewny.

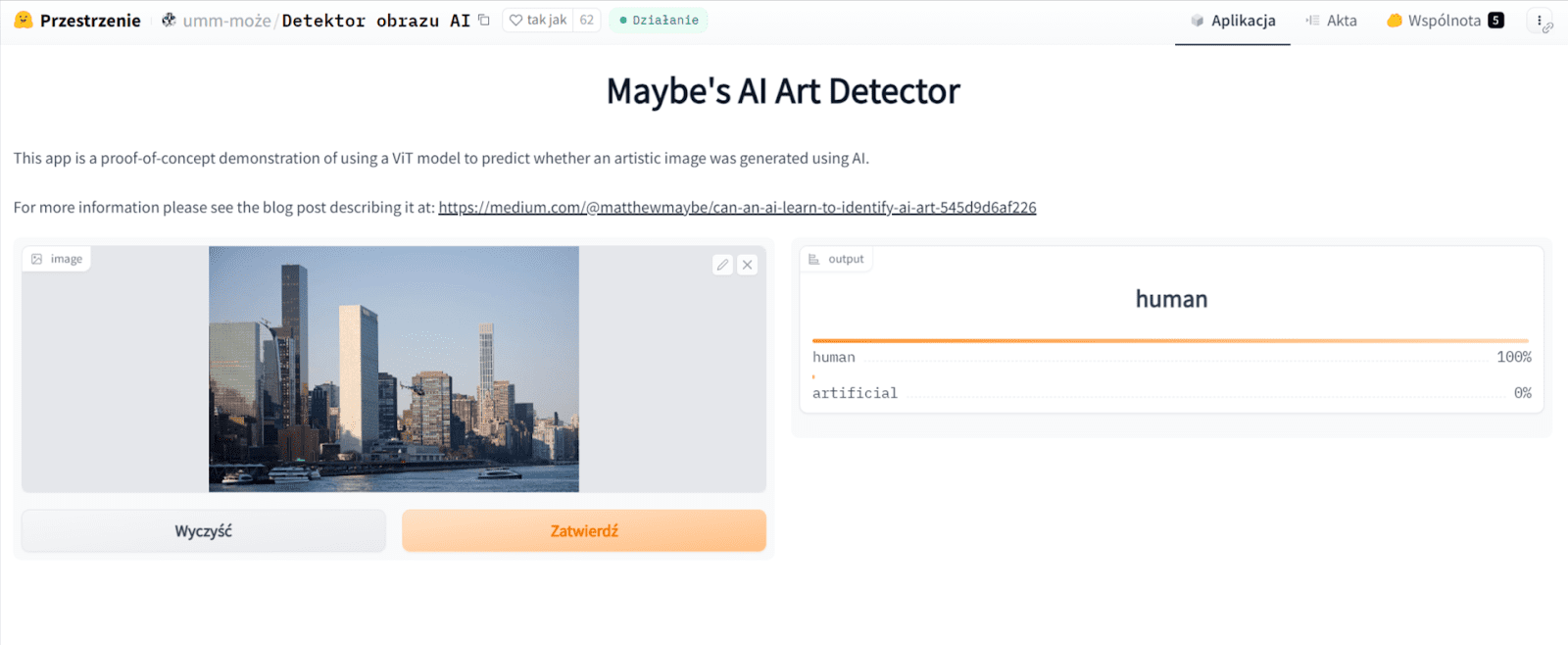

Maybe’s AI Art Detector – da tylko sugestię czy pewną odpowiedź?

Gdy wejdziemy na stronę z aplikacją huggingface.co od Hugging Face, Inc. to ujrzymy dość prosty panel z jasnymi kolorami. Jak czytamy, jest to: „wersja demonstracyjna modelu ViT do oceniania, czy obraz artystyczny został wygenerowany przy użyciu sztucznej inteligencji”.

To narzędzie, które – podobnie jak w przypadku illuminarty.ai – umożliwia wgranie fotografii z naszego dysku i ocenę prawdopodobieństwa ingerencji AI w obraz w skali od 0 do 100 proc., a do tego z wyraźnym podziałem na udział człowieka i sztuczną inteligencję.

Jak dobrze Maybe’s AI Art Detector poradził sobie z naszymi obrazami?

Prawdziwy obraz, który przedstawiał samolot, został oceniony prawidłowo, ale wynik był bardzo niepewny, ponieważ tylko na 52 proc. wskazano, że to człowiek stworzył obraz. Jeżeli chodzi o prawdziwe zdjęcie wypadku z dodaną czerwoną kropką, narzędzie było już trochę lepsze i trafnie oceniło, że na 70 proc. było ono dziełem człowieka.

W przypadku wygenerowanego obrazu, który przedstawiał czołg, narzędzie udzieliło prawidłowej odpowiedzi i oceniło prawdopodobieństwo ingerencji AI na 85 proc. Zły wynik był natomiast w przypadku wygenerowanego obrazu z doklejoną czerwoną kropką, który przedstawiał karetki na sygnale. Zdaniem huggingface.co obraz na 53 proc. był dziełem człowieka – to błąd. Jak widać, tutaj wynik również był niepewny, ale przeważył na stronę nieprawidłowej odpowiedzi.

W sytuacji, gdy narzędzie otrzymało obraz z sylwetkami mężczyzn wygenerowany na podstawie prawdziwego zdjęcia, to oceniło je błędnie i wskazało, że w 66 proc. stworzył je człowiek (kiedy tak naprawdę stworzyło je AI). W przypadku obrazu wygenerowanego na podstawie innego wygenerowanego – źle oceniono, że na 53 proc. stworzył je człowiek – i tu wynik był niepewny.

PODSUMOWANIE: 3 prawidłowe odpowiedzi i 3 błędne w przypadku wygenerowanego obrazu z doklejonym obiektem oraz wygenerowanych obrazów na podstawie prawdziwej fotografii i innego wygenerowanego obrazu.

DODATKOWE UWAGI: Bardzo łatwa obsługa, ale podaje najwięcej błędnych i wiele niepewnych odpowiedzi spośród wszystkich tutaj testowanych aplikacji.

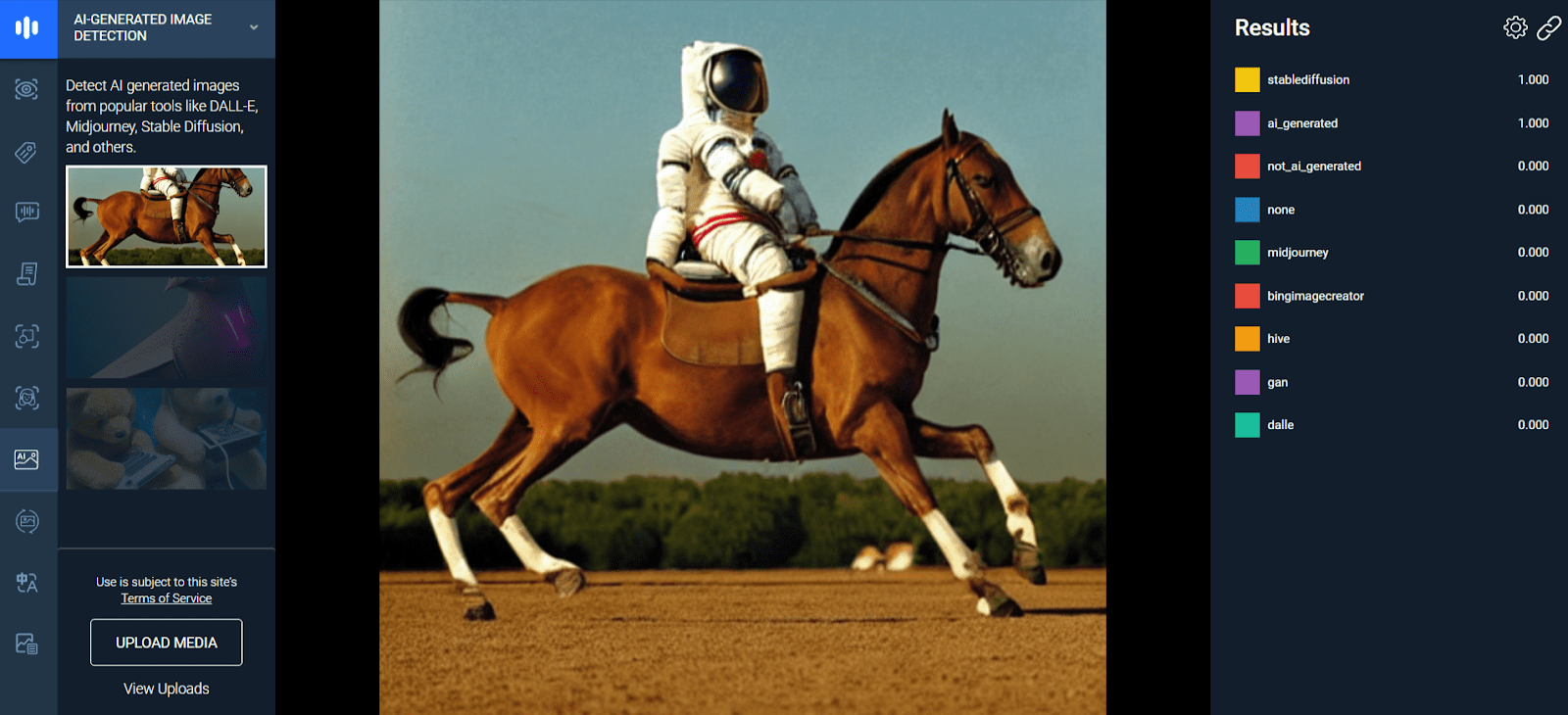

AI-Generated Image Detection – podobnie, ale czy lepiej niż inni?

Narzędzie AI-Generated Image Detection zostało udostępnione za darmo w wersji demo w ramach platformy thehive.ai, która oferuje dostęp do kilku rozwiązań opartych na sztucznej inteligencji. Zgodnie z opisem najbardziej interesująca nas opcja zapewnia możliwość: „wykrywania obrazów generowanych przez sztuczną inteligencję z takich popularnych narzędzi jak DALL-E, Midjourney, Stable Diffusion i inne”.

Po wybraniu odpowiedniej opcji widzimy panel, który umożliwia wgranie obrazów zapisanych na dysku, ale pozwala też przesłać link z obrazem do oceny. Następnie narzędzie ocenia prawdopodobną ingerencję AI w obraz – w skali od 0.000 do 1.000 w ramach kilku parametrów, w tym m.in. tych dotyczących użytego narzędzia do wygenerowania obrazu, lub podaje wartość dla obrazów niewygenerowanych.

Jak dobrze AI-Generated Image Detection poradził sobie z naszymi obrazami?

Prawdziwe zdjęcie, które przedstawiało samolot, zostało ocenione prawidłowo – wskazano, że na 0.999 powstało jako niewygenerowane przez AI. W przypadku prawdziwego zdjęcia wypadku z doklejonym obiektem narzędzie było bardzo skuteczne i podało wartość 1.000 dla obrazów niewygenerowanych – to również dobra ocena.

W przypadku wygenerowanego obrazu, który przedstawiał czołg, narzędzie ponownie udzieliło dobrej odpowiedzi. Wskaźnik wykazał 1.000 dla obrazów wygenerowanych – czyli maksymalną wartość. Gdy do narzędzia wgraliśmy wygenerowany obraz z doklejonym obiektem, na którym przedstawiono karetki na sygnale, to również ukazała się poprawna odpowiedź. Narzędzie oceniło, że prawdopodobna ingerencja AI wyniosła 0.998.

Najgorzej narzędzie poradziło sobie z obrazem, który był wygenerowany na podstawie prawdziwego zdjęcia. W tym przypadku błędnie wskazało wartość 0,852 dla obrazów, które nie zostały stworzone sztucznie. Znacznie lepiej było w przypadku ostatniej grafiki, czyli obrazu wygenerowanego na podstawie innego wygenerowanego – dobrze oceniono, że to dzieło AI i wykazano wartość 1.000 dla obrazów powstałych dzięki sztucznej inteligencji.

PODSUMOWANIE: 5 prawidłowych odpowiedzi i 1 błędna odpowiedź w przypadku obrazu wygenerowanego na podstawie prawdziwego zdjęcia.

DODATKOWE UWAGI: Nieco mniej intuicyjne narzędzie, także nieidealne przy niektórych odpowiedziach, ale oferuje dobre podpowiedzi co do narzędzia użytego do wygenerowania obrazu (w tym przypadku Midjourney).

Narzędzie idealne? Nazywa się prosto: „zrób wszystko, co możesz”

Każde z opisanych tu narzędzi jest proste w użyciu i nie wymaga specjalistycznych umiejętności. Dość subiektywnie można wskazać, że najlepsze w ocenie były AI or Not oraz AI-Generated Image Detection. Niemniej każde z narzędzi ma pewne wady.

W każdym przypadku wystarczyły drobne ingerencje, aby narzędzia miały problem z oceną. Istotnym pytaniem pozostaje też, jak będą działać, jeżeli ktoś opracuje niepubliczny model do generowania grafik? Każde z nich może trafnie odgadnąć lub całkowicie się pomylić. Zupełnie tak samo jak ludzkie oko i percepcja.

Jakiekolwiek narzędzie nie może być wyrocznią – zawsze trzeba brać pod uwagę możliwość błędu, nawet jeżeli w tym teście jakieś narzędzie wypadło dobrze. Najlepszym rozwiązaniem jest zatem kompleksowe działanie i zrobienie wszystkiego, co oferują nam nasze możliwości i umiejętności krytycznego myślenia w połączeniu z technologią.

Jeżeli kiedykolwiek chcielibyśmy sprawdzić wiarygodność fake newsa opartego na wygenerowanym obrazie, to najlepiej byłoby ocenić samemu jego cechy charakterystyczne, a następnie skorzystać z metod i narzędzi do weryfikacji. W tym m.in. tych, które opisaliśmy już w serii na temat generowanych obrazów.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter