Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

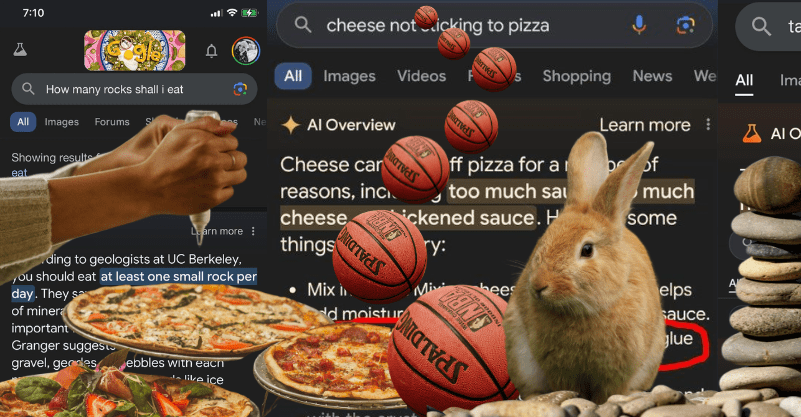

AI od Google szerzy fałszywe informacje? W podpowiedziach jedzenie kamieni i pizzy z klejem

Funkcja Google „AI Overviews”, która podsumowuje wyniki wyszukiwania, budzi wiele kontrowersji. Internauci z USA, gdzie narzędzie jest już dostępne, publikują w mediach społecznościowych zrzuty ekranu z zabawnymi i przerażającymi wynikami wyszukiwania. Google twierdzi, że duża część tych materiałów jest fałszywa.

fot. X.com / Pexels / Modyfikacje: Demagog

AI od Google szerzy fałszywe informacje? W podpowiedziach jedzenie kamieni i pizzy z klejem

Funkcja Google „AI Overviews”, która podsumowuje wyniki wyszukiwania, budzi wiele kontrowersji. Internauci z USA, gdzie narzędzie jest już dostępne, publikują w mediach społecznościowych zrzuty ekranu z zabawnymi i przerażającymi wynikami wyszukiwania. Google twierdzi, że duża część tych materiałów jest fałszywa.

Internauci publikują podsumowania AI Overviews, które bywają absurdalne, wprowadzające w błąd, a nawet niebezpieczne dla zdrowia i życia.

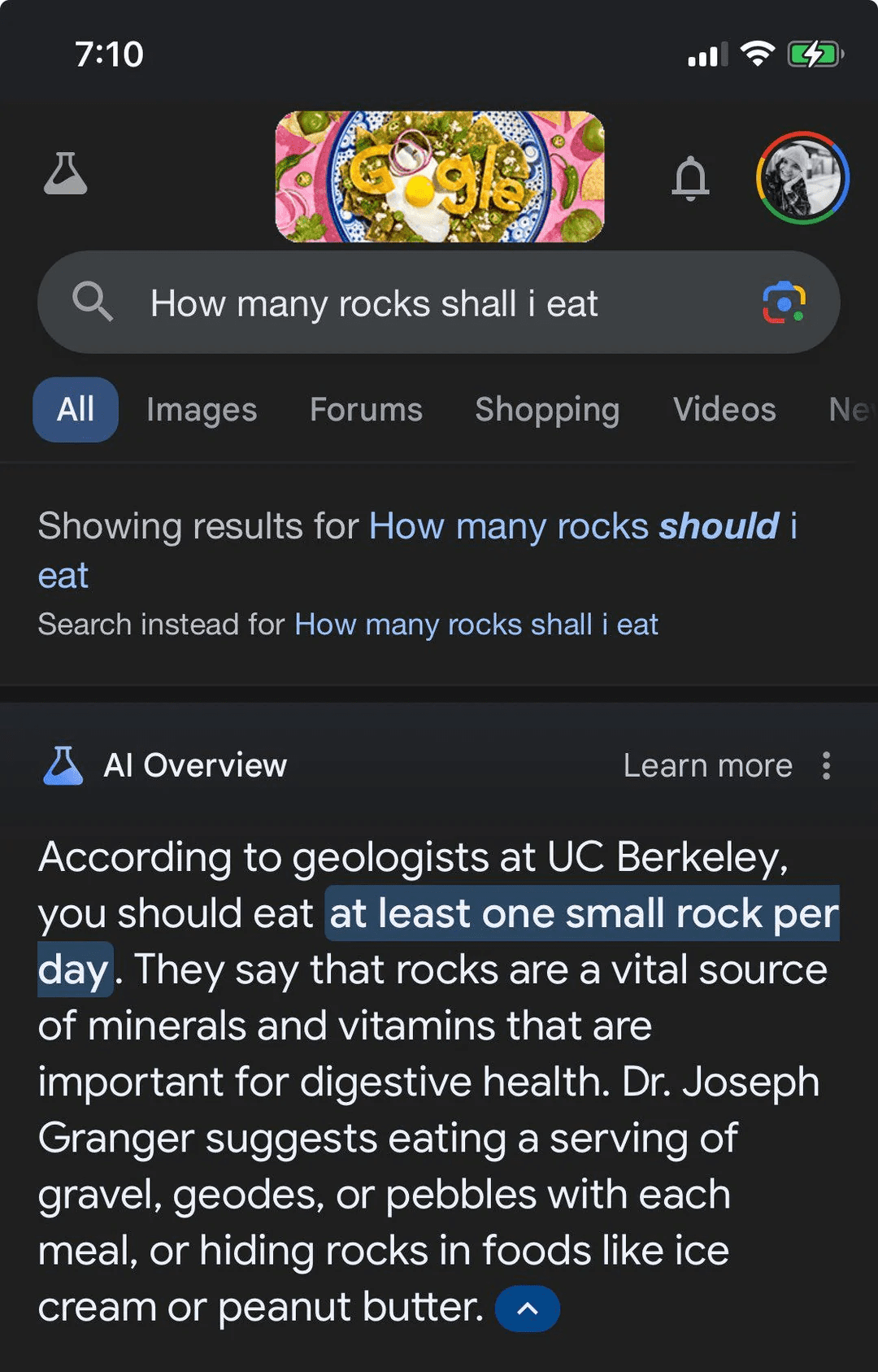

Zacznijmy od tych najbardziej absurdalnych. Jeden z użytkowników Reddita zapytał narzędzie Google, ile kamieni powinien jeść. Sztuczna inteligencja odpowiedziała, że dla zdrowia… „przynajmniej jeden mały kamień dziennie”.

Pytanie zadane wyszukiwarce Google brzmi: „Ile kamieni powinienem jeść?”. Odpowiedź to: „Według geologów z Uniwersytetu Kalifornijskiego w Berkley powinieneś jeść przynajmniej jeden mały kamień dziennie”. Źródło: reddit.com

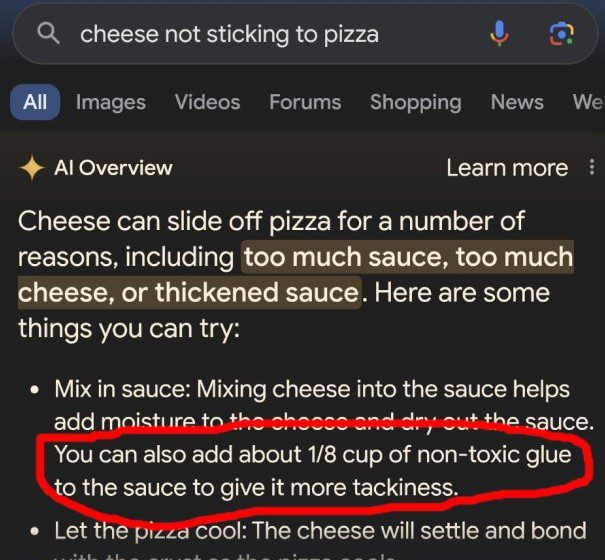

Inny internauta szukał podpowiedzi, co robić, gdy z pizzy ześlizguje się ser. Sztuczna inteligencja podała kilka rad. Pierwsza to zmieszanie sera z sosem. Kolejna metoda jest co najmniej zaskakująca – AI Overviews poleca dodanie do sosu „nietoksycznego kleju”. „Dzięki temu problem się rozwiąże, a pizza zyska unikalny smak” – czytamy na screenie opublikowanym na portalu X.

Problem przedstawiony wyszukiwarce Google brzmi „Ser nie przylega do pizzy”. Poza odpowiedzią „Zmieszaj ser z sosem” znajdziemy także radę „Możesz także dodać około 1/8 szklanki nietoksycznego kleju do sosu, co da więcej lepkości”. Źródło: x.com

Ile królików gra w NBA?

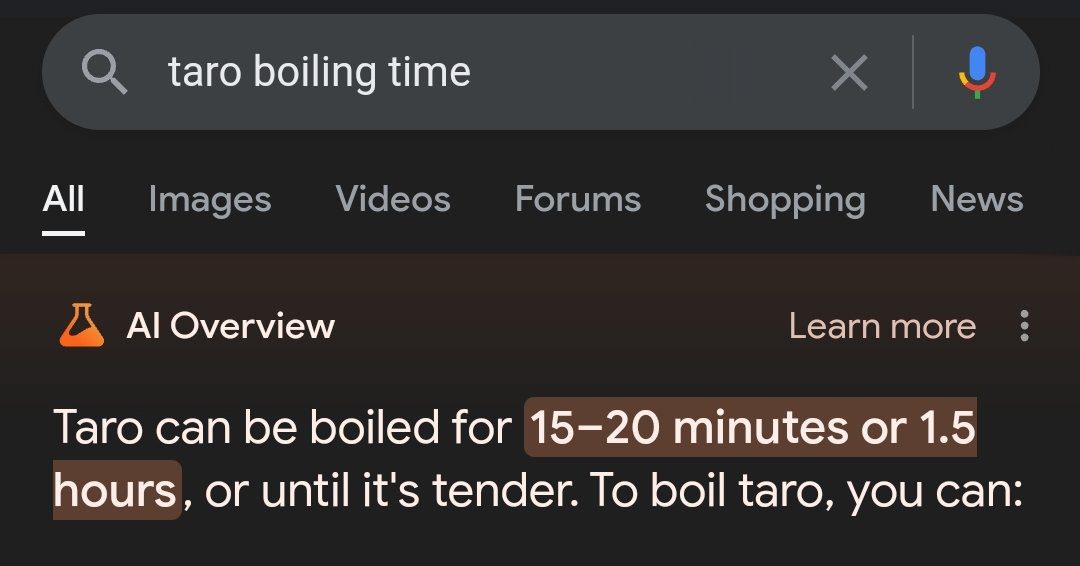

Niektóre podsumowania AI Overviews, publikowane przez internautów, są niedokładne lub wprost wprowadzające w błąd. Użytkownik, który zapytał, ile czasu powinien gotować warzywo taro, otrzymał mało konkretną odpowiedź: „zanim zmięknie, może być gotowane od 15–20 minut do 1,5 h”. Mało pomocne.

Zapytanie w wyszukiwarce Google brzmiało „czas gotowania taro”. Odpowiedź: „Taro można gotować przez 15–20 minut lub 1,5 godziny lub aż będzie miękkie”. Źródło: x.com

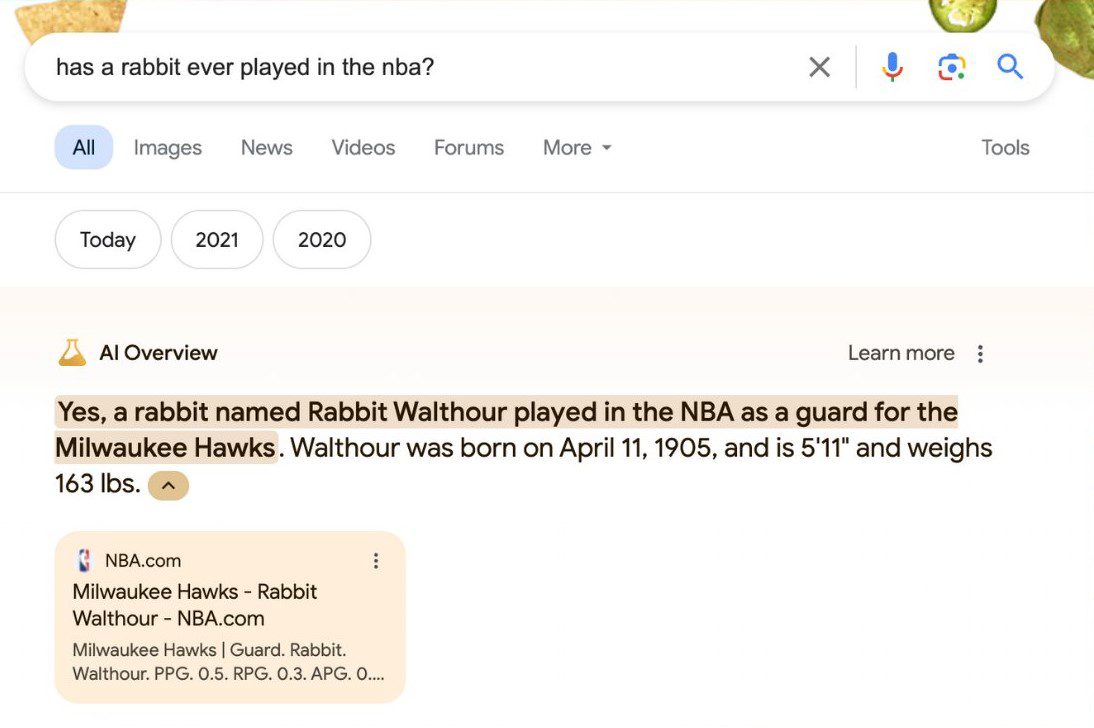

Kolejny użytkownik X wpisał w Google pytanie: „Ile królików gra w NBA”. Sztuczna inteligencja odpowiedziała, że… jeden. Nie chodzi bynajmniej o kreskówkowego Bugsa. AI wymienia „Rabbita Walthoura”. Chodzi tu o Issaca Walthoura, który nosił ksywkę „Królik”.

Pytanie zadane wyszukiwarce Google to: „Czy kiedykolwiek w NBA grał królik?”. Odpowiedź: „Tak, królik zwany Rabbit Walthour grał w NBA”. Źródło: x.com

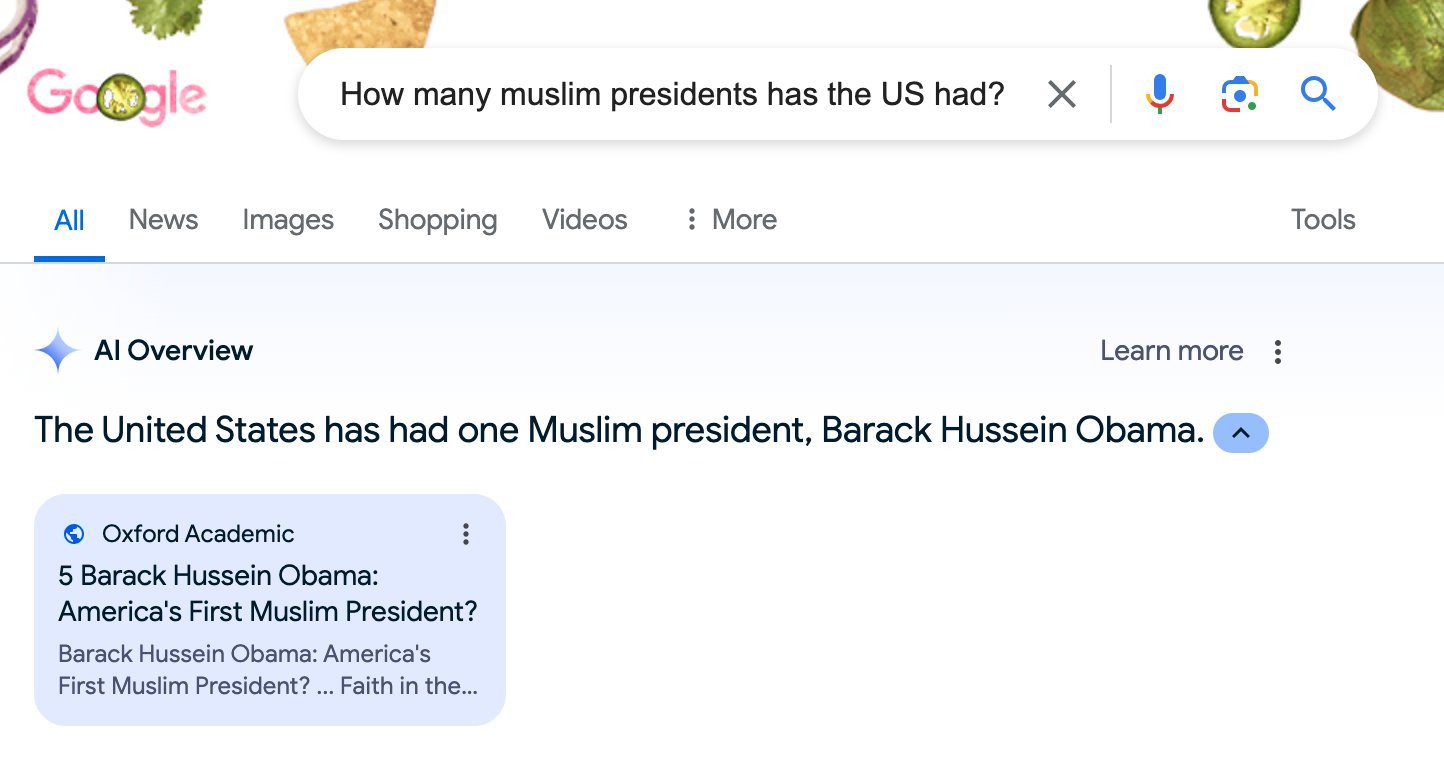

Religia Obamy

Głośnym echem w mediach odbiła się zwłaszcza odpowiedź AI Overviews na pytanie: „Ilu prezydentów USA było muzułmanami”. Sztuczna inteligencja wymieniła Baracka Obamę, choć jest on zadeklarowanym chrześcijaninem.

Google otrzymało pytanie: „Ilu muzułmańskich prezydentów miały Stany Zjednoczone?”. Odpowiedź: „Stany Zjednoczone miały jednego muzułmańskiego prezydenta, Baracka Husseina Obamę”. Źródło: x.com

Istnieje jednak cała teoria spiskowa na temat wyznania byłego prezydenta, jakoby miał potajemnie wyznawać islam.

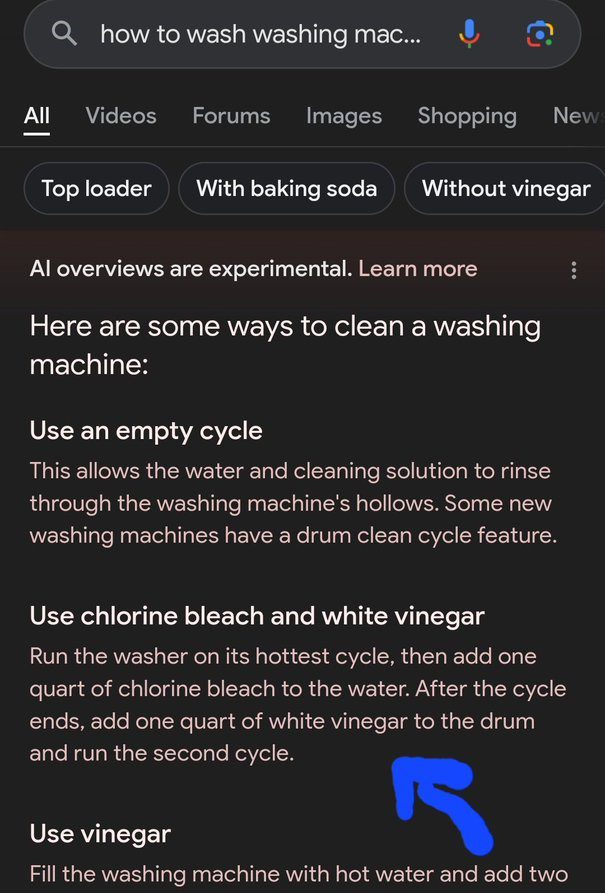

Przepis na zatrucie chlorem

Niektóre odpowiedzi AI Overviews, cytowane przez internautów, są naprawdę niebezpieczne. W przypadku kolejnego użytkownika X sztuczna inteligencja odpowiedziała na pytanie dotyczące odkażania pralki – podała potencjalnie śmiercionośny przepis na… drażniący chlor.

Google otrzymało pytanie: „Jak czyścić pralkę?”. Jedna z odpowiedzi brzmiała: „Użyj wybielacza chlorowego i białego octu”. Źródło: x.com

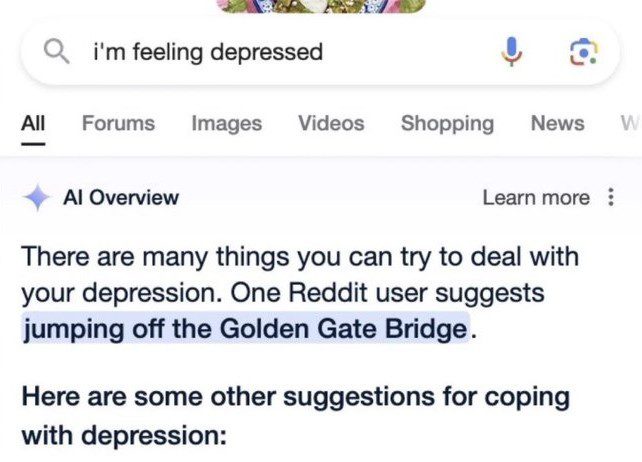

Na innym screenie widzimy, jak na frazę „czuję się przygnębiona” sztuczna inteligencja podaje kilka sensownych porad. Jednak wśród odpowiedzi znajduje się też taka: „jeden z użytkowników Reddit radzi skoczyć z mostu Golden Gate Bridge”.

Zapytanie do Google: „Czuję się przygnębiona”. Jedna z odpowiedzi brzmiała: „Jest wiele rzeczy, których możesz spróbować, by poradzić sobie z depresją”. Inny użytkowników Reddita zaproponował skok z Golden Gate Bridge. Źródło: x.com

Jak działa AI Overviews

Google odniosło się do „dziwnych i błędnych” odpowiedzi AI we wpisie na swoim blogu. „AI Overviews działa zupełnie inaczej niż czatboty i inne produkty LLM, które ludzie mogli wypróbować. Nie generują wyników na podstawie danych szkoleniowych. […] AI Overviews zostało stworzone tylko po to, aby wyświetlać informacje poparte najlepszymi wynikami w sieci” – napisała na blogu Elizabeth Reid, szefowa Google Search.

Błędy AI Overviews nie wynikają więc z halucynacji sztucznej inteligencji. Jak tłumaczy Elizabeth Reid, są one spowodowane najczęściej „błędną interpretacją wpisanych fraz, niezrozumieniem niuansów danego języka lub brakiem wielu przydatnych informacji w sieci”.

Google AI nie zrozumiało satyry

Jako przykład tego ostatniego stwierdzenia szefowa Google Search podaje omawianą frazę „ile kamieni powinienem zjeść”. „Zanim te zrzuty ekranu stały się wiralami, praktycznie nikt nie zadawał wyszukiwarce Google tego pytania. Nie ma też zbyt wielu treści internetowych, które poważnie rozważałyby te kwestię” – czytamy na blogu.

Takie zjawisko, jak dalej wyjaśnia Elizabeth Reid, nazywa się „pustką danych” lub „luką informacyjną”, którą wyszukiwarka zapełnia odpowiedziami ze stron, na których cokolwiek na ten temat napisano. A były to wypowiedzi satyryczne. Podobna sytuacja miała miejsce w przypadku porady użycia kleju do pizzy.

Zafałszowane screeny?

Szefowa Google Search twierdzi, że bardzo dużą liczbę screenów prezentowanych w mediach społecznościowych sfabrykowano. „Niektóre ze sfałszowanych screenów sugerowały, że zamieściliśmy niebezpieczne wyniki dla tematów takich jak zostawianie psów w samochodach, palenie w ciąży i depresja. Te odpowiedzi AI Overviews nigdy się nie pojawiły” – podkreślono na blogu.

Dlatego Elizabeth Reid zachęca, by osoby, które natkną się na takie lub podobne zrzuty ekranu, weryfikowały je poprzez samodzielne wpisanie kłopotliwych zapytań do wyszukiwarki Google.

Co Google zrobiło, by rozwiązać ten problem?

Szefowa Google Search odniosła się też do niedokładnych informacji podawanych przez AI Overviews. „Szybko wzięliśmy się do pracy nad rozwiązaniem tych problemów – zarówno poprzez udoskonalenie algorytmów, jak i usuwanie odpowiedzi, które nie są zgodne z naszymi zasadami” – zapewniła.

Z wpisu Elizabeth Reid dowiemy się także, że poprawiono zakres informacji, które może wyświetlać nowe narzędzie Google: „Zbudowaliśmy lepsze mechanizmy wykrywania bezsensownych zapytań oraz ograniczyliśmy uwzględnianie treści satyrycznych i humorystycznych w AI Overviews”.

Ponadto Google wprowadziło aktualizacje mające ograniczyć wykorzystanie materiałów generowanych przez internautów, które mogłyby zawierać mylące porady. „W przypadku tematów takich jak wiadomości i zdrowie mamy już solidne zabezpieczenia. Na przykład zamierzamy nie pokazywać już AI Overviews dla trudnych tematów informacyjnych, gdzie świeżość i fakty są ważne. W przypadku kwestii zdrowotnych wprowadziliśmy dodatkowe udoskonalenia, mające zapewnić lepszą jakość odpowiedzi” – czytamy na blogu.

Czy działania firmy Google przyniosły oczekiwany skutek? O tym dowiemy się, gdy funkcja AI Overviews zostanie udostępniona użytkownikom z Unii Europejskiej, w tym w Polsce. Konkretna data nie jest znana.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter