Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

AI wchodzi do polityki. Co możemy z tym zrobić?

W ostatnich miesiącach w mediach społecznościowych pojawiają się nowe polityczne treści tworzone z pomocą sztucznej inteligencji (AI). To ostatnia chwila, aby nauczyć się z nimi obchodzić. Filmiki i zdjęcia powstałe z wykorzystaniem AI powinny być oznaczane przez platformy, ale też przez nas – użytkowników.

fot. Pixabay / Modyfikacje: Demagog

AI wchodzi do polityki. Co możemy z tym zrobić?

W ostatnich miesiącach w mediach społecznościowych pojawiają się nowe polityczne treści tworzone z pomocą sztucznej inteligencji (AI). To ostatnia chwila, aby nauczyć się z nimi obchodzić. Filmiki i zdjęcia powstałe z wykorzystaniem AI powinny być oznaczane przez platformy, ale też przez nas – użytkowników.

Październik 2020 roku – na ulice polskich miast wychodzą tysiące protestujących, czym wyrażają swój sprzeciw wobec wyroku Trybunału Konstytucyjnego w sprawie aborcji. W niektórych miejscach dochodziło do incydentów, np. do zakłócenia nabożeństw. W reakcji Jarosław Kaczyński wydaje oświadczenie, w którym krytykuje postawę Kościoła katolickiego i wzywa obywateli do udziału w demonstracjach.

Brzmi absurdalnie? Tak, to fałszywe oświadczenie. Niemniej oryginał nagrania zmodyfikowano na tyle dobrze, że dopatrzenie się manipulacji na pierwszy rzut oka nie jest oczywiste. Twarz prezesa PiS wygląda identycznie jak na prawdziwym nagraniu. Ponadto dźwięk jest zsynchronizowany z ruchem ust.

Filmik ten nie stanowi klasycznego przykładu deepfake’a. Osiągnięty efekt – manipulację słowami Jarosława Kaczyńskiego – uzyskano poprzez sprawne pocięcie klatek nagrania z wykorzystaniem narzędzia bazującego na sztucznej inteligencji. Co więcej, część odbiorców zrozumiała, że jest to przeróbka zrobiona dla celów rozrywkowych. Mimo to powyższy przykład pokazał, z jakim zagrożeniem możemy się mierzyć w najbliższej przyszłości: z fałszywym wykorzystaniem autorytetu w ramach politycznej batalii.

Deepfake – przyszłość jest dziś

Deepfake’i to sztucznie generowane materiały dźwiękowe i wizualne, które naśladują prawdziwe wydarzenia i osoby. Sztuczna inteligencja – poprzez przetworzenie oryginalnych nagrań i obrazów – może wytworzyć wypowiedzi, zdjęcia lub filmy do złudzenia przypominające rzeczywistość. W ten sposób można kreować sytuacje, które nigdy nie miały miejsca.

Jak się okazuje, nie trzeba było czekać długo na deepfake’i polskich polityków. Andrzej Duda ostrzegający, aby nie używać słowa „bambik”, czy Donald Tusk wyśmiewający się z poziomu języka angielskiego prezydenta Dudy – to znane wypowiedzi wygenerowane przez AI. Po sieci krąży także spreparowane nagranie Mateusza Morawieckiego wulgarnie wyrażającego się o politycznej sytuacji w Europie. Słowa premiera nie tylko zostały wygenerowane przez AI, ale też zsynchronizowano je z ruchem ust.

To przykłady deepfake’ów, na które można natknąć się podczas korzystania z TikToka. Filmiki są utrzymane w humorystycznym lub szyderczym tonie. Wydaje się, że ich szkodliwość jest względnie niska. Jest jedno „ale”.

Popularność deepfake’ów (filmik z Andrzejem Dudą ma 2,1 mln odsłon) może stwarzać precedens generowania filmików przy użyciu sztucznej inteligencji przez większe grono osób, w tym aktywnych polityków. Będzie to prowadzić do pogłębiającej się erozji jakości informacji oraz do trudności w odróżnieniu prawdy od fałszu. Ostrzega o tym Jarosław Kaczyński albo… jego wirtualny klon. Zobaczcie sami (czas nagrania 0:24):

@starpar Fake situation! AI generated! #andrzejduda #meme #polska #starpar #ai #smieszne ♬ dźwięk oryginalny – STARPAR®

Sztuczna inteligencja w polityce staje się elementem rozgrywki politycznej

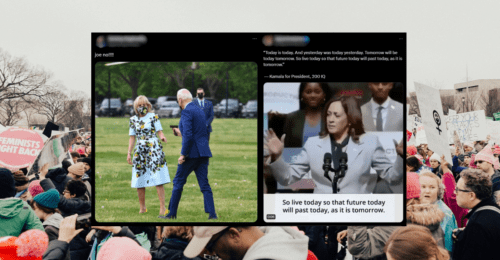

Pod koniec kwietnia 2023 roku Republikański Komitet Narodowy w USA, w reakcji na decyzję Joe Bidena w sprawie ubiegania się o reelekcję w wyborach prezydenckich, wypuścił spot. W materiale, wygenerowanym przy pomocy sztucznej inteligencji, wróżono apokaliptyczną wizję Stanów Zjednoczonych, gdy u sterów władzy pozostanie kandydat Demokratów.

To, co zaczęło dziać się za Atlantykiem, przeniknęło szybko na polską scenę polityczną. W lipcu Dariusz Matecki, polityk Suwerennej Polski, stworzył spot wieszczący nadejście katastrofy, gdyby do władzy doszedł Donald Tusk. Obrazki wykreowane z użyciem AI przedstawiają wdarcie się nielegalnych imigrantów do Polski, wycofanie się amerykańskich wojsk czy też obowiązkowe zajęcia w szkołach z „aktywistami gender”.

Nie dopuśćmy politycznych zdrajców do władzy. pic.twitter.com/GDUBJ0kpVY

— Dariusz Matecki (@DariuszMatecki) July 7, 2023

AI może służyć do propagowania kompromitujących treści

W sierpniu na koncie Platformy Obywatelskiej na portalu X (dawny Twitter) ruszyła seria wpisów pod hasztagiem #MailePrawdy. Do tej pory pojawiło się 10 publikacji (1, 2, 3, 4, 5, 6, 7, 8, 9, 10).

W zamieszczonych nagraniach PO przytacza – z jej perspektywy – najbardziej kompromitujące wiadomości, które wyciekły ze skrzynki mailowej Michała Dworczyka, Daniela Obajtka oraz Joachima Brudzińskiego. Za wyciekiem stoi najprawdopodobniej grupa hakerów powiązana z Białorusią. Treści maili są odczytywane przez głos wygenerowany przez AI. I tak PO użyła sztucznej inteligencji do wygenerowania wypowiedzi polityków PiS, np. Mateusza Morawieckiego.

Zobacz kolejny materiał z serii #MailePrawdy! 🎥

Posłuchaj, jak zaczynała się kariera Daniela Obajtka w państwie PiS! Czy tak samo wyglądała twoja rozmowa o pracę? 🤔 pic.twitter.com/ZPlVB1YuX5

— PlatformaObywatelska (@Platforma_org) August 22, 2023

Nie wiadomo, w jakim stopniu maile są prawdziwe. – Część jest prawdziwa, część jest zmanipulowana, część jest całkowicie fałszywa – przyznał w sierpniu 2022 roku Michał Dworczyk. Z przekazów medialnych wynika, że autentyczność pojedynczych maili potwierdził Patryk Jaki oraz Jacek Sasin.

Kampania trwa, więc działać trzeba już teraz

Wraz z rozpoczęciem kampanii wyborczej zmienia się charakter materiałów generowanych przez sztuczną inteligencję. Do tej pory treści udostępniane w internecie miały charakter prześmiewczy lub zostały użyte, aby wzbudzić u odbiorców negatywne emocje – strach lub złość.

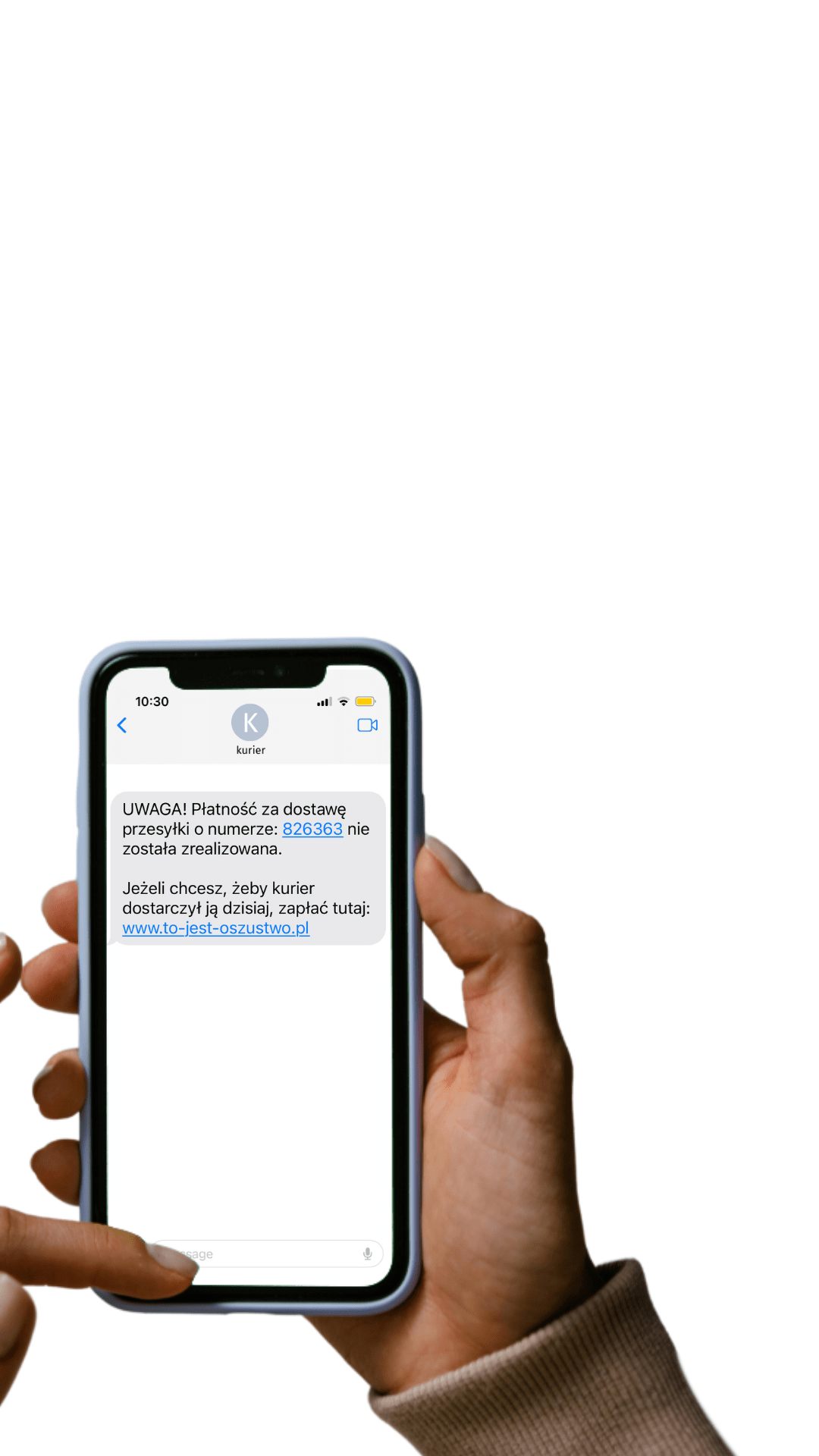

W internecie treści żyją swoim własnym życiem. Są udostępniane na różnych platformach i kanałach, przez co tracą swój pierwotny kontekst. Dlatego jest istotne, aby treści wygenerowane przez sztuczną inteligencję, były oznaczane.

Jest to szczególnie ważne, ponieważ sztuczna inteligencja może być niedługo używana do rozpowszechniania dezinformacji. Niestety – w dobie postprawdy i polaryzacji politycznej – nietrudno wyobrazić sobie, gdy partia A generuje deepfake’a z jednym z polityków partii B.

Obowiązek oznaczania spoczywa zarówno na platformach, jak i na użytkownikach

Komisja Europejska wezwała firmy Google i Metę do oznaczania treści wygenerowanych przez sztuczną inteligencję. W idealnym świecie moderacja Big Techów na bieżąco śledziłaby treści wytworzone przez AI i wprowadzałaby wyraźne oznaczenia każdej z nich.

Wiemy, że jest to jednak utrudnione, w szczególności przez ograniczone zasoby kadrowe pracowników posługujących się językiem innym niż angielski. Oznaczanie utrudnia też brak odpowiednich narzędzi na wyposażeniu platform społecznościowych.

Nadzieją jest standard C2PA, który pozwala identyfikować, skąd pochodzi fotografia lub film. Zgodnie z opracowaną technologią etykieta ostrzegająca przed treścią AI wędrowałaby wraz z fotografią lub filmikiem. Aby rozwiązanie było efektywne, muszą dołączyć do niego najwięksi gracze. Do tej pory zrobili to Microsoft, Intel, Adobe i Sony. Brakuje jednak Mety (Facebook, Instagram), Google (YouTube), X oraz TikToka.

Działalność platform to jedno. Ważne, aby to również użytkownicy mediów społecznościowych brali na siebie odpowiedzialność. Na przykład zgodnie z zasadami społeczności TikToka jego użytkownicy są zobowiązani do oznaczenia treści AI w podpisie do materiału.

Jak efektywnie oznaczać treści AI?

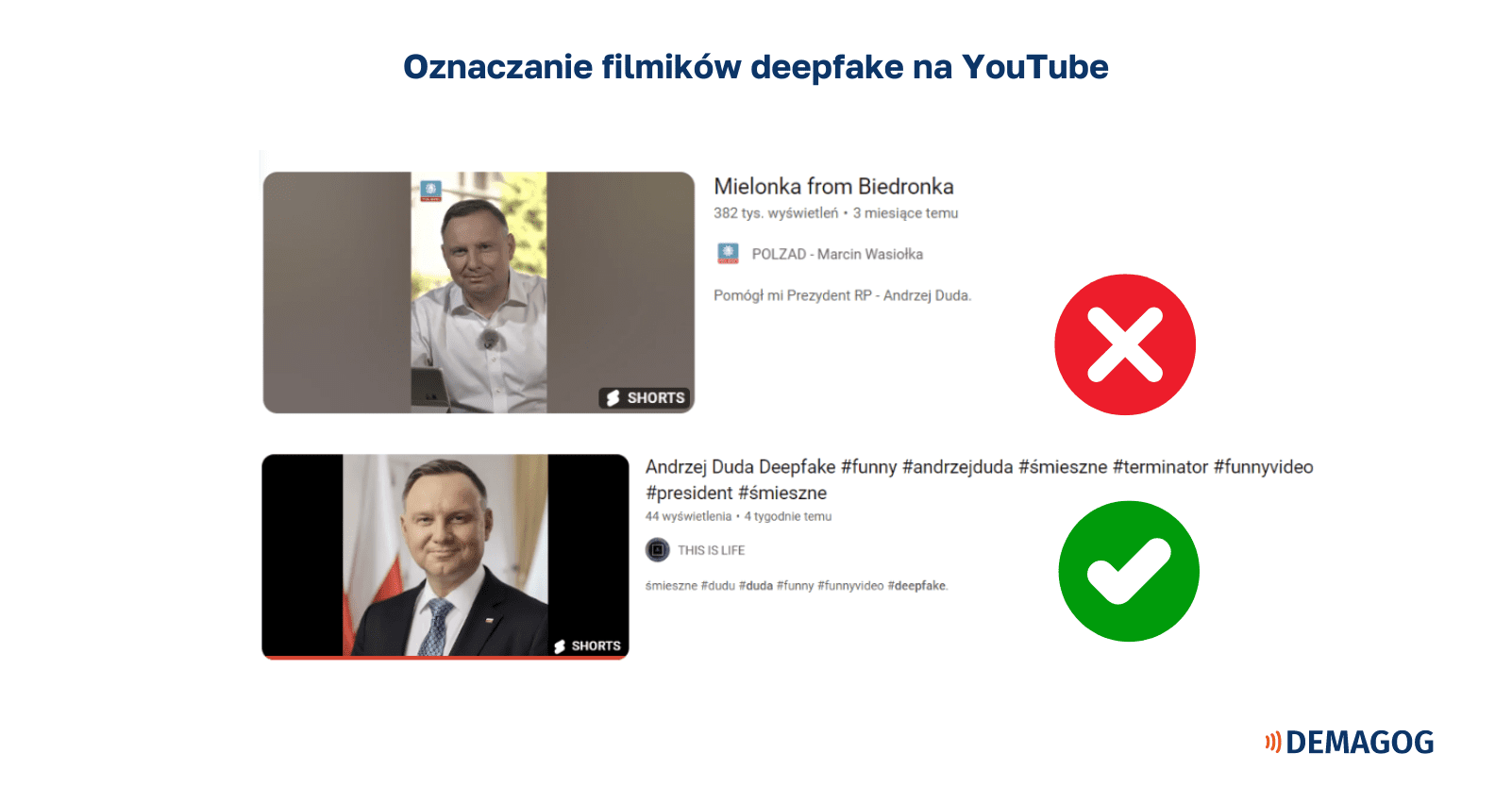

Skuteczne oznaczanie treści wytworzonej przez sztuczną inteligencję może odbywać się na kilka sposobów. Wszystko zależy, z jakiego medium korzystamy. Informacja mówiąca o tym, że filmik powstał przy użyciu AI, powinna znaleźć się już w tytule. To dobre rozwiązanie, gdy korzystamy np. z YouTube’a.

Dwa deepfake’i z Andrzejem Dudą na portalu YouTube. Pierwszy z nich nie został oznaczony w tytule. Drugie z nagrań posiada klarowne oznakowanie.

Co robić, gdy korzystamy z mediów społecznościowych, w których nie tytułuje się filmików? Wtedy najlepiej zawrzeć adnotację na samym początku nagrania, zanim pojawi się treść wygenerowana przez AI. Pomocniczo można zamieścić odpowiedni hashtag, np. #sztucznainteligencja lub #AIgenerated. Niewystarczającym rozwiązaniem jest umieszczenie informacji w sekcji komentarzy, w opisie filmu lub w odpowiedzi na wpis.

Uniwersalnym sposobem będzie wygenerowanie znaku wodnego, na którym ostrzegamy, że treść powstała przy użyciu AI. To pozwoli zabezpieczyć się na przyszłość. Udostępniana treść będzie migrować wraz ze znakiem wodnym. Do jego wytworzenia można użyć bezpłatnych narzędzi internetowych, np. Canvy.

Poprawne oznaczenie deepfake’a za pomocą znaku wodnego w Canvie.

Nie daj się nabrać. Weryfikacja to podstawa

W zweryfikowaniu, czy treść została wytworzona przez sztuczną inteligencję, mogą pomóc bezpłatne narzędzia. Należy jednak mieć na uwadzę, że nie stanowią one ostatecznej wyroczni, a raczej tylko pomocną dłoń w weryfikacji treści. W przypadku weryfikacji obrazów można skorzystać z takich narzędzi jak AI or Not oraz AI-Generated Image Detection.

Nieco inne zastosowanie ma bezpłatna wtyczka InVID, która powinna umożliwić dotarcie do pierwotnego źródła publikacji nagrania, dzięki opcji odwrotnego wyszukiwania obrazem.

Do pierwotnego źródła możemy dotrzeć „na piechotę”. Wówczas warto sprawdzić, czy nagranie pojawiło się na oficjalnym portalu partii, polityka lub urzędu. Jeżeli filmik zawiera cytaty, można je zweryfikować przy pomocy wyszukiwarki Google. Aby zrobić to skutecznie, dobrze byłoby zawęzić wyniki poprzez zastosowanie operatorów wyszukiwania.

Jeżeli posiadasz wątpliwości co do autentyczności nagrania lub obrazu, możesz zgłosić je nam poprzez formularz zgłoszeniowy.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter