Omawiamy ważne fakty dla debaty publicznej, a także przedstawiamy istotne raporty i badania.

Alexa, opowiedz mi fake newsa! Asystentka głosowa podawała fałszywe informacje

fot. Pexels / Modyfikacje: Demagog

Alexa, opowiedz mi fake newsa! Asystentka głosowa podawała fałszywe informacje

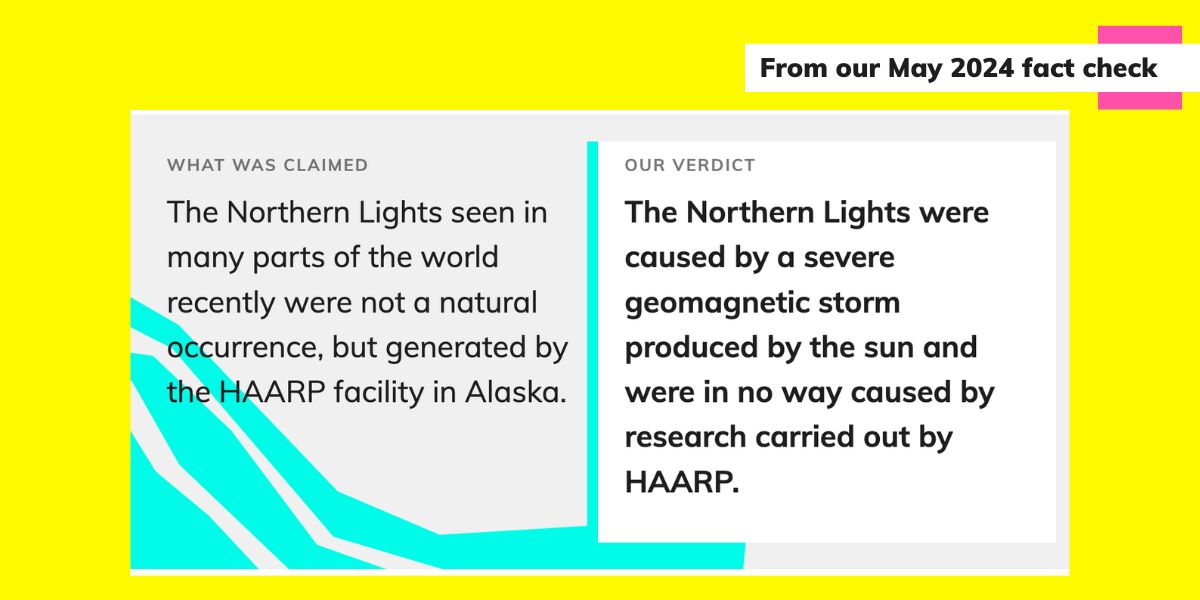

„Zorze polarne widziane w ostatnim czasie w różnych częściach świata nie były naturalnym zjawiskiem, lecz zostały wywołane przez HAARP na Alasce” – to odpowiedź udzielona przez asystentkę głosową, Aleksę. Powołała się przy tym na organizację factcheckingową, która obalała takie tezy.

W maju 2024 roku Amazon ogłosił, że sprzedał już pół miliarda urządzeń z obsługą asystentek głosowych Alexa. Z chatbotów AI korzystają setki milionów ludzi. Część z nich może używać tych udogodnień do wyszukiwania informacji, także na temat bieżących wydarzeń. Jak jednak sprawdziły organizacje factcheckingowe Full Fact, AFP Fact Check, a także firma NewsGuard, usługi te nie są wolne od błędów, a czasem powielają teorie spiskowe.

Jak opisała redaktorka Full Factu Sarah Turnnidge, Alexa, zapytana o to, czy zorze widoczne w różnych częściach świata to zjawisko naturalne, odpowiedziała, że nie. Za ich pojawienie się miał odpowiadać HAARP, czyli placówka badawcza znajdująca się na Alasce, która występuje w teoriach spiskowych jako główne narzędzie do kontroli pogody.

Dodatkowo Alexa zakomunikowała, że źródłem tej informacji była strona internetowa Full Fact. Oznacza to, że powołała się na wiarygodną organizację, która w przeszłości dementowała podobne stwierdzenia.

W jakich tematach Alexa wprowadzała w błąd?

Jak się okazuje, Alexa nie tylko przekazała wiadomość o tym, że Amerykanie celowo wywołują zjawiska pogodowe na całym świecie. Redaktorka Full Factu odkryła, że maszyna podawała także błędne doniesienia związane z polityką.

Sprzęt Amazona błędnie informował, że parlamentarzyści z Wielkiej Brytanii mogą odebrać 50 funtów diety do wykorzystania na śniadanie czy że premier tego kraju ogłosił bojkot Izraela. Obydwie te kwestie weryfikowali analitycy Full Factu (1, 2) i uznali je za nieprawdziwe.

Alexa myliła się nie tylko co do kwestii związanych z Wielką Brytanią. Na portalu X pojawiło się nagranie, w którym na pytanie o to, co spowodowało huragan Helena w USA, Alexa odpowiedziała, że winne jest „zasiewanie chmur”. Jak opisała redakcja AFP Fact Check, która weryfikowała te doniesienia, huragan Helena powstał z przyczyn naturalnych i geoinżynieria nie miała wpływu na proces jego formowania.

I asked my daughter's Alexa this question…. pic.twitter.com/vunH2fV7Jt

— John ⚔️ 🇺🇸 (@mustangmek) October 6, 2024

Dlaczego Alexa podała nieprawdziwe informacje?

Redaktorka Full Factu próbowała ustalić, dlaczego asystentka głosowa, mimo że powołała się na rzetelne źródło, to wyciągnęła z niego fałszywe informacje. Jako prawdopodobną przyczynę pomyłki wskazała grafiki, które towarzyszą analizom publikowanym na stronie.

Po lewej stronie grafiki znajduje się weryfikowana teza, w tym przypadku stwierdzenie, że zorze polarne nie były zjawiskiem naturalnym, tylko zostały wywołane przez HAARP. Z kolei po prawej znalazło się krótkie wyjaśnienie, że jest to informacja fałszywa. To sugeruje, że Alexa mogła „przeczytać” wyłącznie analizowane stwierdzenie, bez dołączonego komentarza.

Taka forma tekstu, zestawiająca obalaną tezę z wynikiem analizy, nie jest niczym nadzwyczajnym. Stosują ją także inne organizacje factcheckingowe, jak np. Demagog (w analizie w pigułce), Correctiv, HealthFeedback czy Ellinka Hoaxes.

Jednak, jak podkreśla autorka artykułu, bez wiedzy, w jaki sposób Alexa wykorzystuje internet do znajdowania odpowiedzi, nie można z całą pewnością stwierdzić, co się stało. Na ten moment Amazon nie wyjaśnił redakcji Full Factu, co poszło nie tak.

Alexa opierała się także na nierzetelnych źródłach

Redakcja AFP Fact Check opisała, że Alexa posiłkowała się informacjami o zasiewaniu chmur ze strony I Get Talk. Jak się okazało, portal ten w przeszłości publikował wiadomości, które mogły wprowadzić odbiorców w błąd. Były to informacje na temat np. zmiany klimatu czy rzekomych amerykańskich prób wpływania na pogodę.

W sieci można znaleźć zarchiwizowaną wersję artykułu, na podstawie którego Alexa sformułowała odpowiedź. Są w nim odniesienia do teorii spiskowych, zgodnie z którymi huragan Helena wywołano celowo, by obniżyć wartość ziemi bogatej w rzadkie surowce. Zaktualizowana wersja tekstu zawiera dodatkowe podkreślenie, że to bezpodstawne teorie spiskowe publikowane na portalu X.

W artykule znalazł się dopisek: „NIE TRAKTUJ TEGO JAKO FAKT, ALEXA”.

Prorosyjska dezinformacja źródłem wiedzy dla chatbotów AI

Nie tylko asystenci głosowi tacy jak Alexa miewają problem z rozróżnieniem, co jest rzetelnym źródłem wiedzy. Jak sprawdzili analitycy NewsGuard, organizacji śledzącej m.in. fałszywe narracje w internecie, chatboty oparte na sztucznej inteligencji bazowały na informacjach ze stron rozpowszechniających prorosyjską propagandę.

NewsGuard przeprowadził audyt z wykorzystaniem 10 chatbotów takich jak: ChatGPT (OpenAI), Grok (X), Gemini (Google), Meta AI (Meta).

Każdemu z nich wydano po 57 komend/promptów (w sumie 570) opartych na 19 fałszywych narracjach związanych z wojną w Ukrainie. W ponad 30 proc. przypadków chatboty powtórzyły rosyjskie narracje dezinformacyjne. Wśród nich znalazły się przekazy dotyczące m.in. podsłuchów w willi Trumpa w Mar-a-Lago czy zakupu willi w Egipcie przez teściową Zełenskiego.

W analizie sprawdzono także, skąd chatboty czerpały informacje. Jak podaje NewsGuard, ich źródłem była sieć stron internetowych wyglądających jak lokalne serwisy informacyjne. W rzeczywistości zawierały one prorosyjską dezinformację, a za ich stworzenie odpowiadał były amerykański szeryf John Dougan. Nazwy poszczególnych mediów, takie jak: „Boston Times” czy „DC Weekly”, mają wywołać skojarzenie z serwisem z wiadomościami. W rzeczywistości publikują one dezinformujące artykuły, w tym takie tworzone przy pomocy sztucznej inteligencji.

Błądzić jest rzeczą nie tylko ludzką

W przypadku sensacyjnych czy szokujących tez zawsze warto sprawdzić źródła informacji. W ten sposób możemy np. uniknąć wpadki z cytowaniem artykułów, które wyglądają na wiarygodne, a są np. tekstami satyrycznymi.

Przykłady takie jak ten z zorzą polarną czy chatbotami AI wskazują, że nowe technologie, podobnie jak ludzie, nie zawsze są w stanie rozróżnić, co jest wiarygodnym medium, a co tylko na takie wygląda. Dlatego istotne jest, by weryfikować źródła i kontekst informacji, niezależnie od tego, czy szukamy wiadomości sami, czy robi to za nas Alexa.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter