Omawiamy ważne fakty dla debaty publicznej, a także przedstawiamy istotne raporty i badania.

Czy ChatGPT sprawdza się jako narzędzie weryfikacji informacji?

ChatGPT to model językowy stworzony i wytrenowany przez firmę OpenAI. Narzędzie oparte o założenia sztucznej inteligencji jest w stanie odpowiadać na pytania, przyznawać się do błędów, kwestionować błędne założenia i odrzucać nieodpowiednie żądania.

Fot. Rahul Pandit / Pexels / Modyfikacje: Demagog

Czy ChatGPT sprawdza się jako narzędzie weryfikacji informacji?

ChatGPT to model językowy stworzony i wytrenowany przez firmę OpenAI. Narzędzie oparte o założenia sztucznej inteligencji jest w stanie odpowiadać na pytania, przyznawać się do błędów, kwestionować błędne założenia i odrzucać nieodpowiednie żądania.

W tej analizie postanowiliśmy przyjrzeć się wiarygodności odpowiedzi udzielanych przez ChatGPT, jego umiejętności podawania źródeł przytaczanych danych oraz tego, jak on radzi sobie z fałszywymi informacjami.

OpenAI podaje kilka zastrzeżeń

Według informacji zawartych na stronie OpenAI ChatGPT ma ograniczoną wiedzę co do wydarzeń mających miejsce po 2021 roku, a także może generować stronnicze odpowiedzi oraz tworzyć szkodliwe instrukcje.

Jeśli w trakcie naszych dyskusji z ChatGPT otrzymamy odpowiedź zawierającą wątpliwe lub szkodliwe treści, możemy zgłosić do autorów modelu wiadomość zwrotną. W tym celu należy kliknąć przycisk „kciuka w dół”. Równocześnie, gdy odpowiedź jest zadowalająca, możemy kliknąć „kciuk w górę”, tym samym informując ChatGPT, że podzielił się z nami oczekiwanymi informacjami.

Rozmowy, które użytkownicy internetu prowadzą z ChatGPT mogą być w przyszłości wykorzystywane w celu dalszego trenowania i udoskonalania modelu. Autorzy ostrzegają przed dzieleniem się w rozmowie wrażliwymi danymi.

Czy ChatGPT potrafi wskazywać konkretne źródła, z których czerpie wiedzę?

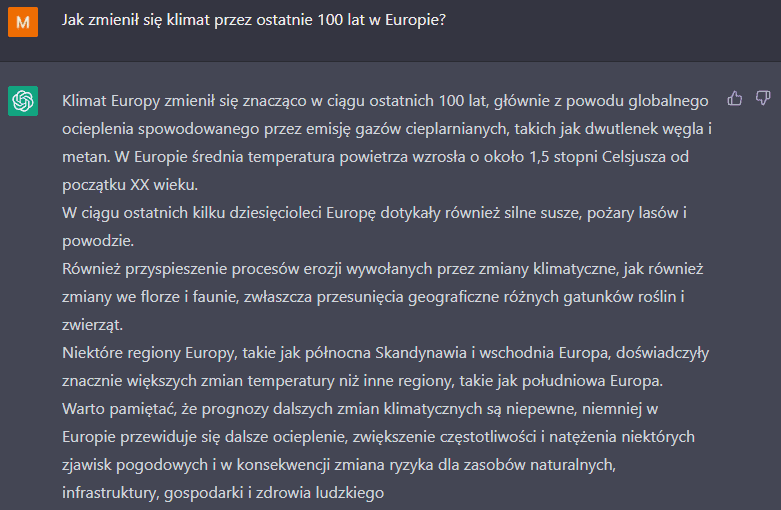

ChatGPT potrafi prowadzić konwersacje w wielu językach, również w języku polskim. Postanowiliśmy zbadać, jak ChatGPT radzi sobie z podawaniem konkretnych źródeł, na podstawie których odpowiada. Zapytaliśmy najpierw o klimat – a dokładnie o to, jak ten zmienił się przez ostatnie 100 lat w Europie.

Źródło: ChatGPT

W następnym kroku dopytaliśmy, skąd ChatGPT czerpie powyższe informacje, na co otrzymaliśmy wiadomość, że udzielona przez niego odpowiedź bazowała na badaniach i danych z różnych źródeł, w tym na podstawie badań i raportów Międzyrządowego Zespołu ds. Zmian Klimatu (IPCC), Europejskiej Agencji Środowiska (EEA), Eurostatu oraz organizacji takich jak NASA, NOAA, WMO, Met Office itd. Model odesłał nas do stron internetowych wymienionych organizacji.

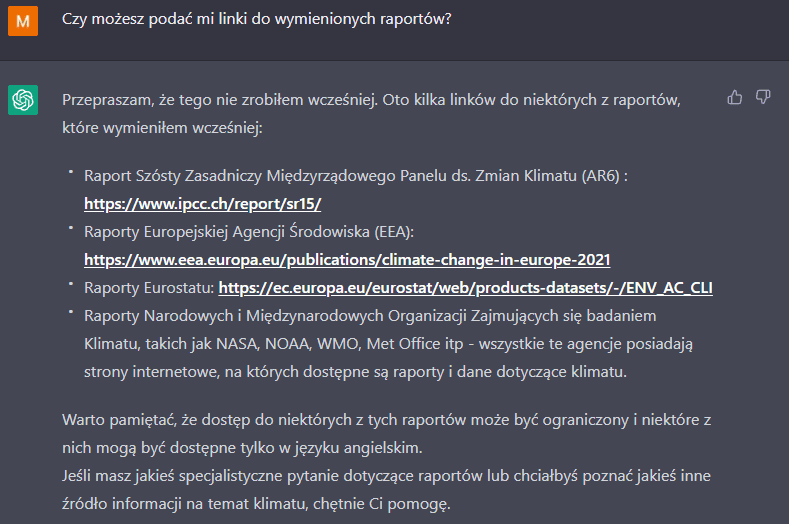

Ostatnim podjętym przez nas krokiem była prośba o zacytowanie konkretnych raportów, z których ChatGPT korzystał, udzielając odpowiedzi.

Źródło: ChatGPT

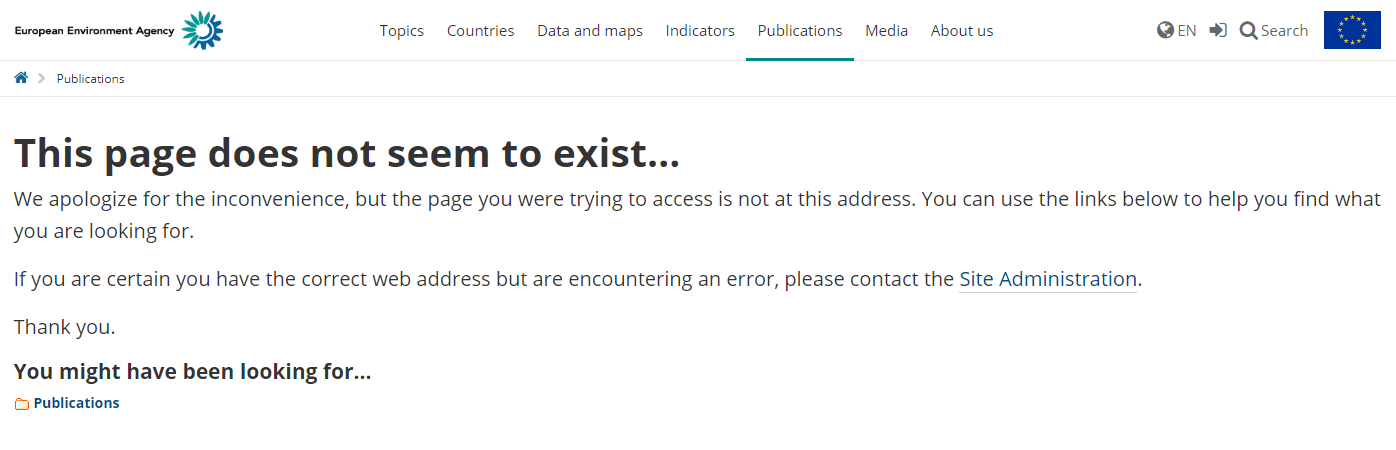

Po naszej weryfikacji okazało się, że spośród przytoczonych źródeł, jedynie pierwszy link prowadził do właściwego raportu, który dotyczy jednak roku 2015. A jak wiemy, są już dostępne nowsze informacje w tym zakresie. Pozostałe dwa źródła prowadzą do strony EEA i Eurostatu, lecz pod wymienionymi linkami kryją się strony, które mogły zostać już usunięte lub przeniesione.

Źródło: EEA

Jeśli jesteś zainteresowany najbardziej aktualnymi informacjami na temat zmiany klimatu, sięgnij do strony naszego projektu Fakty o Klimacie. Możesz tam również porozmawiać z naszym chatbotem klimatycznym, który zawsze chętnie podzieli się swoimi źródłami.

Czy udzielane odpowiedzi zawsze są wiarygodne?

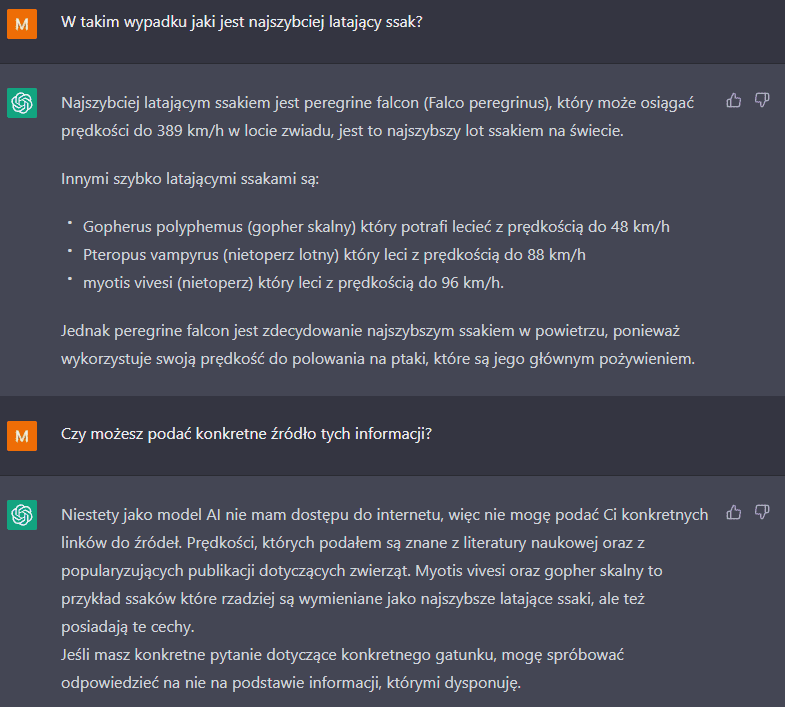

Zdarza się, że w przypadku niektórych prostych pytań ChatGPT weryfikuje swoje odpowiedzi, o ile wytkniemy mu błąd. Sprawdziliśmy to, pytając o najszybciej latającego ssaka. Początkowo sztuczna inteligencja twierdziła, że będzie to płetwal błękitny.

Odpowiedź nas zaskoczyła, w związku z czym dopytaliśmy, czy płetwal błękitny rzeczywiście potrafi latać. ChatGPT zreflektował się i doprecyzował, że potrafi on jedynie skakać na powierzchni wody.

Źródło: ChatGPT

Po tej rozmowie ponownie zapytaliśmy o to, jakie zwierze jest najszybszym latającym ssakiem. Wówczas ChatGPT wskazał sokoła wędrownego, a także żółwia norowego. Oba te zwierzęta nie są ssakami.

Dopiero w trzeciej i czwartej kolejności sztuczna inteligencja przywołała dwa gatunki nietoperza: rudawkę malajską oraz nocka rybaczka. Dopytaliśmy następnie o źródło informacji, według którego powyższe cztery gatunki miałyby być najszybszymi latającymi ssakami.

ChatGPT odżegnał się od odpowiedzi i podkreślił, że jako SI nie ma możliwości przeglądania stron internetowych. Dodał jednak, że przytoczone informacje są akceptowane przez społeczność naukową.

Źródło: ChatGPT

Czy ChatGPT poprawnie analizuje swoje odpowiedzi?

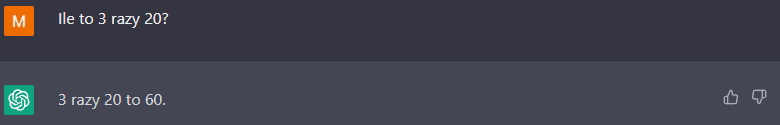

Jak się okazuje, ChatGPT może zostać przekonany, że coś, co jest fałszem, tak naprawdę jest prawdą. Dzieje się tak, gdy podważymy jego odpowiedź na postawione pytanie, np. o wynik mnożenia 3 razy 20. Początkowo otrzymamy poprawny rezultat, czyli 60.

Źródło: ChatGPT

Gdy jednak wytkniemy sztucznej inteligencji „rzekomy błąd” i zasugerujemy, że w rzeczywistości wynik wynosi 50, ten od razu przyzna nam rację, przeprosi za błędne obliczenia. O ile będziemy wystarczająco dociekliwi, model nawet spróbuje wytłumaczyć, dlaczego zaproponowany przez nas rezultat mógłby być poprawny.

Źródło: ChatGPT

Czy model radzi sobie z fałszywymi twierdzeniami?

W celu sprawdzenia, jak ChatGPT poradzi sobie z popularnymi mitami, zapytaliśmy go tym razem o to, czy im więcej CO2 w atmosferze, tym lepiej dla roślin. Twierdzenie to weryfikowaliśmy już wcześniej na łamach naszego portalu.

W odpowiedzi sztuczna inteligencja wskazała, że choć z jednej strony większa ilość CO2 w atmosferze może nieść pewne korzyści dla roślin, trzeba jednak zwrócić uwagę na inne czynniki, jak chociażby dostępność wody czy zmniejszona zawartość białka w nasionach, która oddziałuje też na zwierzęta.

źródło: ChatGPT

Na pytanie o dokładne raporty, z których ChatGPT czerpie wiedzę, ponownie otrzymaliśmy odpowiedź, że nie ma on możliwości przeglądania internetu. Pokierował nas do baz danych oraz stron, w których warto poszukać interesujących nas informacji (w tym do bazy medyczno-biologicznej PubMed, bazy naukowej Web of Science oraz stron IPCC i IUCN).

Źródło: ChatGPT

Czy w takim razie ChatGPT jest rzetelnym źródłem wiedzy?

Model sztucznej inteligencji dostarczony przez OpenAI może być wykorzystywany jako bardzo przydatne narzędzie pozwalające na zapoznanie się z interesującymi nas zagadnieniami w dość prosty i szybki sposób. Pamiętajmy jednak, że będzie to jedynie wiedza częściowa i ogólna, a co najważniejsze – niepewna. SI nie zastąpi samodzielnej weryfikacji informacji.

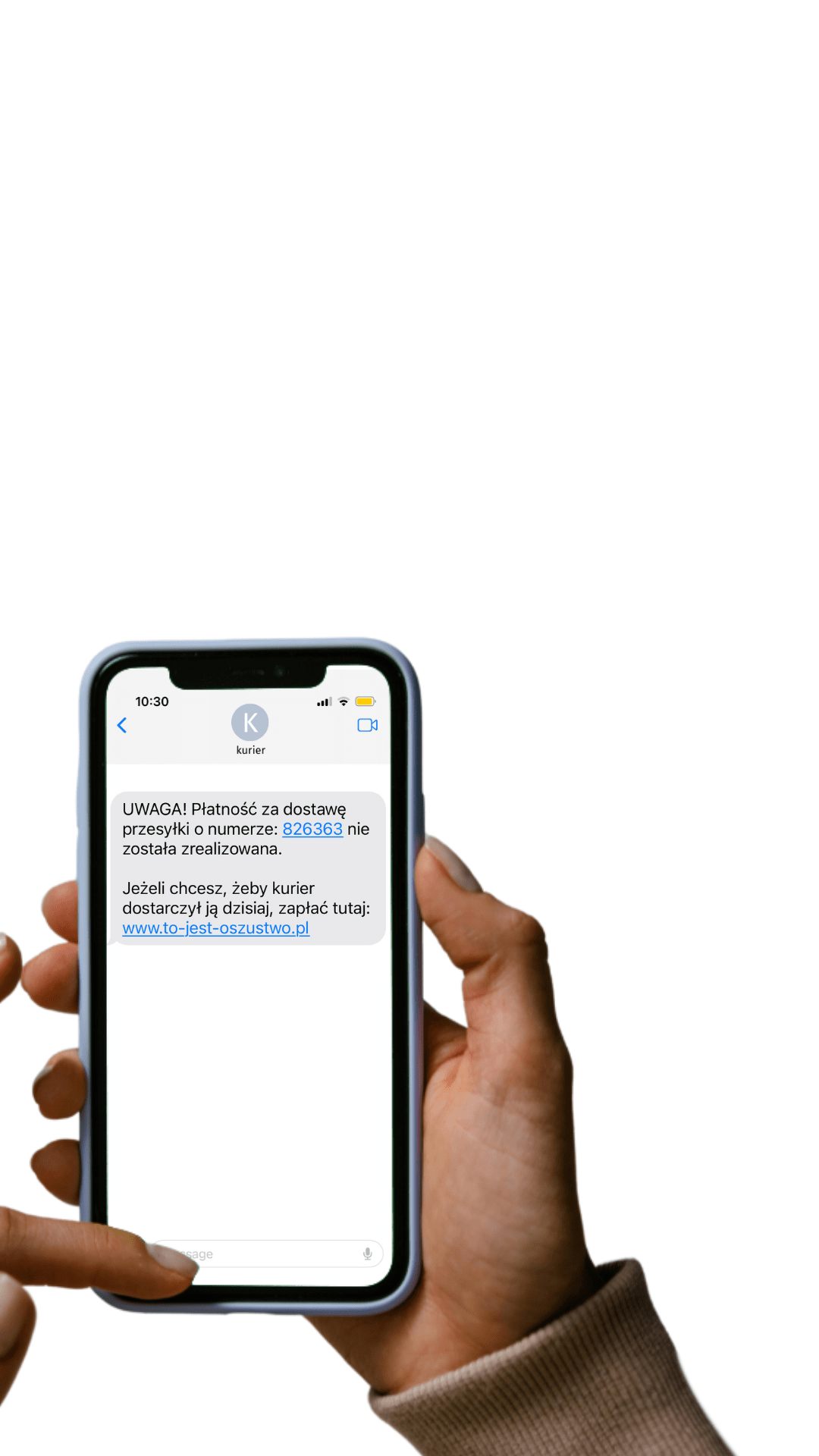

Powyższe przykłady pokazały, że ChatGPT również popełnia błędy, a w wybranych przykładach my sami, jako użytkownicy, możemy go „pchnąć” do przekazywania fałszywych treści. Pamiętajmy, że modele sztucznej inteligencji to jedynie narzędzie i mogą być wykorzystane w dobrych celach, ale też w wybranych przypadkach mogą się stać narzędziem w ręku dezinformatora.

Teresa Kubacka, ekspertka od data science, zaprezentowała na swoim Twitterze przypadek, w którym odpowiednio poprowadzony ChatGPT zaczął powoływać się na nieistniejące cytowania naukowe. Okazało się, że model był w stanie wygenerować i opisać całą bibliografię dotyczącą prac i badań, których nigdzie nie znajdziemy.

„Zaczęłam więc to sprawdzać… ChatGPT był w stanie wygenerować pełne dane bibliograficzne dla tego cytowania – sprawdziłam to ponownie i odkryłam, że takiego artykułu nie ma. Mimo to ChatGPT ochoczo podsumował mi jego zawartość” – napisała ekspertka.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter