Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

Jak deepfake i wygenerowane obrazy kreują teorie spiskowe?

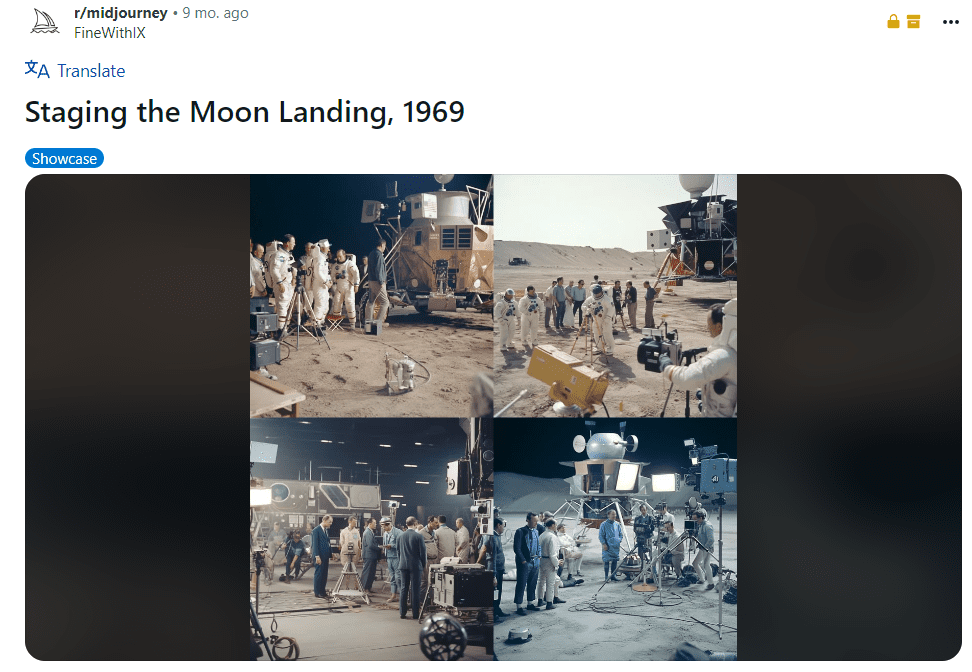

W marcu na łamach Vice.com opisano przypadek użytkownika Jordana Rhone’a, który zamieścił na Reddicie obrazy z nietypowego studia nagrań. Z opisu wynikało, że miały one przedstawiać nagrywanie lądowania na Księżycu. Szybko okazało się, że to zwykła prowokacja, której celem było sprawdzenie, jak można wzmocnić teorie spiskowe przy wykorzystaniu narzędzi do generowania obrazów.

fot. Facebook i Pixabay / Modyfikacje: Demagog

Jak deepfake i wygenerowane obrazy kreują teorie spiskowe?

W marcu na łamach Vice.com opisano przypadek użytkownika Jordana Rhone’a, który zamieścił na Reddicie obrazy z nietypowego studia nagrań. Z opisu wynikało, że miały one przedstawiać nagrywanie lądowania na Księżycu. Szybko okazało się, że to zwykła prowokacja, której celem było sprawdzenie, jak można wzmocnić teorie spiskowe przy wykorzystaniu narzędzi do generowania obrazów.

Fot. www.reddit.com

W ciągu ostatniego roku powstało już wiele podobnych wygenerowanych obrazów, a niektóre wpłynęły na rozpowszechnianie teorii spiskowych (celowo lub nie). Ta sprawa dotyczy niemal wszystkich dużych platform, w tym Facebooka, TikToka czy X (dawniej Twitter). Właściwie można powiedzieć, że to, co dzieje się na naszych oczach w tym zakresie, to mały poligon doświadczalny i próbka tego, co może nas czekać.

Wygenerowane dzieje ludzkości i teorie spiskowe z pogranicza fantasy

Wielu z nas z lekcji historii kojarzy zdjęcie ze Stalinem nad rzeką, z którego wymazano Nikołaja Jeżowa. Wtedy za takie modyfikacje odpowiadał tzw. retuszer. Dziś moglibyśmy z łatwością dokonać takich zmian w programie graficznym, ale wyobraźcie sobie tylko, co by było, gdyby ZSRR mogło generować obrazy przy użyciu AI. Wtedy reżim mógłby „zmienić” przeszłość czy też ówczesną teraźniejszość jeszcze łatwiej i szybciej. Nie musimy się nad tym długo rozwodzić, ale warto zauważyć, że współcześnie w sieci upowszechnia się forma manipulowania historią przy użyciu wygenerowanych obrazów.

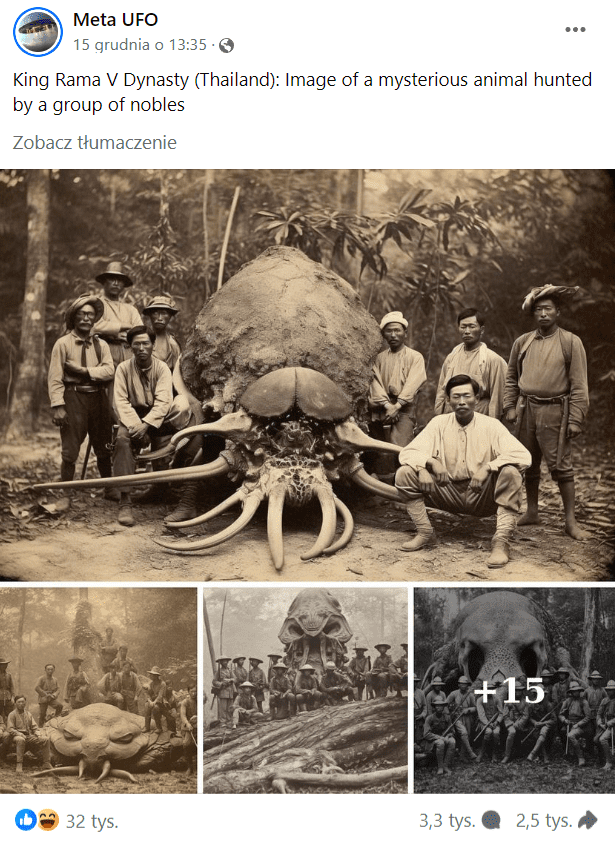

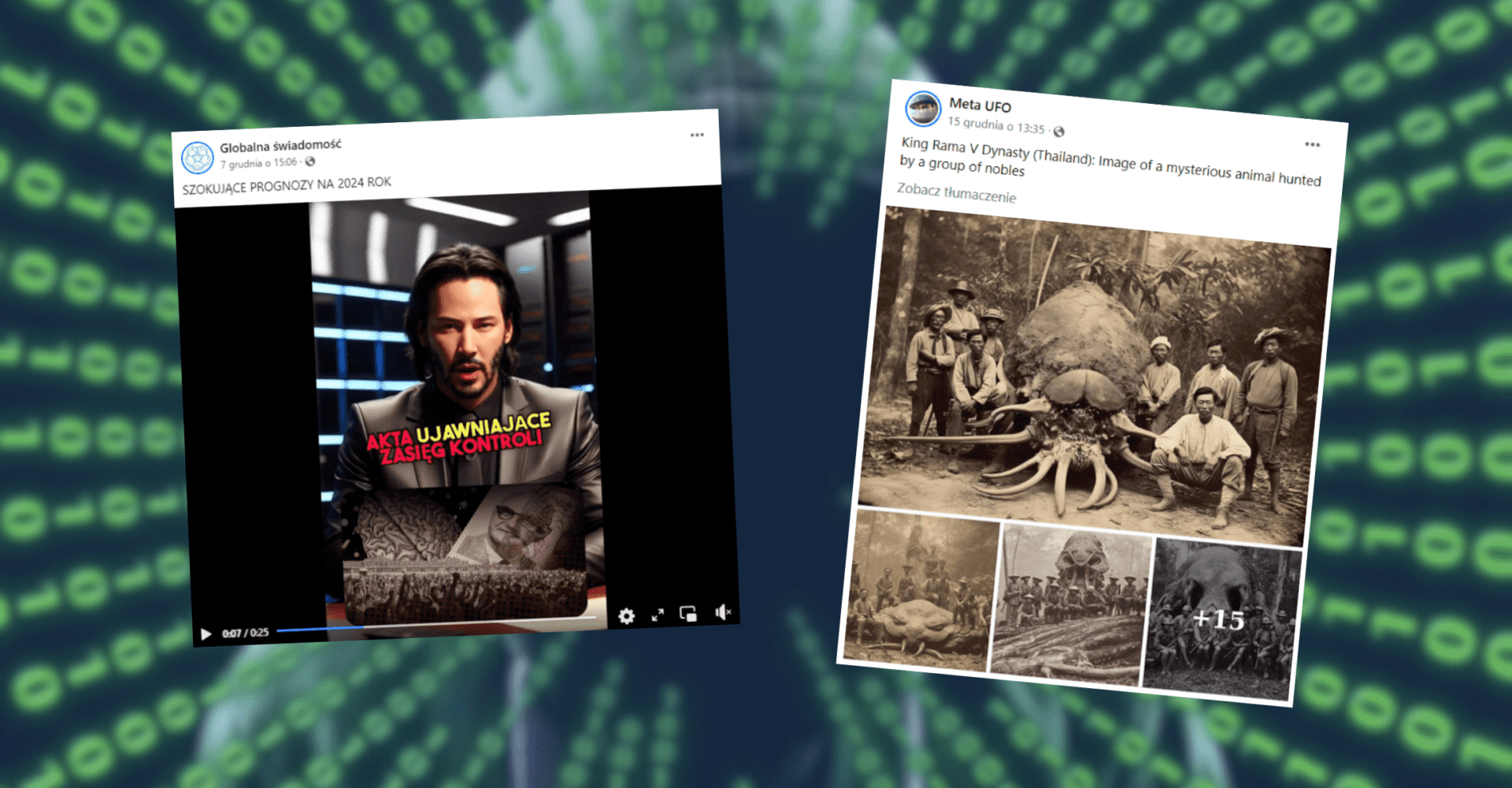

Wystarczy, że obraz przypomina stare zdjęcie – np. z powodu kolorystyki (zdjęcie czarno-białe lub sepia) czy pojawienia się na nim nieżyjących postaci. Niektóre z tych działań wpisują się w teorie spiskowe, które zakładają, że możni tego świata ukrywają przed nami fakty historyczne. Przykładowo na Facebooku konspiracyjny profil Meta UFO opublikował obrazy dziwnego stworzenia znalezionego w Tajlandii, a sam post zdobył ponad 30 tys. reakcji. O tym, że obraz został wygenerowany, świadczy nie tylko absurdalność tej sytuacji, ale i nietypowe detale, jak chociażby nadmiarowe dłonie.

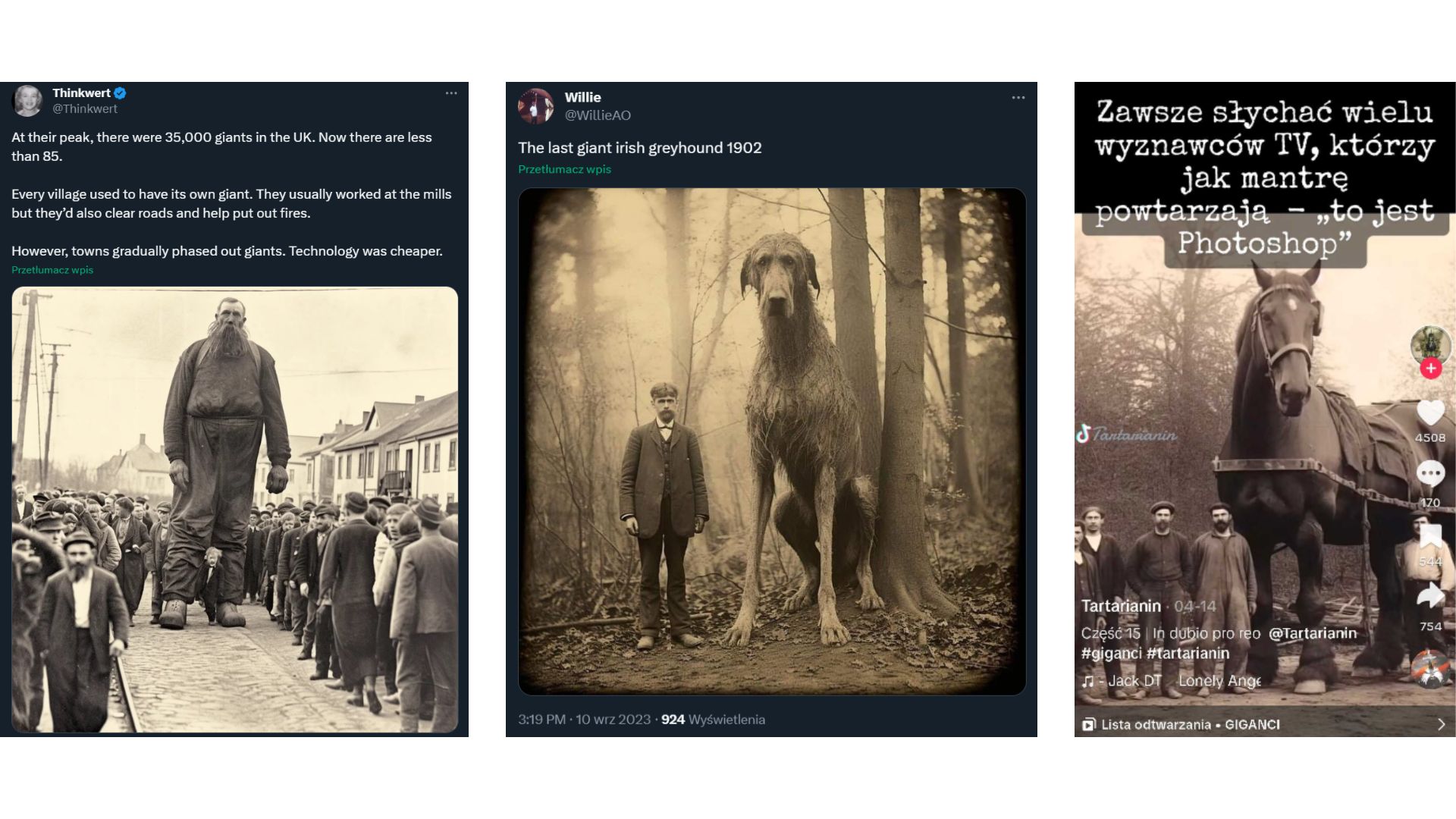

Jeden z wariantów teorii spiskowej o tuszowaniu historii głosi, że w niedalekiej przeszłości po świecie chodzili giganci lub inne nienaturalnie wielkie stworzenia, które towarzyszyły człowiekowi. Przykłady takich treści można znaleźć m.in. na X (dawniej Twitter) (1, 2) oraz TikToku.

Fot. www.x.com i www.tiktok.com

Wygenerowane „historyczne” obrazy, które mają „odkrywać sekrety”, w zasadzie przykrywają prawdę na temat historii. Obecność takich materiałów w sieci może prowadzić do zmylenia odbiorców i podważenia zaufania do potwierdzonych dotychczas ustaleń świata nauki. Jeszcze większy problem może pojawić się wtedy, gdy takie materiały będą zestawiane z prawdziwymi zdjęciami.

Deepfake Keanu Reevesa, który wyprowadza nas z Matrixa?

Wyobraźmy sobie ekran telewizora: kultowa scena z „Matrixa” z 1999 roku z Morfeuszem i Neo, który dostaje wybór: czerwona czy niebieska tabletka? Wybierze niebieską, która nie zmieni nic? Czy może weźmie tę czerwoną, która pozwoli mu poznać niedostępną dotąd prawdę? Taki obraz zapisał się nie tylko na kartach historii kinematografii. Współcześnie dla środowisk skupionych wokół teorii spiskowych kapsułki to synonim pozyskiwania wiedzy o wielkich spiskach rzeczywistego świata.

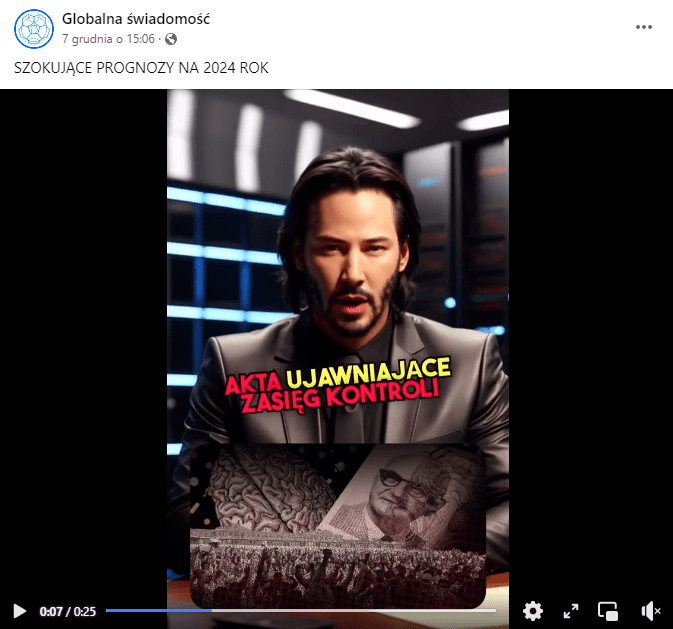

Powiązania „Matrixa” i teorii spiskowych sprawiły, że Keanu Reeves, odtwórca roli Neo, stał się bohaterem łatwych do rozpoznania – ale jednak – deepfake’ów. Taki sposób prezentacji materiału upowszechnił się m.in. na facebookowej stronie Globalna Świadomość, która od dawna zajmuje się promowaniem teorii spiskowych na różne tematy.

Wygenerowany Neo od razu budzi pewne skojarzenia, zaufanie, podkreśla przekaz i osadza w konspiracyjnym kontekście. Jednak tym razem nie pomoże w przebudzeniu, ale wprowadzi nas do fikcyjnej rzeczywistości. W tym przypadku to tylko wygenerowana „kukła” i każdy widzi to od razu. Niemniej sprawia to, że spiskowy przekaz jest jeszcze bardziej przystępny dla odbiorcy.

To przede wszystkim forma znacznie szybsza do przyswojenia niż długi tekst ujawniający skomplikowane spiski. Co jeżeli obraz wyglądałby jeszcze bardziej realnie i takie teorie padłyby z ust uznanej osoby publicznej? Zastanawiające pozostaje też to: czy osoby takie jak Keanu Reeves w ogóle chcą, by wykorzystywać ich wizerunek w ten sposób?

Hotel satanistów – czyli historia o tym, jak AI oślepia, a nie ujawnia fakty

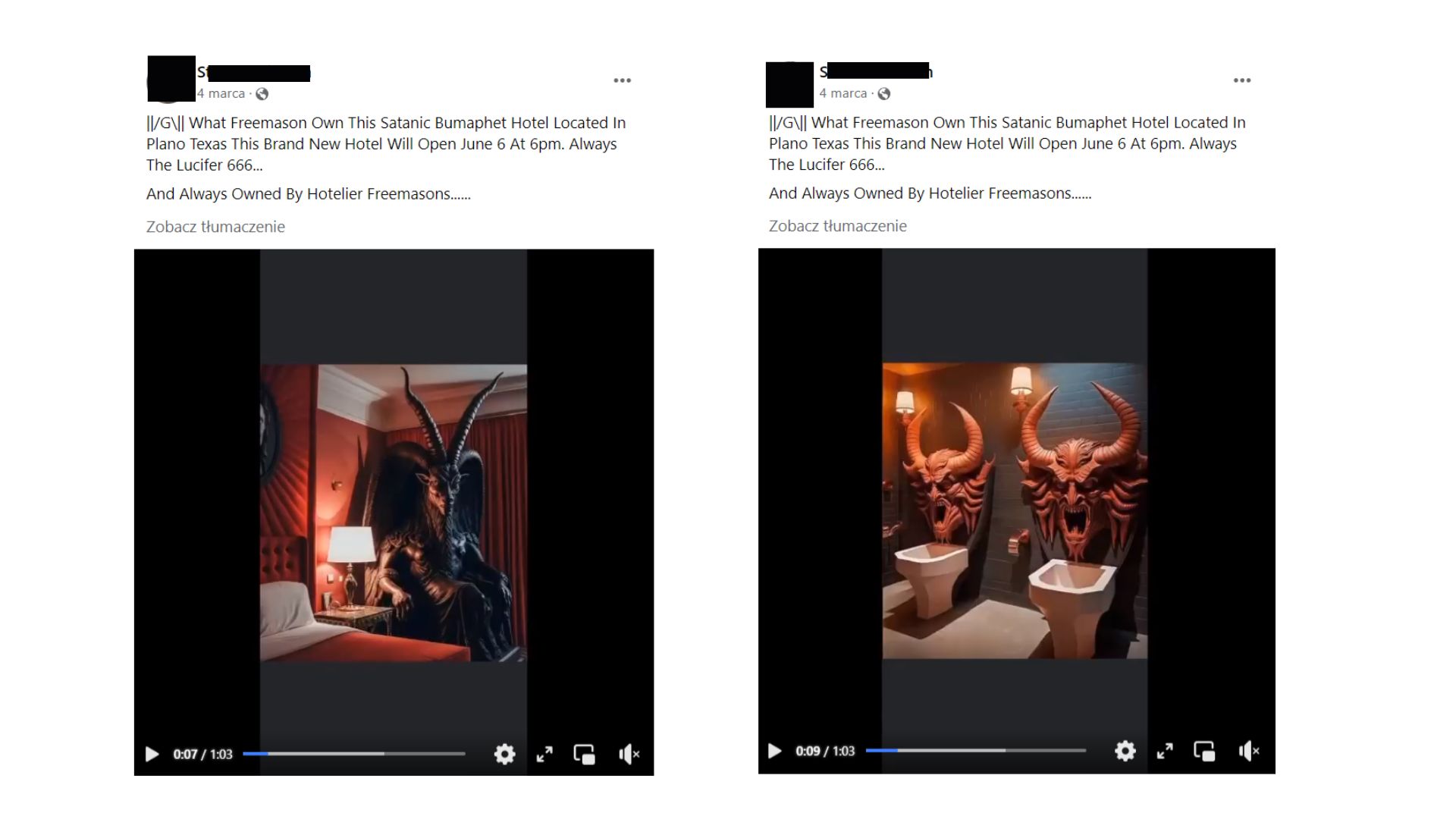

W latach 80. XX wieku w Stanach Zjednoczonych wybuchła panika moralna znana dziś pod nazwą „satanistycznej paniki”, która w najskrajniejszej formie polegała na powszechnym dostrzeganiu wpływu satanistów w wielu dziedzinach życia. Od tamtej pory notorycznie zdarza się, że konkretne wydarzenia na świecie są opisywane jako efekt skrzętnie zaplanowanych i niecnych działań czcicieli szatana, nawet jeżeli nie ma ku temu żadnych podstaw. Jak się okazuje, w doszukiwaniu się takich tłumaczeń zjawisk dziś pomóc może również sztuczna inteligencja i generatory grafik.

Przerażające obrazy diabła nad łóżkami, mroczne korytarze, palone krzyże i… niefunkcjonalne toalety z twarzami demonów zamiast deski. Pytanie: kto chciałby spać w takim miejscu? Zdaniem niektórych: sataniści. Na TikToku, X i Facebooku od jakiegoś czasu upowszechniane są obrazy, które mają przedstawiać hotel satanistów w Teksasie. Ponoć obiekt miał zostać otwarty 6 czerwca, jednak jak do tej pory nie widać śladu po tym budynku.

Dlaczego? Ponieważ były to po prostu grafiki wygenerowane przez sztuczną inteligencję dla żartu, o czym pisali autorzy. Jak to jednak bywa w mediach społecznościowych – wiele obrazów traci swój pierwotny kontekst i zyskuje nową, barwną historię.

To zresztą nie jedyny przypadek, gdy sztuczna inteligencja pomogła wyolbrzymić wpływy satanistów na świecie. W innym wpisie podano np., że szkoła szatana w Pensylwanii organizuje zajęcia dla dzieci, co umożliwiło orzeczenie amerykańskiego sądu. I tu podobnie – można było sprawdzić obraz, zanim ktoś postanowił go udostępnić.

Wiele osób komentowało takie wpisy (1, 2, 3) z przerażeniem i zdziwieniem. Przez wygenerowane obrazy każdy spisek i niecne działania mogą ziścić się na naszych oczach. Hotel satanistów czy zajęcia z diabłem dla dzieci to dość skrajne przykłady, jednak pokazują one, że sztuczna inteligencja może być użyta do pobudzania konspiracyjnych nastrojów, a nawet do wywoływania strachu wśród ludzi, którzy będą żyć w obawie przed zagrożeniem.

Niech czujność nie zasypia – sprawdzajmy wszystko bardzo dokładnie

Trudno przewidzieć wszystkie możliwe metody wykorzystania narzędzi opartych na sztucznej inteligencji do wspierania konspiracyjnego myślenia. Tak samo jak to, czy praktyka ta stanie się powszechna i niebezpieczna. Przede wszystkim pamiętajmy, że social media nie są miłym i przyjemnym miejscem, w którym wszystkie informacje są pewne. Wyglądają może bardziej… jak te diabelskie toalety i poplątane korytarze, w których łatwo się zagubić.

Jedno jest pewne – dopóki nie powstaną efektywne metody oznaczania wszystkich takich materiałów jako wygenerowane przez AI, będziemy zdani na własną spostrzegawczość, wsparcie narzędzi weryfikacji (np. TheHive czy też AI or Not) i dokładne sprawdzanie treści.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter