Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

Przyspieszony rozwój sztucznej inteligencji. Więcej szans, a gdzie pytania o zagrożenia?

Z dnia na dzień przyspiesza proces rozwoju narzędzi sztucznej inteligencji – wszak mało kto o tym pamięta, ale toczy się właśnie bitwa o wielkie pieniądze, które mogą zarobić giganci tech, będąc o krok przed konkurencją. W tym wszystkim brakuje pytań o zagrożenia; wciąż więcej jest zachwytów nad tym, „w czym AI może nam pomóc” i jakie czynności za nas wykonać, niż dyskusji o ryzyku.

Fot. cottonbro studio / Pexels / Modyfikacje: Demagog

Przyspieszony rozwój sztucznej inteligencji. Więcej szans, a gdzie pytania o zagrożenia?

Z dnia na dzień przyspiesza proces rozwoju narzędzi sztucznej inteligencji – wszak mało kto o tym pamięta, ale toczy się właśnie bitwa o wielkie pieniądze, które mogą zarobić giganci tech, będąc o krok przed konkurencją. W tym wszystkim brakuje pytań o zagrożenia; wciąż więcej jest zachwytów nad tym, „w czym AI może nam pomóc” i jakie czynności za nas wykonać, niż dyskusji o ryzyku.

Z jednej strony: ChatGPT od Open AI, inwestycja Microsoftu w tę firmę, ale i prace nad Bingiem, a także Bardem Google’a; setki start-upów ogłaszające własne rozwiązania sztucznej inteligencji, wtyczki i rozszerzenia bazujące na AI do obecnych już na rynku produktów. Z drugiej strony: chińskie prace nad sztuczną inteligencją, która ma myśleć we „właściwy sposób”, czyli zgodny z linią partii. Choć pojawiły się głosy o potrzebie spowolnienia prac nad narzędziami AI, a w szczególności nad modelami wyższymi niż obecny GPT-4 (na co wskazywał list otwarty, który podpisał choćby Elon Musk), to oczywistym jest, że w tym technologicznym wyścigu nikt się nie zatrzyma, a wręcz przeciwnie: jak ujawniły media, właściciel Twittera sam ma także pracować nad własnym modelem SI. Brakuje jednak pytań o zagrożenia, a w debacie publicznej przebijają się głównie słowa wskazujące na ewentualne obawy o rynek pracy i o to „w czym może zastąpić nas ChatGPT” i „jakie zadania wykonać”. Jednak to nie wszystko, a lista zagrożeń jest znacznie dłuższa.

Możliwość tworzenia złośliwego kodu

ChatGPT nie jest używany jedynie przez osoby, dla których etyka jest jedną z podstawowych wartości. Szybko okazało się, że wykorzystują go także grupy haktywistyczne czy cyberprzestępcy do generowania złośliwego kodu, co jest dla nich jeszcze łatwiejsze i szybsze niż było do tej pory.

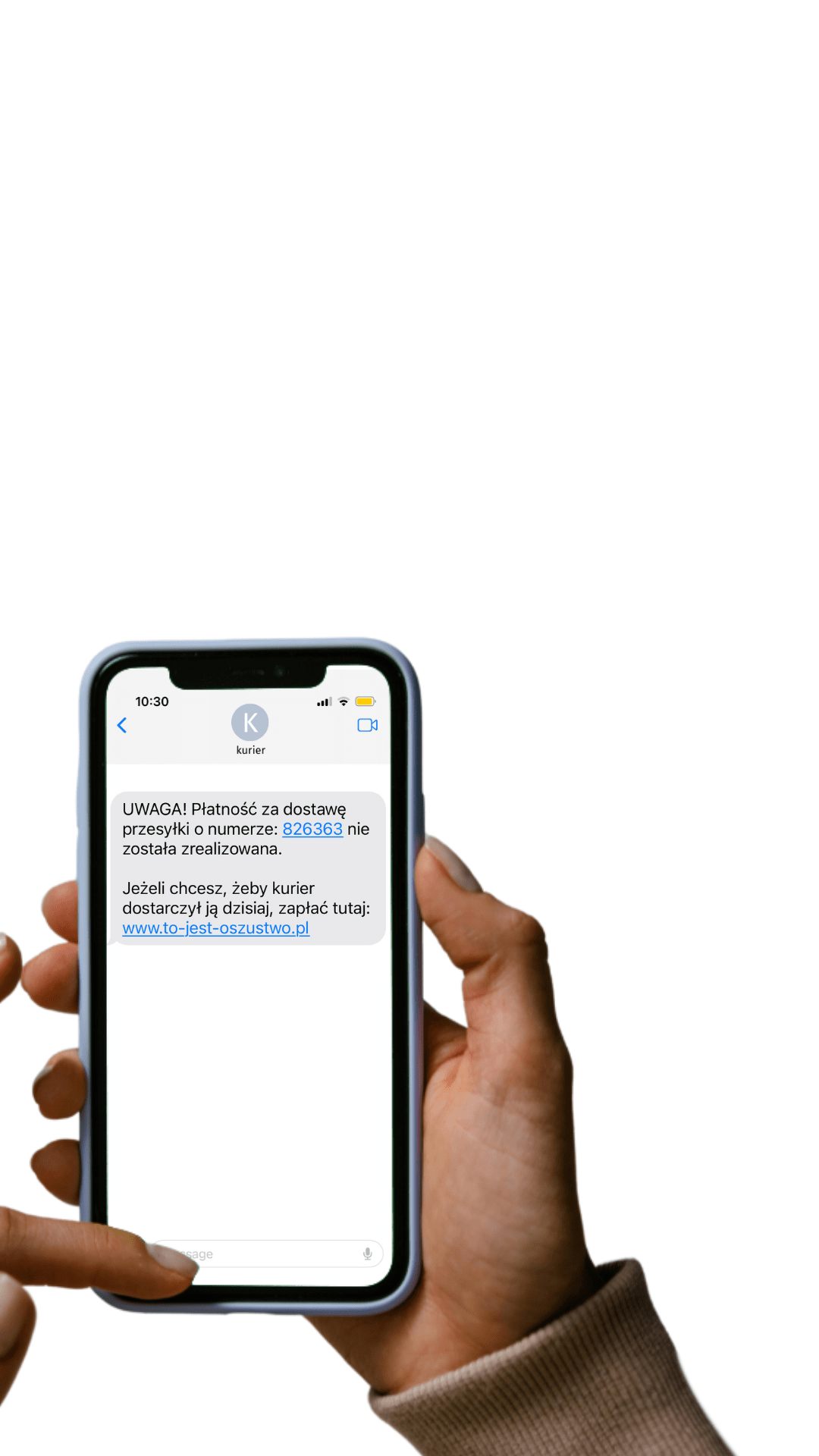

Dodatkowo chatbot łatwo może wygenerować szkodliwe treści, które umożliwą oszukanie innych użytkowników poprzez wysyłanie np. wiadomości phishingowych. Przykład treści takiego złośliwego maila lub SMS-a, zaproponowany przez chatbota nie będzie oczywiście zawierał linku do strony, za pośrednictwem której po wpisaniu danych – może dojść do ich wyłudzenia, bądź też w przypadku bankowości elektronicznej – utraty pieniędzy, ale może stanowić generator dla tego typu kampanii, jeszcze przyspieszający ich produkcję.

Ryzyko dezinformacji

O tym, że ChatGPT może być puszką Pandory dla fact-checkingu pisaliśmy w tej analizie, co wykazali już naukowcy m.in. NewsGuard, którzy testowali go i stwierdzili, że nie posiada zabezpieczeń przed generowaniem i przekazywaniem dezinformacji, choć w pewnych przypadkach potrzebnych było aż pięć prób, aby ostatecznie podał fałszywą informację.

Obecnie w menu startowym można przeczytać ostrzeżenie, że informacje wygenerowane przez to narzędzie mogą zawierać niepoprawne dane; że okazyjnie może produkować „krzywdzące lub dyskryminujące informacje”, a także, że baza wiedzy jest ograniczona do 2021 roku. Co oznacza, że na temat wojny w Ukrainie i rosyjskiej inwazji ChatGPT nie udzieli nam poprawnych odpowiedzi.

Szybkość rozpowszechniania się deepfake

ChatGPT nie jest jedynym narzędziem, które w krótkim czasie zyskało miliony użytkowników. Programy do obróbki obrazu wedle poleceń wydawanych przez użytkownika i tworzenia nowych form grafik, takie jak Midjourney czy DALL-E2, mogą posłużyć do generowania deepfake’ów, których przeciętny internauta wciąż nie potrafi odróżnić od autentycznego obrazu.

To oznacza jeszcze większą skalę powstawania fałszywych ilustracji, które będą dopasowywane do politycznych wydarzeń, ale i ryzyko w postaci fejkowych wideo, których celem może być np. zdyskredytowanie przeciwnika. Programy te wciąż nie wprowadziły jasnego systemu oznaczania tego typu treści, by wprost informować (przy pomocy np. znaku wodnego), że obraz to tylko fikcja, a nie realne zdarzenie. Oznacza to jeszcze więcej pracy dla dziennikarzy i fact-checkerów, ale także dla samych użytkowników platform społecznościowych, którzy – jeśli będą chcieli pozostać świadomymi i zdawać sobie sprawę z tego, jakie informacje są prawdziwe – będą musieli się sami kształcić i zachować stałą czujność. O tym, dlaczego warto oznaczać tego typu treści, piszemy w tym materiale.

Ryzyko dla prywatności

Jak pisaliśmy na łamach CyberDefence24.pl, w ubiegłym miesiącu miał miejsce błąd w działaniu ChatuGPT, który pozwalał innym użytkownikom podejrzeć zapytania – „tematy” konwersacji ze słynnym botem. Wyciek dotyczył konwersacji z wersji Plus usługi ChatGPT.

Według firmy problem ten dotknął ok. 1,2 proc. wszystkich abonentów płatnej wersji usługi. W wyniku incydentu mogło dojść do naruszenia bezpieczeństwa prywatnych danych. Wyciekły także dane takie jak: imiona i nazwiska abonentów, ich adresy e-mail, adresy do rozliczania płatności, a częściowo – informacje dotyczące kart płatniczych. W związku z tym firma ogłosiła program bug bounty, w ramach którego można wygrać 20 tys. dolarów za wykrycie podatności, luk i błędów w jej oprogramowaniu.

Nikt głośno nie mówi na temat prywatności i ochrony danych, jakie wprowadzane są codziennie przez miliony użytkowników chatbota. Nie wiadomo do końca, co się właściwie z nimi dzieje, a na wszelki wypadek wielkie firmy technologiczne ostrzegły swoich pracowników, aby korzystając z narzędzi AI, nie wprowadzali do nich wrażliwych informacji o sobie i o firmie. Z kolei OpenAI informuje tylko na swojej stronie, że „zbiera informacje”, a rozmowy z chatbotem „mogą być przeglądane przez trenerów AI w celu ulepszenia ich systemów”. Dodatkowo ostrzega, by „nie udostępniać żadnych poufnych danych w swoich rozmowach”. Czy to wystarczy? Odpowiedź jest dość oczywista.

Etyka a sztuczna inteligencja

Czy i gdzie istnieje granica między sztuczną inteligencją a etyką? Choć jeszcze do niedawna to pytanie mogło wydawać się z natury filozoficzne, dziś zadaje je coraz więcej osób: nie tylko naukowcy, lecz także eksperci, regulatorzy czy dziennikarze. Zadawane jest jednak zbyt późno. Czy istnieje jeszcze szansa, by ten dystans nadrobić? Czy sztuczna inteligencja może pomagać sędziemu w podejmowaniu decyzji i mieć pośrednio wpływ na wyrok? To już się dzieje – kolumbijski sędzia twierdził, że podejmując decyzję w czasie jednej z rozpraw, użył narzędzia sztucznej inteligencji. Czy jeśli popełniłby błąd, mógłby uzasadnić to błędem sztucznej inteligencji? Tego typu dylematów moralnych będzie coraz więcej.

Poszanowanie praw autorskich

Inną problematyczną kwestią są prawa autorskie – kto w świetle legislacji jest właścicielem „dzieła” stworzonego przez sztuczną inteligencję? Komu przysługują prawa osobiste i majątkowe? Co z rozpowszechnianiem, kopiowaniem czy przerabianiem tego typu treści?

„Nie jest zatem utworem dzieło powstałe w wyniku działania sił natury, stworzone przez istoty żywe inne niż człowiek, a także wykreowane przez maszyny. W konsekwencji, efekty kreacji narzędzi AI nie są utworami i nie podlegają ochronie wynikającej z przepisów prawa autorskiego” – można przeczytać w opinii rzecznika patentowego Macieja Priebe z Kancelarii Prawnej Chałas i Wspólnicy.

Zwraca on także uwagę, że „regulamin ChatGPT przenosi na użytkownika prawa do dzieł stworzonych z wykorzystaniem tego narzędzia, ale także pełną odpowiedzialność, w tym wynikającą z ich publikacji”.

Pewne wątpliwości w tym zakresie oznaczają jednak, że korzystający z narzędzi AI będą musieli poznać nowe przepisy (a przynajmniej powinni) regulujące możliwość korzystania z takich rozwiązań.

Brak należytej edukacji

Na koniec ostatni, choć nie mniej ważny argument braku należytej edukacji. Od dawna organizacje factcheckingowe apelują o wprowadzenie do podstawy programowej szkół lekcji krytycznego myślenia i zwracają uwagę na konieczność nauki rozpoznawania fake newsów oraz dezinformacji. Jak na razie jedyna edukacja to inicjatywy oddolne, prowadzone często w postaci dodatkowych zajęć czy godziny wychowawczej.

Potrzebne jest natomiast systemowe podejście obejmujące najmłodszych, dorosłych i seniorów, każdy z nas bowiem jest codziennie narażony na styczność z dezinformacją. To od naszej edukacji zależy, czy poradzimy sobie z odróżnieniem prawdy od fikcji. Tym bardziej że wraz z upowszechnieniem się narzędzi sztucznej inteligencji, skala wyzwań będzie jeszcze większa. Musimy być na nie gotowi.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter