Omawiamy ważne fakty dla debaty publicznej, a także przedstawiamy istotne raporty i badania.

Nieczułe maszyny – gdzie leży zagrożenie ze strony AI?

Opublikowano kolejny list otwarty dotyczący ryzyka związanego z rozwojem technologii AI. W jednym zdaniu pojawiły się takie słowa jak „sztuczna inteligencja”, „wyginięcie rasy ludzkiej”, „pandemia” i „wojna nuklearna”. Przesada? Niekoniecznie. I nie chodzi tu o filmowy motyw „buntu maszyn”.

Fot. Arseny Togulev / Unsplash / Modyfikacje: Demagog

Nieczułe maszyny – gdzie leży zagrożenie ze strony AI?

Opublikowano kolejny list otwarty dotyczący ryzyka związanego z rozwojem technologii AI. W jednym zdaniu pojawiły się takie słowa jak „sztuczna inteligencja”, „wyginięcie rasy ludzkiej”, „pandemia” i „wojna nuklearna”. Przesada? Niekoniecznie. I nie chodzi tu o filmowy motyw „buntu maszyn”.

We wtorek 30 maja organizacja non-profit Center for AI Safety opublikowała list otwarty, który podpisało ok. 350 ekspertów od technologii oraz osób publicznych. Wśród nich był np. Sam Altman, prezes OpenAI, firmy odpowiedzialnej za ChatGPT, członkowie Google DeepMind, grupa naukowców czy kanadyjska piosenkarka Grimes.

List był krótki:

„Zmniejszanie ryzyka wyginięcia rasy ludzkiej stwarzanego przez sztuczną inteligencję powinno być priorytetem globalnym, tak samo jak przeciwdziałanie innym zagrożeniom na skalę społeczną, takim jak pandemie czy wojny nuklearne”.

Trudno powiedzieć, „co autor miał na myśli”, ponieważ sygnatariusze nie zagłębili się w szczegóły swoich obaw. Być może to dobry moment, żeby zastanowić się nad potencjalnymi zagrożeniami, tym bardziej że z niektórymi z nich musimy się mierzyć już teraz.

(Raczej) nie chodzi o świadome maszyny

Nie, przed opublikowaniem tego komunikatu nie doszło do buntu maszyn, żaden Ultron z armią żołnierzy-robotów nie stwierdził, że najlepszym rozwiązaniem dla Ziemi jest jej depopulacja, żadna drukarka nie zapytała: „Czy ta jednostka ma duszę?” (a przynajmniej nic o tym nie wiemy).

Nasze skojarzenia w kwestii ryzyka związanego z AI mogą iść w tę stronę (tym bardziej w kontekście porównania do wojny nuklearnej), ponieważ uzyskanie świadomości przez AI i jej bunt wobec człowieka to motywy pojawiające się w wielu opowieściach science-fiction. Jednocześnie taki scenariusz – jako że zawsze był elementem fantazji – może nam się wydawać mało prawdopodobny, a stąd krótka droga do zlekceważenia innych zagrożeń związanych z AI.

Choć Sam Altman, zeznając przed amerykańskim senatem, stwierdził, że AI „mogłaby rozwinąć zdolność do samoreplikacji i samodzielnego wydostawania się na wolność”, odstawmy na razie na bok teorie o zbuntowanych maszynach. Istnieją inne rodzaje ryzyka związanego z tą technologią, którym warto się przyjrzeć. Niektóre z zagrożeń stały się faktem już w przeszłości i mogą się powtórzyć, inne obserwujemy teraz i mamy już dowody na ich destrukcyjny wpływ na społeczeństwo.

Kolejna rewolucja przemysłowa?

Należy zaznaczyć, że nie wszyscy eksperci utrzymują, że sztuczna inteligencja jest niebezpieczna. Mówi się o tym, że zdolności analityczne maszyn mogą przysłużyć się medycynie. Mogą też pomóc w rozwiązywaniu skomplikowanych problemów i w sposób nieszablonowy, ale efektywny, wskazać kierunek np. w kwestii radzenia sobie z ociepleniem klimatu (zawczasu eliminując opcję usunięcia z powierzchni Ziemi ludzi, którzy je spowodowali).

W tej kwestii sygnatariusze listu mogą mieć rację, że sztuczna inteligencja jest jak technologia atomowa. Można ją wykorzystać do wysadzenia miasta albo do dostarczenia mu energii, w zależności od tego, kto trzyma palec na czerwonym przycisku.

Ryzykiem, o którym od dawna wspomina się w kontekście AI, jest mocne odbicie się na gospodarce. Niekoniecznie chodzi tylko o powtórkę takich wydarzeń jak „flash crash” z 2010 roku, kiedy – jak sądzą eksperci – m.in. użycie algorytmów na giełdzie doprowadziło do szybkiego (i chwilowego) krachu. Chodzi o coś, co już wydarzyło się w naszej historii, np. w trakcie rewolucji przemysłowej: ryzyko, że nowa technologia pozbawi pracy ludzi, a w tym przypadku może chodzić o setki milionów etatów.

Można stwierdzić, cynicznie lub idealistycznie, że to cena za rozwój ludzkości. Niektórzy widzą w tym szansę lub ryzyko upadku kapitalizmu i odbudowanie nowego społeczeństwa, w oparciu o wprowadzenie płacy dla wszystkich, niezależnie od tego, czy pracują, czy nie. Musiałoby to jednak wiązać się z przebudową kultury i sposobu myślenia, co niekoniecznie przebiegłoby bezboleśnie. Należy jednak zaznaczyć, że koszty takiego scenariusza poniesiemy w hipotetycznej przyszłości. Tymczasem za pierwsze lata używania AI płacimy już teraz.

Nie chodzi o gniewne androidy

Głównie dlatego, że sztuczna inteligencja, z którą mamy do czynienia na co dzień, nie ma emocji. Nie miała wyrzutów sumienia, kiedy każdego dnia podrzucała nam emocjonujące, kontrowersyjne treści. Nie czuła wstydu i nie wahała się „informować” nas o teoriach spiskowych czy o tym, że szczepionki rzekomo zabijają dzieci.

Innymi słowy, aktualnie przy tym metaforycznym czerwonym przycisku siedzą ludzie, który wymyślają, jak wykorzystać AI, aby zarobić. Algorytmy mediów społecznościowych oparte na tej technologii projektowane są tak, aby przykleić nas do ekranu. Nauczyły się już, że angażują nas treści emocjonujące – nawet jeśli chodzi o emocje negatywne, które mogą wpłynąć na to, co sami odczuwamy. Potrafią też być stronnicze politycznie.

Forma, w jakiej działają media społecznościowe, zachęcała do tworzenia treści w tonie oburzenia i miała tendencje do popychania nas w stronę skrajnych poglądów. Źródłem zagrożenia nie są zatem gniewne androidy, ale mogą nim być gniewni, zradykalizowani i podzieleni ludzie.

Kwestia ta od dłuższego czasu wywoływała wątpliwości naukowców, dziennikarzy technologicznych, fact-checkerów czy pracowników platform. Tymczasem do technologii, którą nosimy w kieszeniach od lat, dołączają nowe narzędzia.

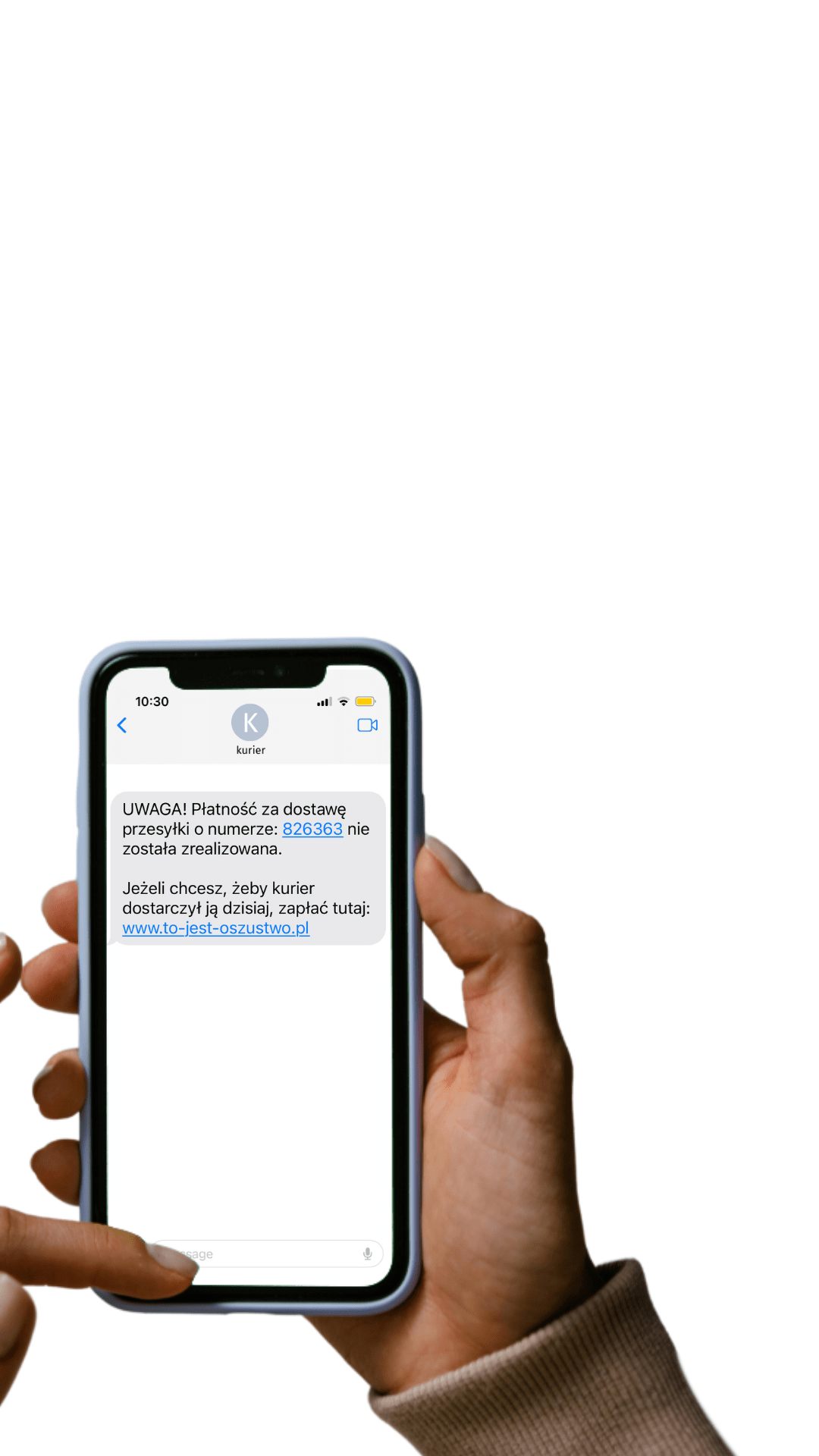

Automatyzacja dezinformacji

O tym, że liczba incydentów z niewłaściwym wykorzystaniem AI gwałtownie wzrosła w 2022 roku, mogliśmy przeczytać w raporcie naukowców Uniwersytetu Stanforda. Wspomniano w nim m.in. o technologii deepfake, która pozwala na wizualne imitowanie dowolnej osoby.

Do tego dochodzą inne narzędzia, które mogą być wykorzystywane do szerzenia dezinformacji, np. przy pomocy kilkusekundowej próbki głosu mogą naśladować każdego. Są też takie, które są w stanie stworzyć obrazek przypominający zdjęcie z aresztowania Donalda Trumpa, czy wideo, w którym Wołodymyr Zełenski rzekomo ogłasza poddanie się Ukrainy.

W kontekście potencjalnego ryzyka przytacza się też ChatGPT, oraz inne, podobne mu chatboty. ChatGPT jest jednym z najbardziej zaawansowanych narzędzi, które wykorzystują tzw. głębokie uczenie się maszynowe czy duże modele językowe (Large Language Models). Wykorzystuje on bliżej niesprecyzowaną „ogromną bazę danych”, aby tworzyć treści. Potrafi się uczyć już na podstawie zaledwie kilku przykładów.

Istnieją obawy, że ChatGTP zostanie wykorzystany do zautomatyzowanego szerzenia dezinformacji, zarówno w zakresie tworzenia takich treści jak i ich weryfikowania. Niepokój wyraził nawet sam założyciel OpenAI, Sam Altman, w wywiadzie dla ABC News. Stwierdził też, że jest za uregulowaniem kwestii dotyczących rozwoju AI.

ChatGPT uruchomiono z dostępem publicznym w listopadzie 2022 roku. W kwietniu następnego roku opublikowano apel o natychmiastowe wstrzymanie rozwoju sztucznej inteligencji zaawansowanej bardziej niż GPT-4. Podpisało go ponad 26 tys. osób, w tym Elon Musk i współzałożyciel Apple Steve Wozniak.

Trzy prawa

O sztucznej inteligencji fantazjujemy od dawna, ale te fantazje nie zawsze były czysto rozrywkowe. Isaac Asimov, pisarz science-fiction już w latach 50. rozpoczął serię książek o duecie detektyw Bailey – r. Olivaw (r. to skrót od „robot”). W tych opowieściach o sztucznej inteligencji obok zagadek kryminalnych pojawiało się wiele pytań dotyczących jej codziennego funkcjonowania w społeczeństwie.

Asimov jest też autorem „Trzech praw robotyki” (wykorzystanych w jego powieściach), z których pierwsze brzmi: „Robot nie może skrzywdzić istoty ludzkiej lub – poprzez wstrzymanie się od działania – pozwolić, by stała jej się krzywda”. W publikacji pytano o to, jaką etyką powinna kierować się sztuczna inteligencja, a co za tym idzie: ludzie, którzy ją tworzą. Bo że powinniśmy używać tej technologii etycznie, było dla Asimova jasne.

I choć nad tym tematem teoretycznie zastanawiano się już 70 lat temu, nadal brakuje nam regulacji dotyczących użycia AI (aktualnie Unia Europejska pracuje nad pierwszym na świecie tego typu dokumentem tzw. „AI Act”), w szczególności w zakresie algorytmów mediów społecznościowych.

Wiele zależy od tego, jakie granice etyczne postawią sami właściciele platform – a w wyścigu o przykucie uwagi konsumentów łatwo je przesuwać. Destrukcyjne efekty braku tych granic, którymi mogą być np. automatyzacja dezinformacji, polaryzacja społeczna, kryzys mediów, autorytetów czy demokracji, to zagrożenia bardziej realne niż bunt maszyn.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter