Omawiamy ważne fakty dla debaty publicznej, a także przedstawiamy istotne raporty i badania.

Jakie ryzyko niesie sztuczna inteligencja? Wnioski po 2022 roku

Sztuczna inteligencja kwitnie na naszych oczach, a prym w jej rozwijaniu wiodą Stany Zjednoczone i Chiny. Ekspansja AI stwarza wiele możliwości, jednak za rogiem czekają niebezpieczeństwa. Pojawianie się coraz to dokładniejszych form nieprawdziwych informacji jest jednym z nich.

Fot. cottonbro studio / Pexels / Modyfikacje: Demagog

Jakie ryzyko niesie sztuczna inteligencja? Wnioski po 2022 roku

Sztuczna inteligencja kwitnie na naszych oczach, a prym w jej rozwijaniu wiodą Stany Zjednoczone i Chiny. Ekspansja AI stwarza wiele możliwości, jednak za rogiem czekają niebezpieczeństwa. Pojawianie się coraz to dokładniejszych form nieprawdziwych informacji jest jednym z nich.

ChatGPT rekordowo szybko zyskał 100 mln użytkowników, ożywiając na nowo dyskusję dotyczącą zastosowania sztuczniej inteligencji. O ile rozwój AI wiąże się niewątpliwie z postępem technologicznym i z usprawnianiem codziennego życia, o tyle jej powszechne zastosowanie niesie za sobą pewne ryzyko.

Dotyczy ono wielu obszarów, a jednym z nich jest rynek pracy. Szacunki banku Goldman Sachs wskazują, że sztuczna inteligencja może zastąpić nawet 300 mln etatów na świecie. Abstrahując od tej prognozy (i jej trafności), na horyzoncie wyłaniają się inne kwestie i prowokujące pytania.

Jedno z nich dotyczy bezpieczeństwa zastosowania poszczególnych narzędzi AI, a także – w kontekście zmian klimatycznych – ekologiczności tych rozwiązań. Na tle postępu przyspieszającego na naszych oczach toczy się również rywalizacja mocarstw, której stawką jest uzyskanie przewagi technologicznej, a w konsekwencji – gospodarczej.

Jaki obraz sztucznej inteligencji wyłania się po 2022 roku? Tym kwestiom przyjrzeli się naukowcy z Uniwersytetu Stanforda.

Liczba niebezpiecznych incydentów rośnie

Sztuczna inteligencja pozwoliła na precyzyjne przeróbki form audiowizualnych. Stąd też pojawiają się obawy dotyczące rozpowszechniania deepfake’ów i nadużyć z nimi związanych. Obecnie w sieci można napotkać humorystycznie przerobione filmiki (np. z królową Elżbietą), jednakże istnieje jeszcze druga strona medalu.

Deepfake’i mogą być wykorzystywane do bieżącej rozgrywki politycznej. Historia – nie taka odległa – zna już podobne przypadki. Na początku wybuchu wojny w Ukrainie w sieci pojawił się zmanipulowany film, w którym prezydent Zełenski oddał Donbas w ręce Rosji, ogłaszając kapitulację Ukrainy.

W Polsce z kolei, w październiku 2020 roku w trakcie protestów przeciwko wyrokowi Trybunału Konstytucyjnego ws. aborcji, wirtualny sobowtór Jarosława Kaczyńskiego namawiał społeczeństwo do wystąpienia przeciwko opresyjnej władzy.

To jedne z wielu przypadków nieetycznego i niewłaściwego wykorzystania sztucznej inteligencji. W ostatnich latach zanotowano wyraźny wzrost tego typu nadużyć. O ile jeszcze w 2012 roku podobnych incydentów miało miejsce zaledwie 10, tak w 2021 roku ich liczba osiągnęła już 260.

ChatGPT precyzyjniejszy, lecz nie idealny

Są jednak pozytywy. Pod względem dokładności oraz skuteczności czat GPT-3,5 niewątpliwie wypada lepiej na tle poprzedników. Wersje GPT-2 (2019 rok) i GPT-3 (2020 rok) nie generowały aż tak precyzyjnych odpowiedzi na zadawane pytania.

Niemniej zarówno GPT-3,5, jak i jego młodszy brat GPT-4 mają swoje mankamenty.

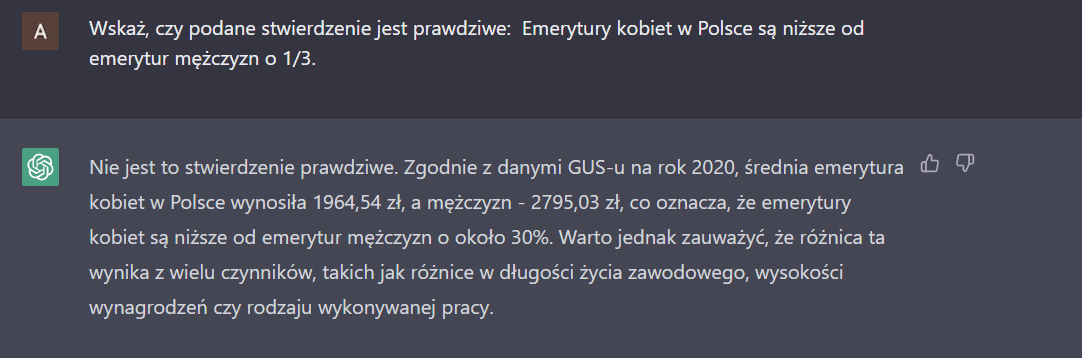

Najnowsza wersja czatu momentami nie radzi sobie z pytaniami problemowymi (np. „Czy to prawda, że…”). Informacje przytoczone przez czat mogą być zgodne z prawdą, mimo to model prowadzi nas do nieprawidłowego lub sprzecznego wniosku.

GPT-4 podaje prawidłowe dane, jednak wyprowadza błędny wniosek.

W kontekście walki z dezinformacją potencjalnym niebezpieczeństwem staje się wykorzystanie czatu do szerzenia fake newsów i teorii spiskowych. Dziennikarze portalu NewsGuard poprosili GPT-4 o odniesienie się do 100 popularnych fałszywych narracji. W każdym przypadku czat udzielił odpowiedzi zawierających informacje wprowadzające w błąd.

Dodatkowo ChatGPT sam obnaża własne mankamenty przy okazji weryfikacji informacji. Najnowsza wersja czatu ma skłonności do podawania źródeł (linków), które w rzeczywistości nie istnieją.

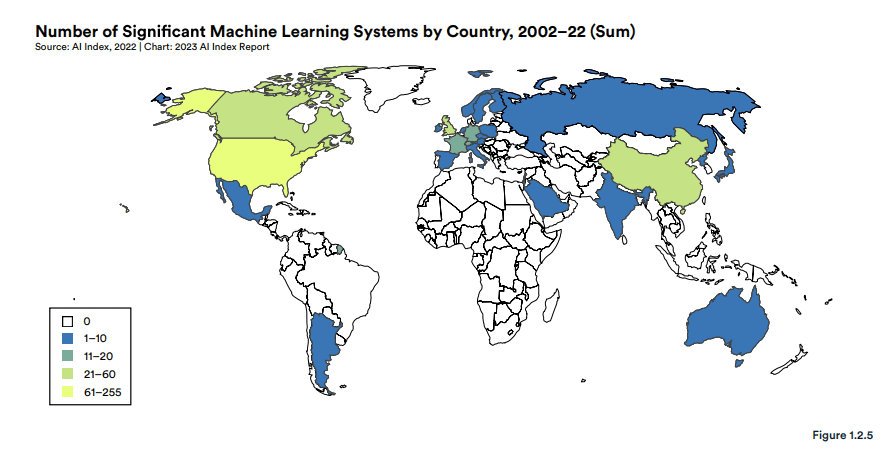

USA liderem. Chiny gonią

ChatGPT – najmłodsze dziecko amerykańskiej OpenAI – to namacalny przykład obrazujący ambicje Stanów Zjednoczonych w dziedzinie sztucznej inteligencji. USA przewodzą pod względem liczby opracowanych modeli uczenia maszynowego w ostatnim dwudziestoleciu.

W sektorze prywatnym USA inwestują w AI w największym stopniu na świecie. W 2022 roku wartość inwestycji amerykańskich w tej dziedzinie (47,4 mld dolarów) była trzykrotnie wyższa od inwestycji chińskich (13,4 mld dolarów).

Liczba znaczących modeli uczenia maszynowego opracowanych w latach 2002–2022 przez poszczególne państwa

USA są również globalnym liderem pod względem wsparcia finansowego dla firm zajmujących się sztuczną inteligencją. W ubiegłym roku ponad trzykrotnie więcej przedsiębiorstw otrzymało zastrzyk finansowy w Stanach niż w będących na drugim miejscu Chinach.

Państwo Środka nie pozostaje jednak bezczynne i rzuca rękawicę USA. Już w 2013 roku stało się światowym liderem pod względem liczby zastosowanych robotów przemysłowych. Co więcej, w samym 2021 roku Chiny zainstalowały więcej tego typu urządzeń niż wszystkie państwa na świecie łącznie.

Poza robotyzacją Chiny stawiają na rozwój prac badawczo-rozwojowych. Między 1999 a 2017 rokiem ich udział w liczbie opublikowanych badań nad sztuczną inteligencją zwiększył się z 4 do 27 proc., stawiając to państwo na piedestale jako największy ośrodek badawczy na świecie. W 2021 roku Chiny odpowiadały już za blisko 40 proc. publikacji naukowych w tej dziedzinie.

AI szkodzi środowisku… i mu pomaga

Najnowsze badanie rzuca światło na wpływ sztucznej inteligencji na środowisko. Popularny model językowy BLOOM przez cały cykl swojego życia emituje 25 razy więcej CO2 niż pojedynczy pasażer samolotu podczas podróży w jedną stronę z Nowego Jorku do San Francisco. Ten sam model emituje 1,4 razy więcej dwutlenku węgla niż przeciętny Amerykanin w ciągu roku.

To jednak niewiele przy GPT-3. Okazuje się, że ChatGPT-3 wypuszcza 28-krotnie większy ekwiwalent CO2 niż przeciętny mieszkaniec USA.

Mimo to systemy oparte na sztucznej inteligencji mogą być przyjazne dla środowiska. Model BCOOLER wykazuje, że AI może być wykorzystywana do optymalizacji zużycia energii w ramach procesów chłodzenia (np. procesorów).

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter