Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

Oślepieni deepfake’ami. Jak sprawdzić, czy to AI stworzyło obraz?

Praktyczne wskazówki i 5 przydatnych narzędzi do weryfikacji.

Obrazy wygenerowane przez sztuczną inteligencję w programie Midjourney

Oślepieni deepfake’ami. Jak sprawdzić, czy to AI stworzyło obraz?

Praktyczne wskazówki i 5 przydatnych narzędzi do weryfikacji.

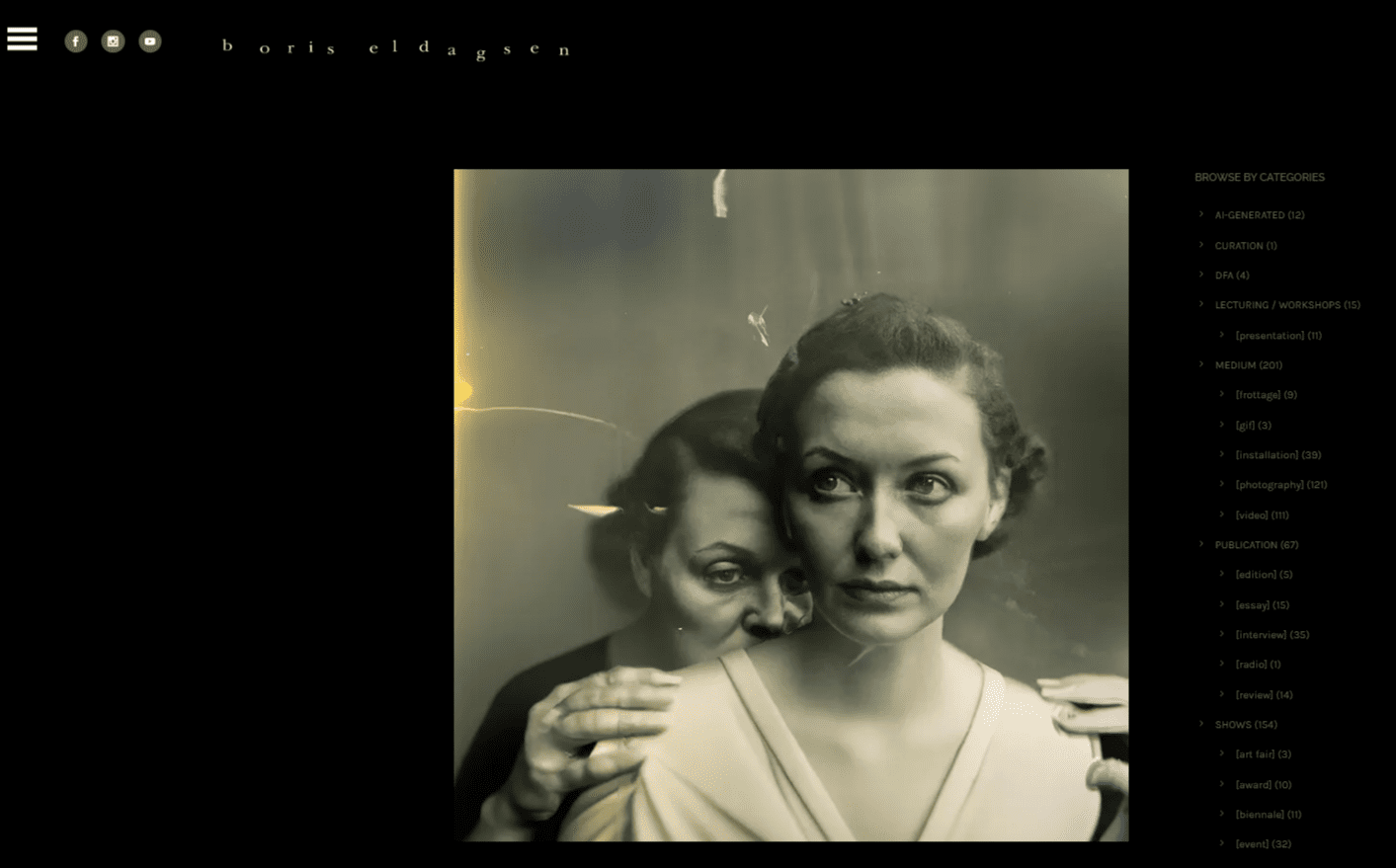

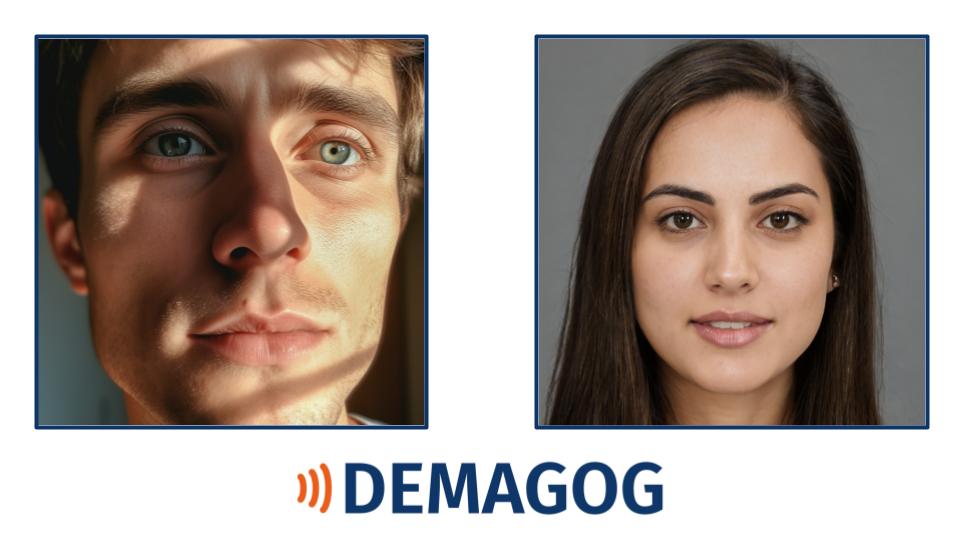

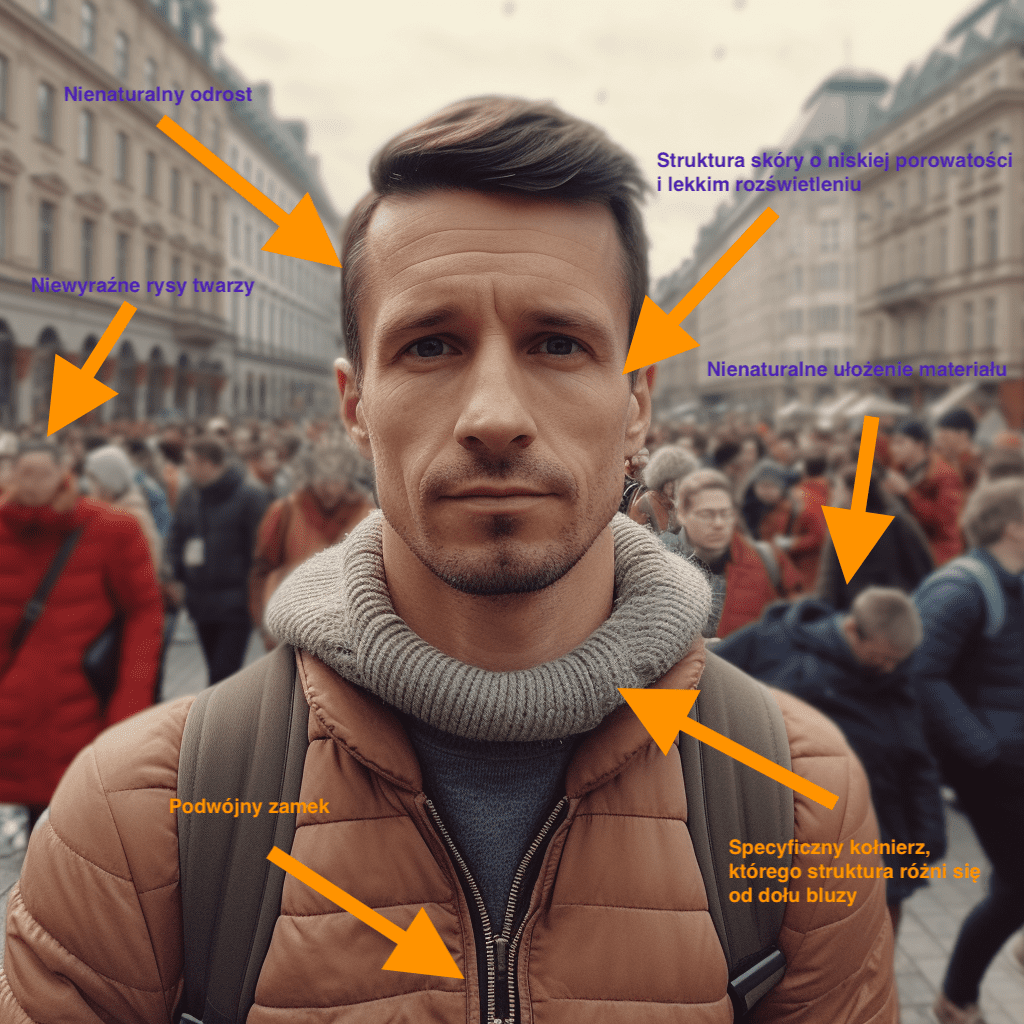

Zerknij szybko na zdjęcia poniżej i zastanów się: która osoba z dwóch przedstawionych jest prawdziwa? Ludzkie oko jest niemal stworzone do rozpoznawania twarzy. W kontekście deepfake’ów to jednocześnie dar, ale i przekleństwo.

Źródło: www.demagog.org.pl

Oczywiście, żadna z tych postaci nie jest prawdziwa. Po lewej znajduje się mężczyzna wygenerowany przez Midjourney, a po prawej – kobieta stworzona przy użyciu narzędzia na stronie ThisPersonDoesNotExist.com. Być może niektórzy zorientują się od razu, a inni będą zastanawiać się nieco dłużej.

Niemniej jednak wnioski z badania opublikowanego na łamach iScience w 2021 roku były niepokojące. Ogólnie „ludzie nie potrafią wykryć deepfake’ów, ale myślą, że potrafią” – wskazywali autorzy. W 2022 roku w czasopiśmie naukowym „PNAS” pojawiła się praca, której konkluzje były zbieżne. W rozpoznawaniu syntetycznych twarzy jesteśmy na ogół niewiele lepsi od przypadku, a edukacja w zakresie ich identyfikacji przynosi tylko minimalną poprawę pod względem szybkości oceniania. Jesteśmy jednak zdania, że na pewno warto podjąć walkę i poszerzać swoje umiejętności weryfikacji. Tylko jak to robić i na co trzeba uważać?

Tekst autorstwa Aleksego Szymkiewicza i Adama Majchrzaka – analityków Stowarzyszenia Demagog – to już trzeci i ostatni z serii artykułów nt. weryfikacji fałszywych obrazów generowanych przez AI. W poprzednim tekście przeczytasz o tym, jak wiarygodne obrazy potrafi tworzyć współczesna sztuczna inteligencja, a w pierwszym – o tym, jak ewoluowały deepfake’i na przestrzeni lat. Natomiast z tego tekstu dowiesz się, jak można bronić się przed zjawiskiem deepfake’ów przy uwzględnieniu aktualnych zagrożeń.

Blind of deepfakes? Czy jesteśmy ślepi na deepfake’i i kiedy tak się dzieje?

Jak nazwać czasową lub trwałą niezdolność do rozpoznawania realistycznie wyglądających obrazów wygenerowanych przez AI? W literaturze naukowej brakuje takich określeń. Może: Blind of deepfakes? Deepfakes Blidness? – czyli po prostu deepfake’owa ślepota. Niezależnie od nazwy, którą przyjmiemy, takie zjawisko z pewnością istnieje i każdy z nas może paść jego ofiarą. Niektóre jego przejawy można zaobserwować na przykładzie konkretnych fake newsów, które obiegły internet.

Koń gigant i stare rodzinne zdjęcia – alternatywne historie tworzone przez AI

Oto Sampson – największy koń w dziejach ludzkości rasy Shire. Miał mierzyć 2,19 cm i ważyć 1 524 kg. Ta informacja obiegła media społecznościowe w kwietniu 2023 roku. Z TikToka szybko zaczęła migrować na inne platformy, budząc zainteresowanie.

Myśle czy po łosiach nie zająć się …. No. pic.twitter.com/b8WgTm8JHI

— Zaklinacz Łosiów (@ZaklinaczLosiow) April 5, 2023

I choć faktycznie Sampson był największym koniem w dziejach ludzkości, to nie zachowały się jego zdjęcia. Powyższa grafika nie przedstawia historycznego Sampsona, ale – jak dowodzą Snopes oraz Konkret24 – została stworzona przez generator wspierany sztuczną inteligencją.

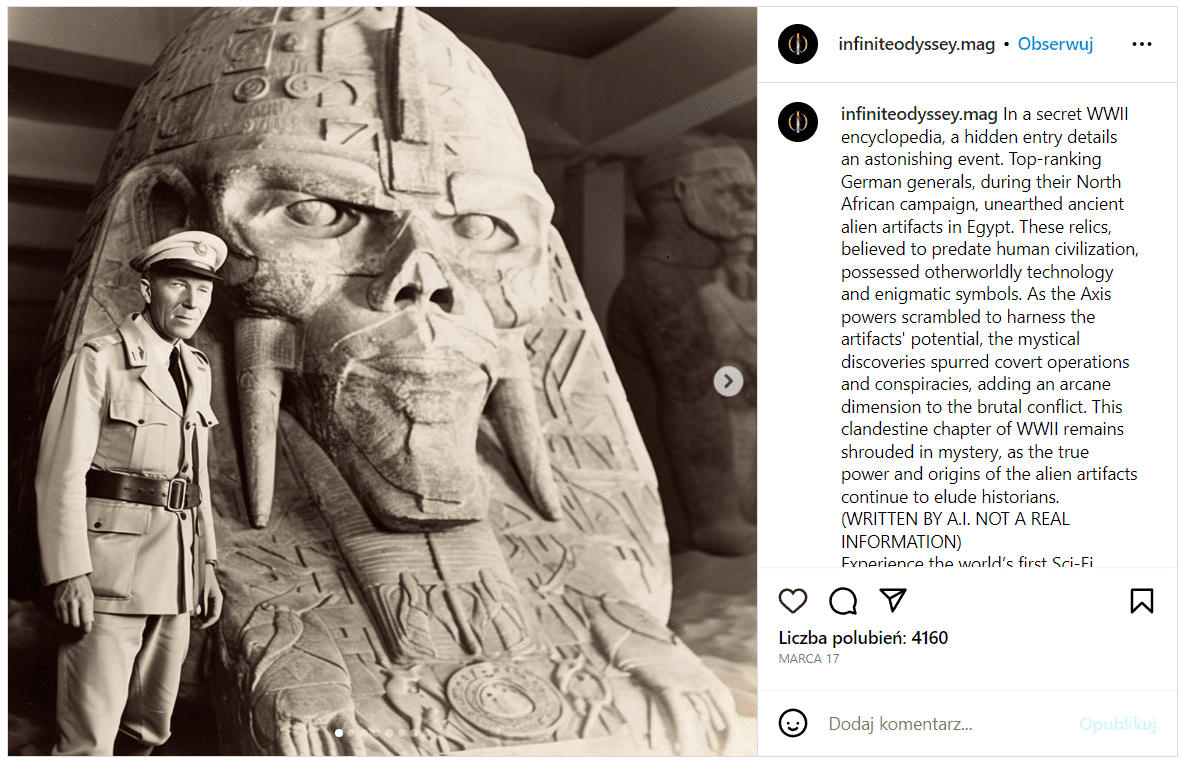

Można pomyśleć, że generowanie historycznych zdjęć to tylko czcza zabawa celująca w clickbaitowe tytuły. Nic bardziej mylnego. Boris Eldagsen, niemiecki fotograf, z pomocą sztucznej inteligencji również wygenerował nieistniejące zdjęcie historyczne (poniżej).

Później Boris Eldagsen wysłał je na konkurs Sony World Photography Awards. Zdjęcie zatytułował „Pseudomnesia”. Grafika Eldagsena zwyciężyła w kategorii „Creative”. Fotograf celowo zgłosił obraz do konkursu, a następnie zrzekł się nagrody.

Naziści i egipskie sekrety – jak fałszywe obrazy mogą zmienić historię?

„Tajny rozdział drugiej wojny światowej. Państwa Osi wyruszają na kampanię do Afryki Północnej. Przypadkiem podczas manewrów odkrywają starożytne artefakty skrywane w ziemi przez setki lat, jeśli nie tysiąclecia. Niedawne dokumenty rzucają nowe światło na egipskie budowle z czasów faraonów” – tak właśnie mógłby brzmieć opis poniższej grafiki, a być może nawet wstęp do książki lub paradokumentu.

Podobnie jak poprzednie obrazy, tak i ten został stworzony dzięki współpracy człowieka i algorytmów sztucznej inteligencji. Grafikę opublikowało konto infiniteodyssey.mag. Autor przed tym przestrzegał, ale co gdyby tak się nie stało?

Jak weryfikować, czy obrazy są generowane przez sztuczną inteligencję? Techniki i narzędzia

Jak przystosować się do zagrożeń, które stwarza AI? Trzeba nauczyć się je rozpoznawać. „Ta technologia nie pojawiła się znikąd” – twierdzi Wojtek Kardyś, specjalista od komunikacji internetowej i digital marketingu. „Pamiętajmy, że już w latach 90. Deep Blue (komputer) pokonał arcymistrza szachowego (Kasparova) w szachach. W ostatnich latach naszą uwagę skupiały inne tematy (kryptowaluty, NFT, metaversum)” – wskazywał w odpowiedzi, którą nam przesłał.

„Co do samych generatorów grafik, skok jest absolutnie błyskawiczny i to robi wrażenie, jednak podchodzę do tego tematu z bardzo chłodną głową, nie wieszczę zagłady ani tego, że AI zabierze nam pracę i zniewoli. Trzeba się nauczyć zaadaptować do nowych warunków – jak zawsze, a nic nikomu się nie stanie” – uzupełnia Wojtek Kardyś. W takim razie jak rozpoznawać takie obrazy? Mamy dla was kilka praktycznych porad i narzędzi.

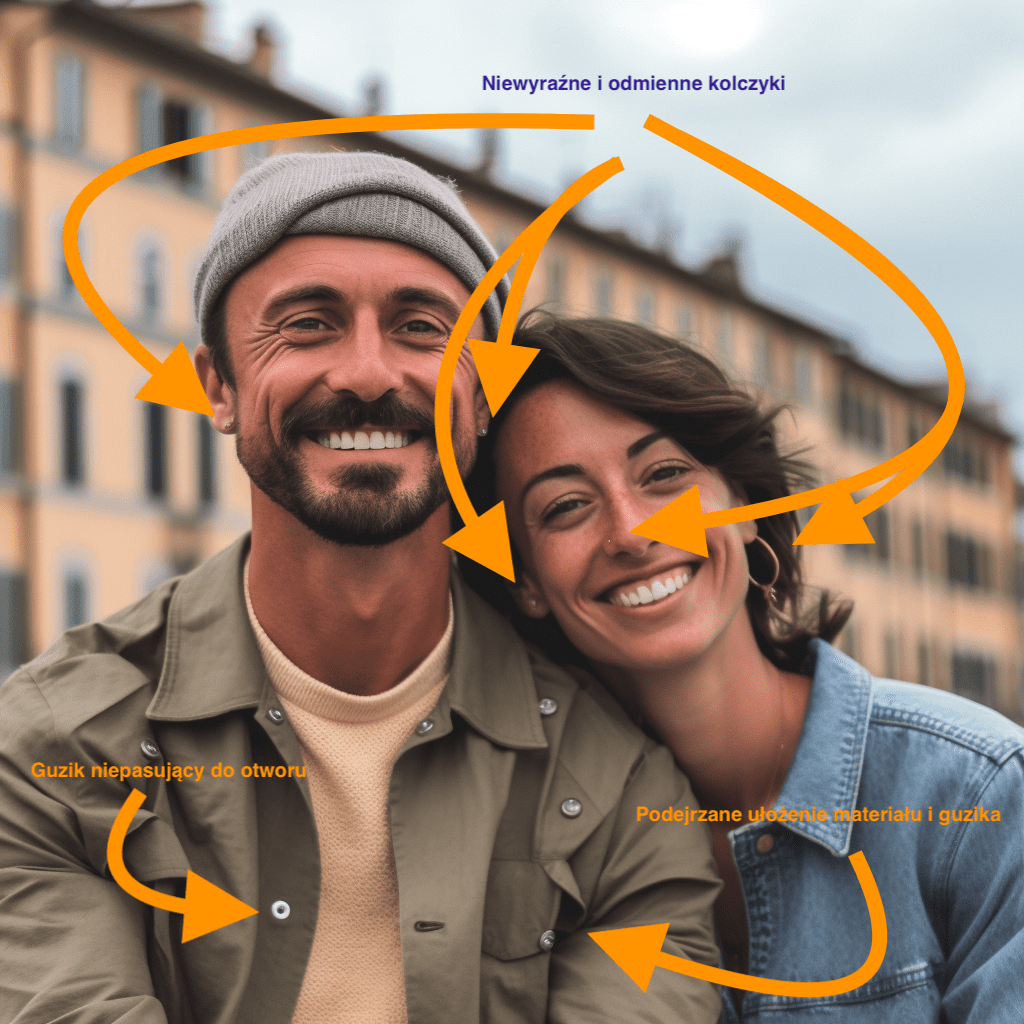

1. Zawsze patrz na wszystkie szczegóły obrazu. Niemal każdy błąd ma znaczenie

Grafiki generowane przez algorytmy sztucznej inteligencji na pierwszy rzut oka wydają się nieodróżnialne od prawdziwych zdjęć. Zazwyczaj gubią je szczegóły – charakterystyczna poświata (efekt „glow”), dziwne ułożenie sylwetki, kształt uszu, różny rozmiar źrenic, struktura skóry, albo liczba palców lub ich kształt. Trzeba jednak uważać, ponieważ jeżeli ktoś będzie chciał zamaskować takie niedociągnięcia, to teoretycznie mógłby wygenerować inny obraz (z mniej zauważalnymi błędami) lub poprawić go np. w photoshopie.

Źródło: www.demagog.org.pl

Warto również zwrócić uwagę na detale ubrania, takie jak kaptur, zamek i kołnierzyk. Dla AI zgubne bywają też ozdoby – kolczyki czy łańcuszki. Przy grafikach przedstawiających tłum często widoczne są defekty na twarzach, kończynach i dłoniach. Pamiętaj również o napisach – generatory wciąż słabo radzą sobie z generowaniem tekstu, zastępując go „szlaczkami” albo znakami zbliżonymi do liter.

Źródło: www.demagog.org.pl

W przypadku niektórych grafik zauważenie tych drobnych detali bywa niezwykle trudne. W wielu sytuacjach na obrazy patrzymy zaledwie kilka sekund i nie przyglądamy się im dokładnie – w erze sztucznej inteligencji może okazać się to poważnym błędem. W dodatku generowanie różnych wariacji obrazów, kadrowanie czy nanoszenie efektów podczas edycji grafik pomaga zatuszować defekty, co znacznie komplikuje weryfikację obrazów.

2. Sprawdź, czy zdjęcie lub widoczne na nim obiekty istnieją – to proste!

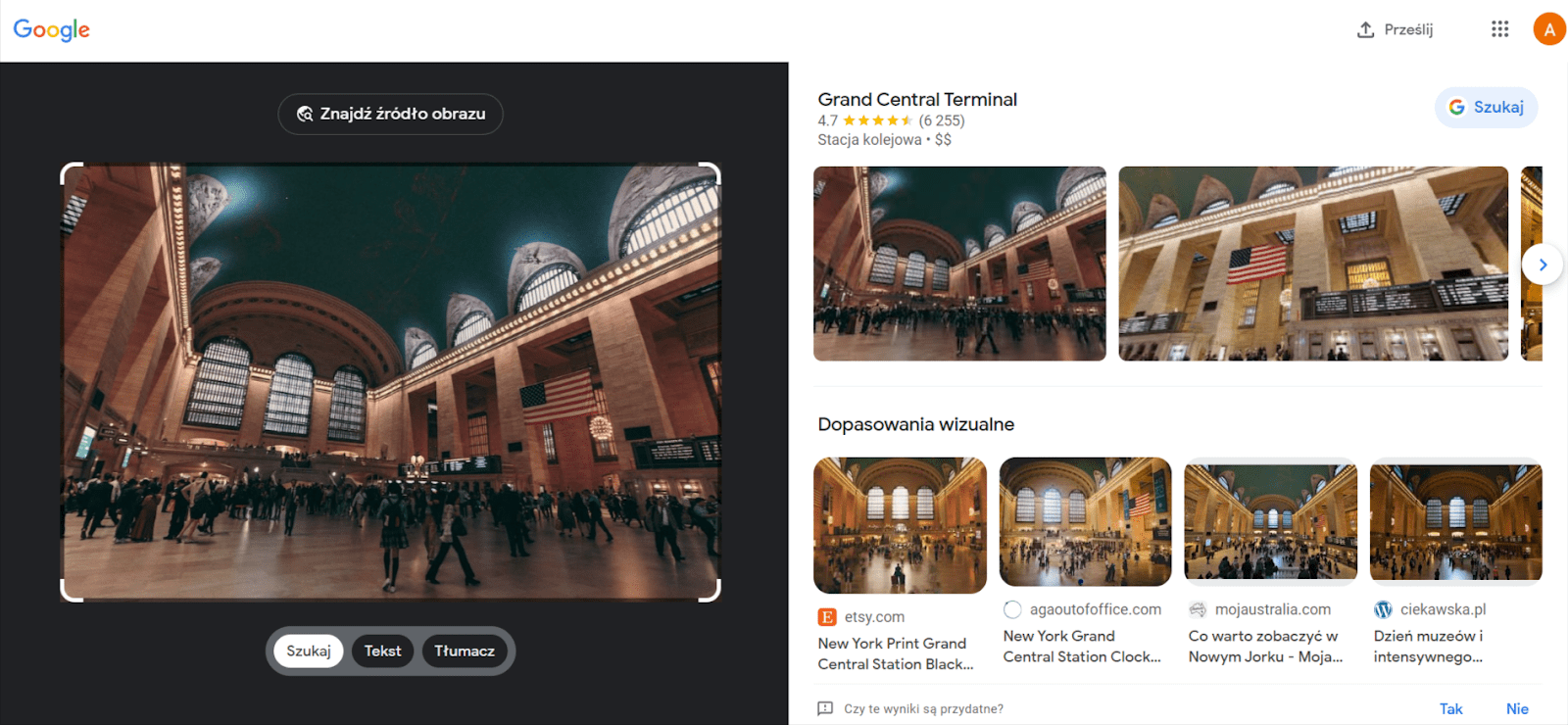

Jeżeli po dokładnym przeglądzie szczegółów zdjęcie wydaje się nam prawdziwe, to warto zrobić jeszcze jedną rzecz – sprawdzić, czy osoby lub obiekty na nim widoczne w ogóle istnieją. Jak to zrobić? Z pomocą przychodzi nam wiele narzędzi, w tym m.in. Obiektyw Google, który podpowiada, jakie elementy są widoczne na fotografii, lub wskaże nam inne miejsca publikacji tego samego zdjęcia.

Swoje przypuszczenia warto potwierdzić też w wyszukiwarkach obrazów, takich jak Google Grafika, TinEye lub Yandex Images. To prosta technika, która nosi nazwę wstecznego wyszukiwania obrazem (więcej na jej temat znajdziesz w innym artykule).

Jeżeli wydaje nam się, że na zdjęciu widzimy fałszywą osobę, to można skorzystać z narzędzia, które pozwala wyszukiwać te same lub podobne twarze w sieci – mowa tu o stronie PimEyes. W ograniczonym zakresie można używać jej w wersji bezpłatnej. To dobra metoda uzupełniająca – jeżeli twarz została wygenerowana od podstaw, to najpewniej nie pojawi się ona w zbyt wielu podobnych wynikach lub nie będzie obecna tam wcale.

3. Użyj wybranych narzędzi dedykowanych do rozpoznawania deepfake’ów

Jeżeli wszelkie inne sposoby zawiodły lub chcemy poradzić sobie z obrazem w szybszy sposób, to pozostaje nam użycie narzędzi bardziej zaawansowanych. Obecnie na rynku nie ma ich zbyt wiele, ale przyjrzyjmy się kilku wybranym pozycjom – warto mieć na względzie, że one także mają swoje ograniczenia, i nie powinno się pokładać wiary w ich 100-proc. nieomylność.

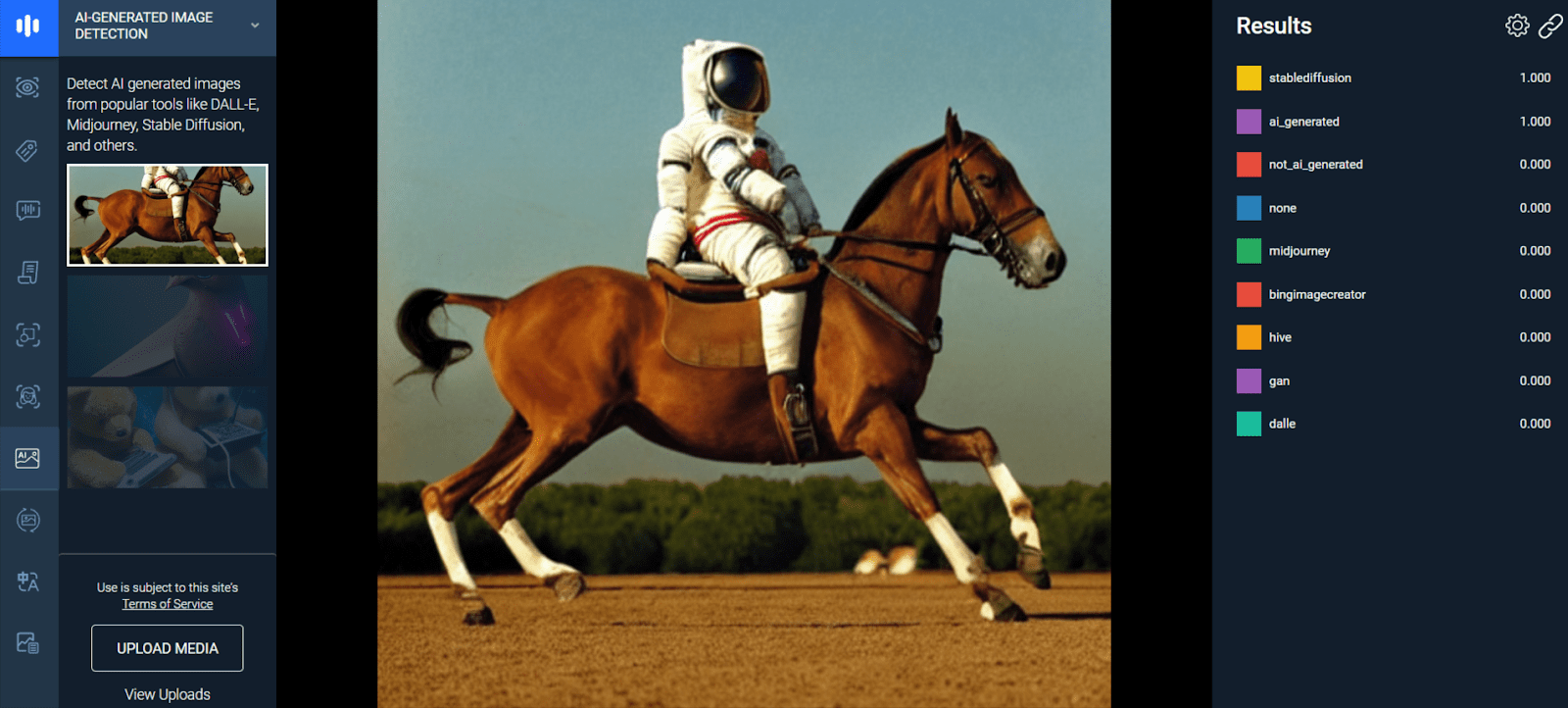

Najciekawszą opcją w kontekście obrazów generowanych przez Midjourney, Dall-E i Stable Diffusion wydaje się narzędzie od Thehive.ai – o nazwie AI-generated Image Detection. Pozwala ono ocenić, czy obraz został stworzony w generatorze grafik. Jeżeli grafika została wygenerowana w jednym z ww. generatorów, to narzędzie przedstawi nam prawdopodobny udział ingerencji AI (w zakresie od 0.000 do 1.000), nawet jeżeli wprowadzimy pewne modyfikacje.

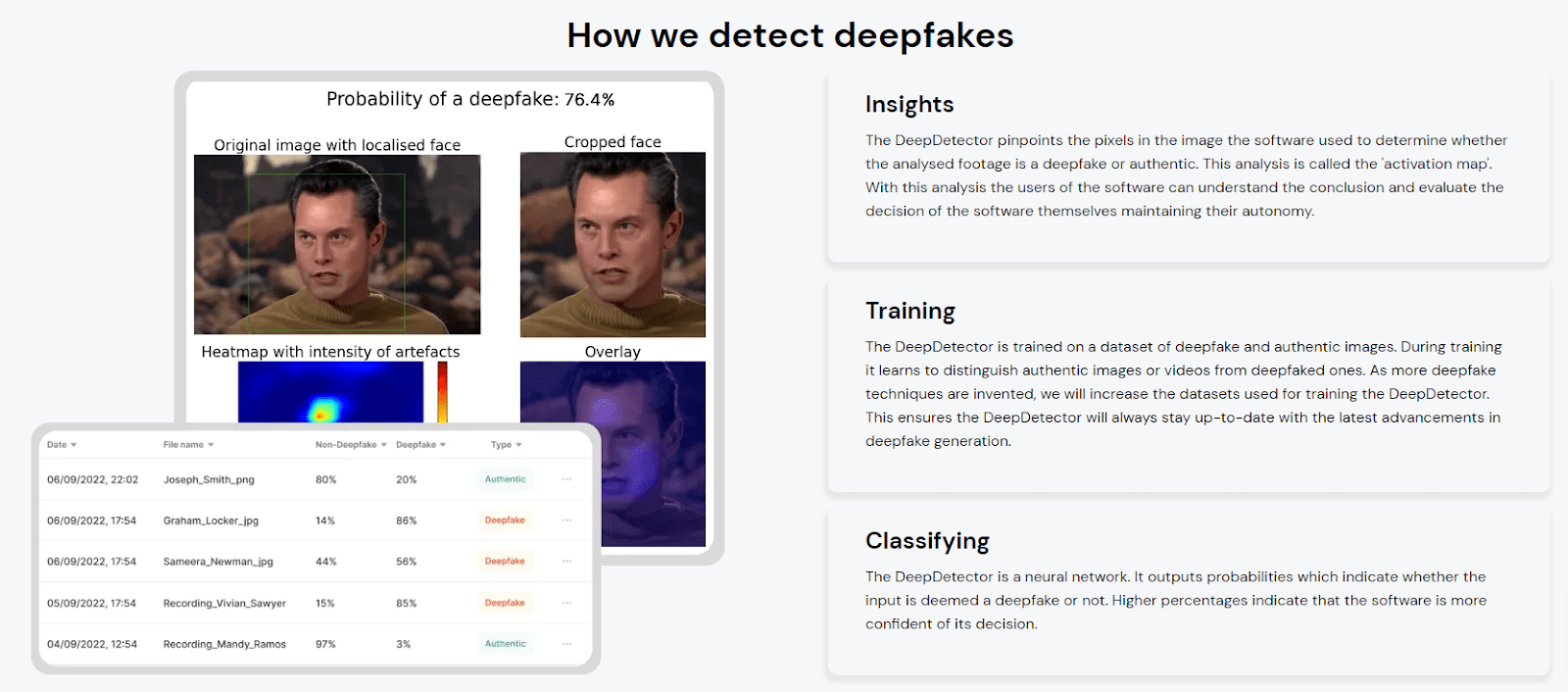

Interesującą propozycją jest też rozwiązanie od start-up’u DuckDuckGoose. Narzędzie DeepDetector pozwala na weryfikację materiałów opracowanych dzięki sztucznej inteligencji. Potrafi ono rozpoznać podmienione i stworzone twarze oraz ruchy, które są efektem naśladowania. Największą wadą z perspektywy przeciętnego użytkownika jest jednak brak darmowego i powszechnego dostępu.

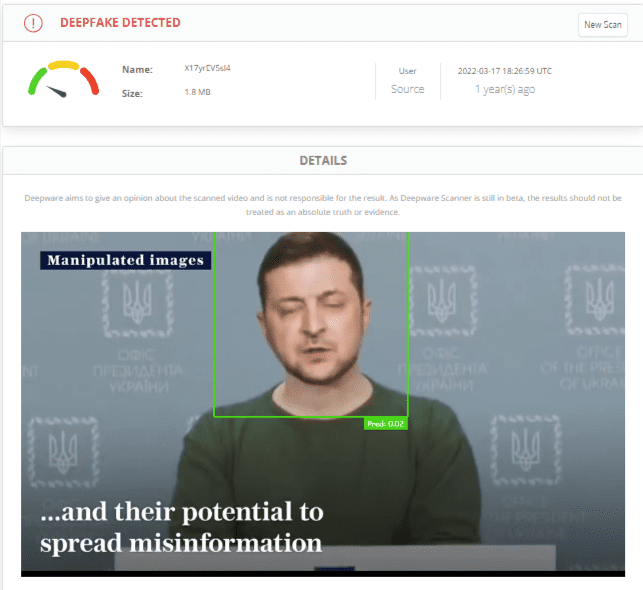

Z kolei strona Deepware oferuje możliwość darmowej oceny materiałów wideo pod kątem ingerencji sztucznej inteligencji. Największa wada? Działa tylko w przypadku filmów (nie pomoże w ogóle w przypadku wygenerowanych obrazów statycznych), a w dodatku tylko takich, które pojawiły się w wybranych serwisach społecznościowych.

Każda z przedstawionych technik i każde narzędzie ma swoje zalety, ale i wady, dlatego – jeżeli mamy taką możliwość – warto zastosować je wszystkie naraz. Najlepszym rozwiązaniem jest jednak zawsze nasz krytyczny umysł i zdrowa doza sceptycyzmu wobec różnych doniesień, które docierają do nas z internetu.

Jak czytelnicy Demagoga poradzili sobie ze specjalnym zadaniem?

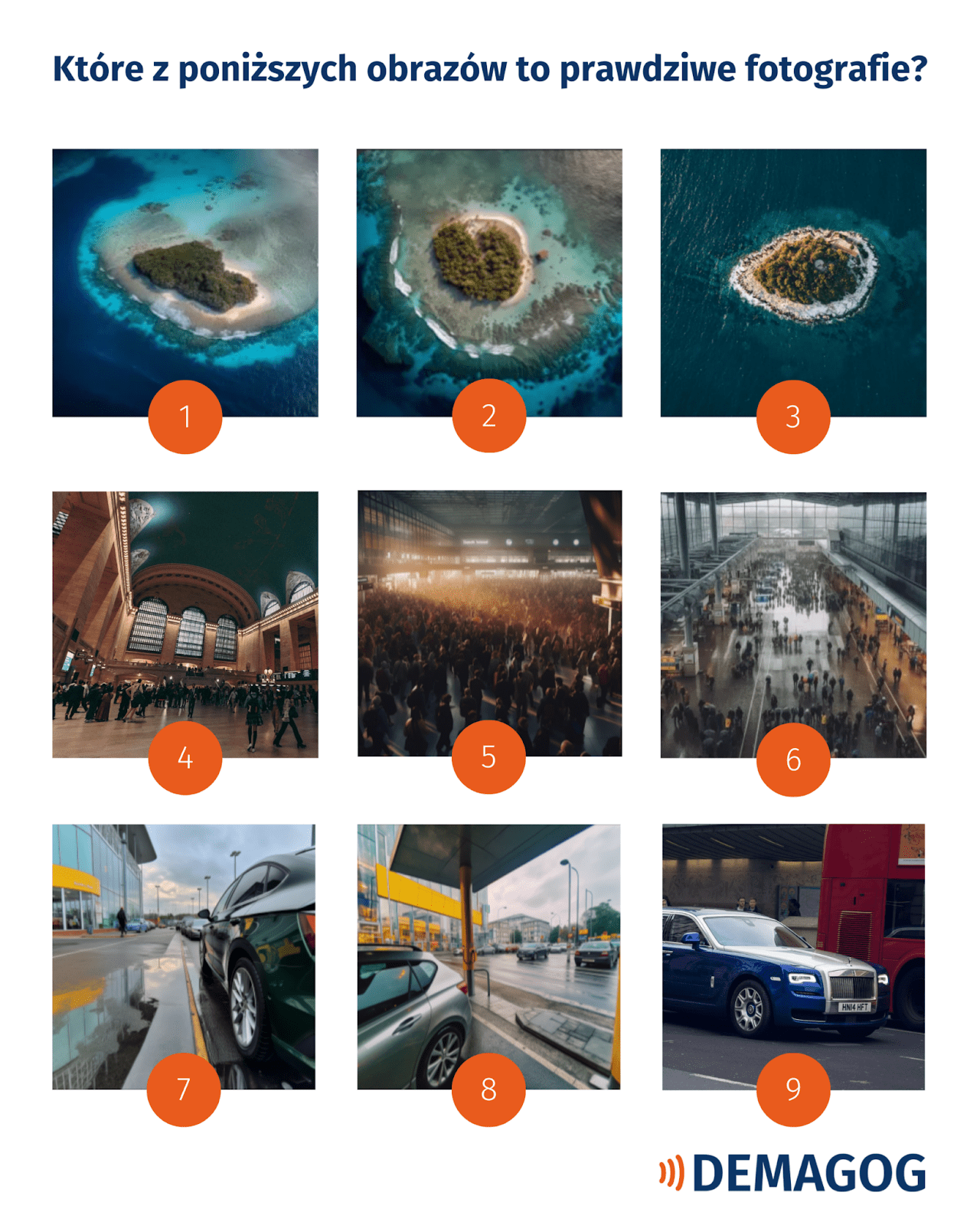

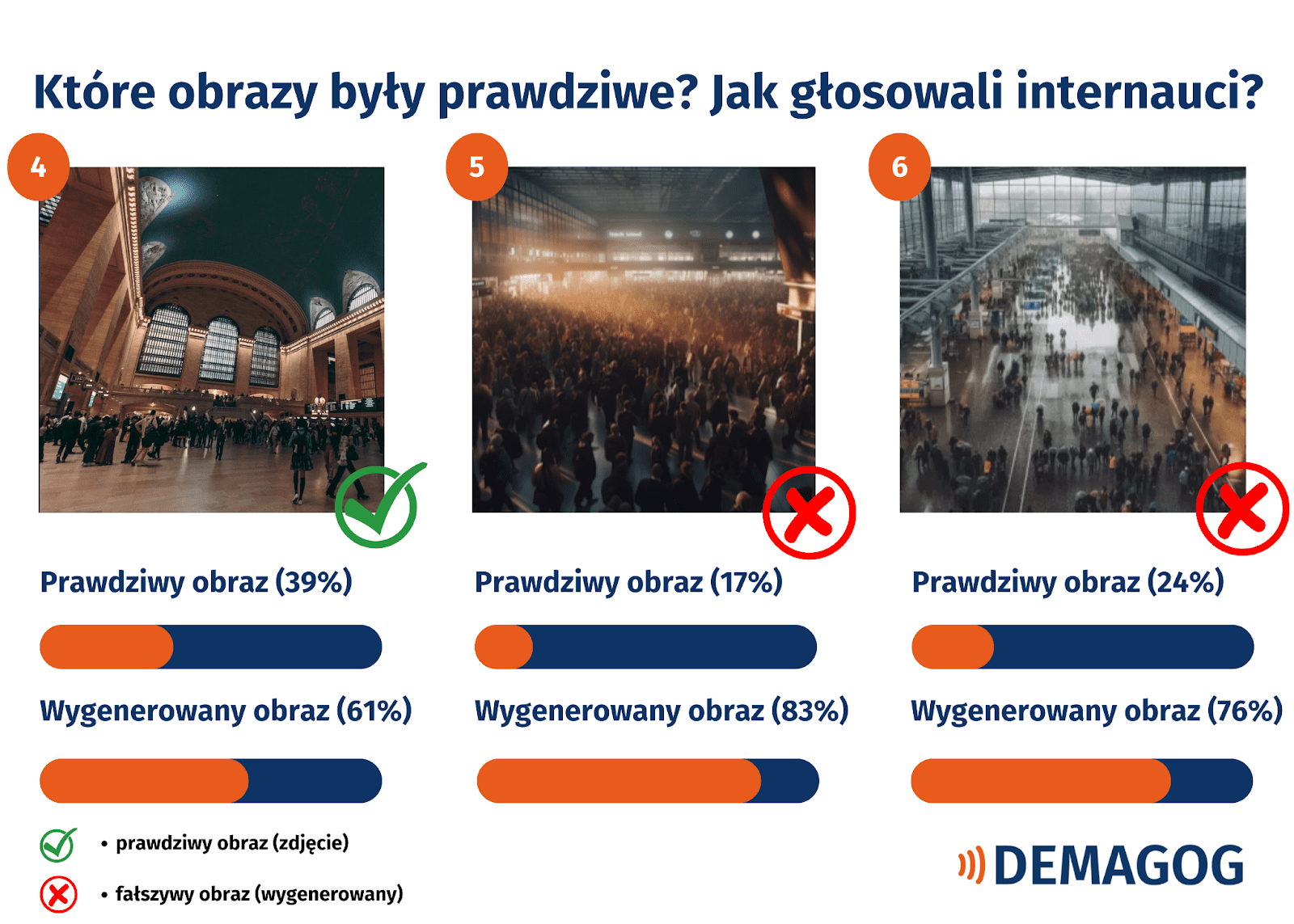

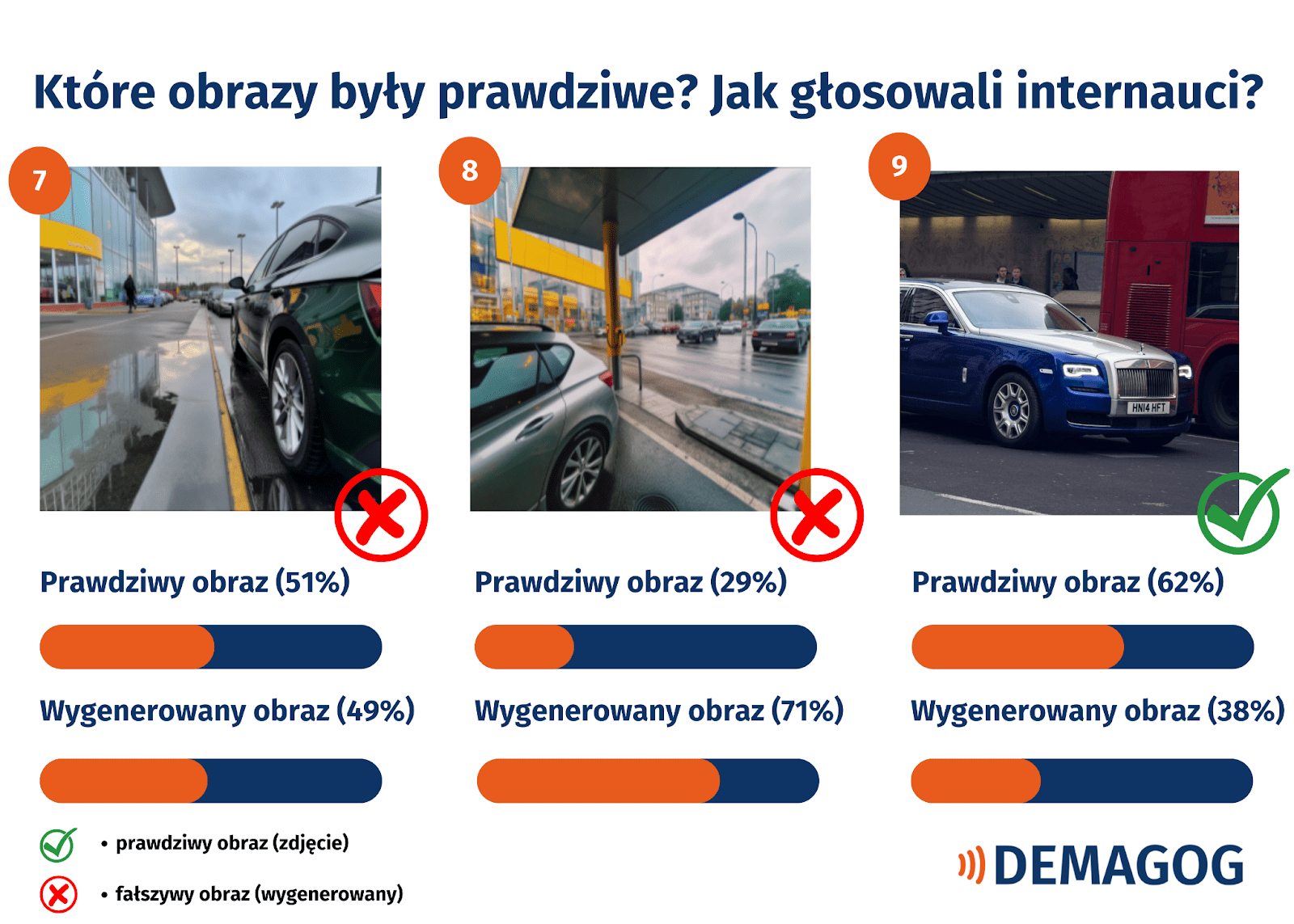

Obrazy generowane z użyciem sztucznej inteligencji to nie tylko deepfake’i z określonymi twarzami, ale i takie, które przedstawiają otoczenie (np. fikcyjne krajobrazy lub nieistniejące zdarzenia o charakterze masowym). Najpewniej z takimi będziemy mieli do czynienia coraz częściej. W poprzednim tekście z tej serii przedstawiliśmy zagadkę, w której pojawiły się wymieszane zdjęcia i obrazy wygenerowane przy użyciu AI – w sumie 9 zdjęć i grafik. Tylko trzy były prawdziwe.

Jakie były wyniki? Czy potrafimy rozpoznawać obrazy generowane przez AI, które giną w natłoku innych fotografii w sieci? Zerknijcie na zagadkę po raz ostatni, a poniżej poznacie odpowiedzi, które otrzymaliśmy w ankietach w relacjach na Instagramie.

Źródło: www.demagog.org.pl

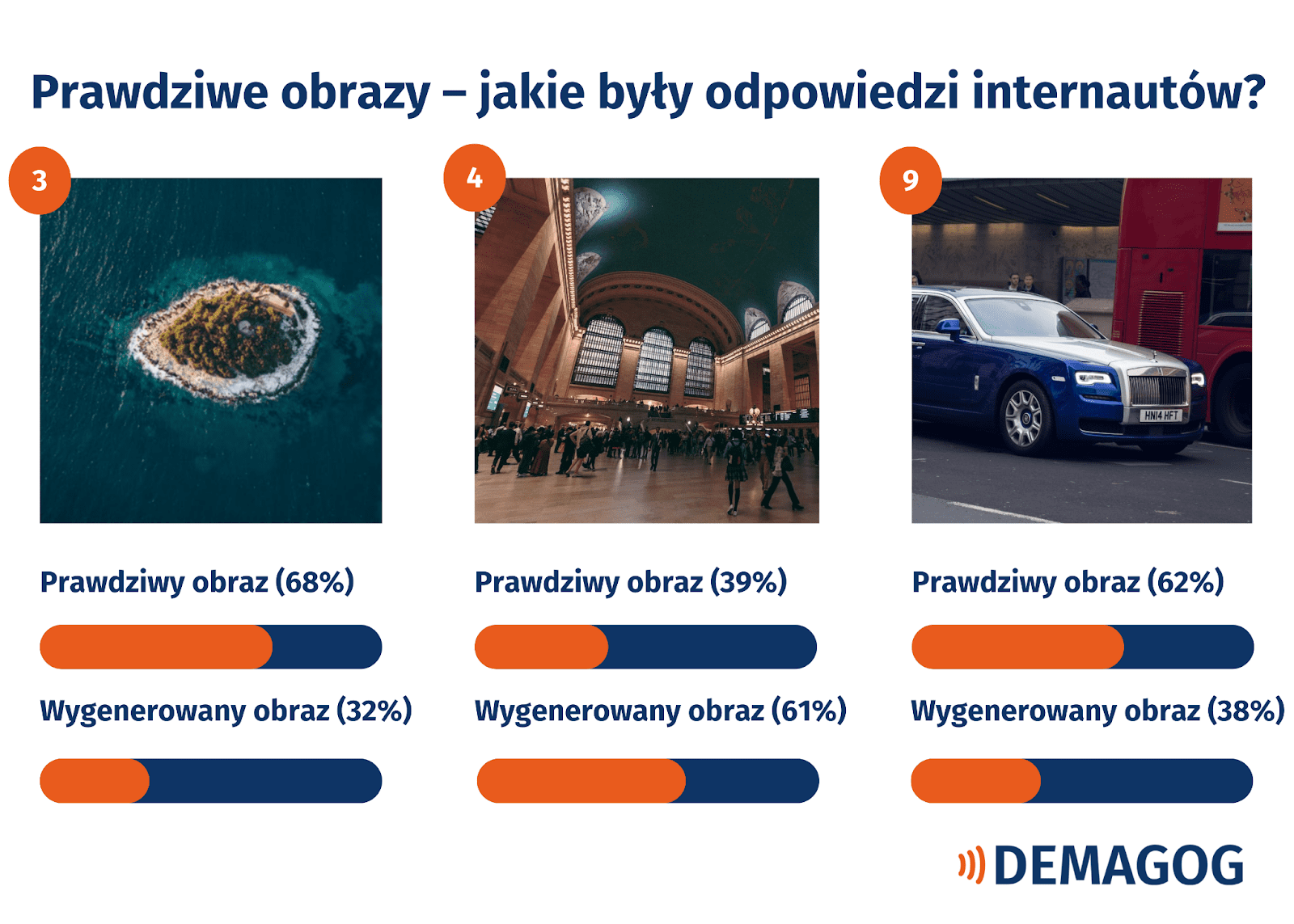

Prawdziwe obrazy to numery: 3, 4 i 9 (widoczne na zestawieniu poniżej). Pozostałe powstały w Midjourney. Ich rozpoznanie okazało się pewnym wyzwaniem. 68 proc. osób (z 230) prawidłowo wskazało prawdziwą wyspę i 62 proc. (z 207) zidentyfikowało istniejący samochód. Natomiast w przypadku obrazów z dworców tylko 39 proc. osób (z 228) wskazało zdjęcie tego prawdziwego.

Źródło: www.demagog.org.pl

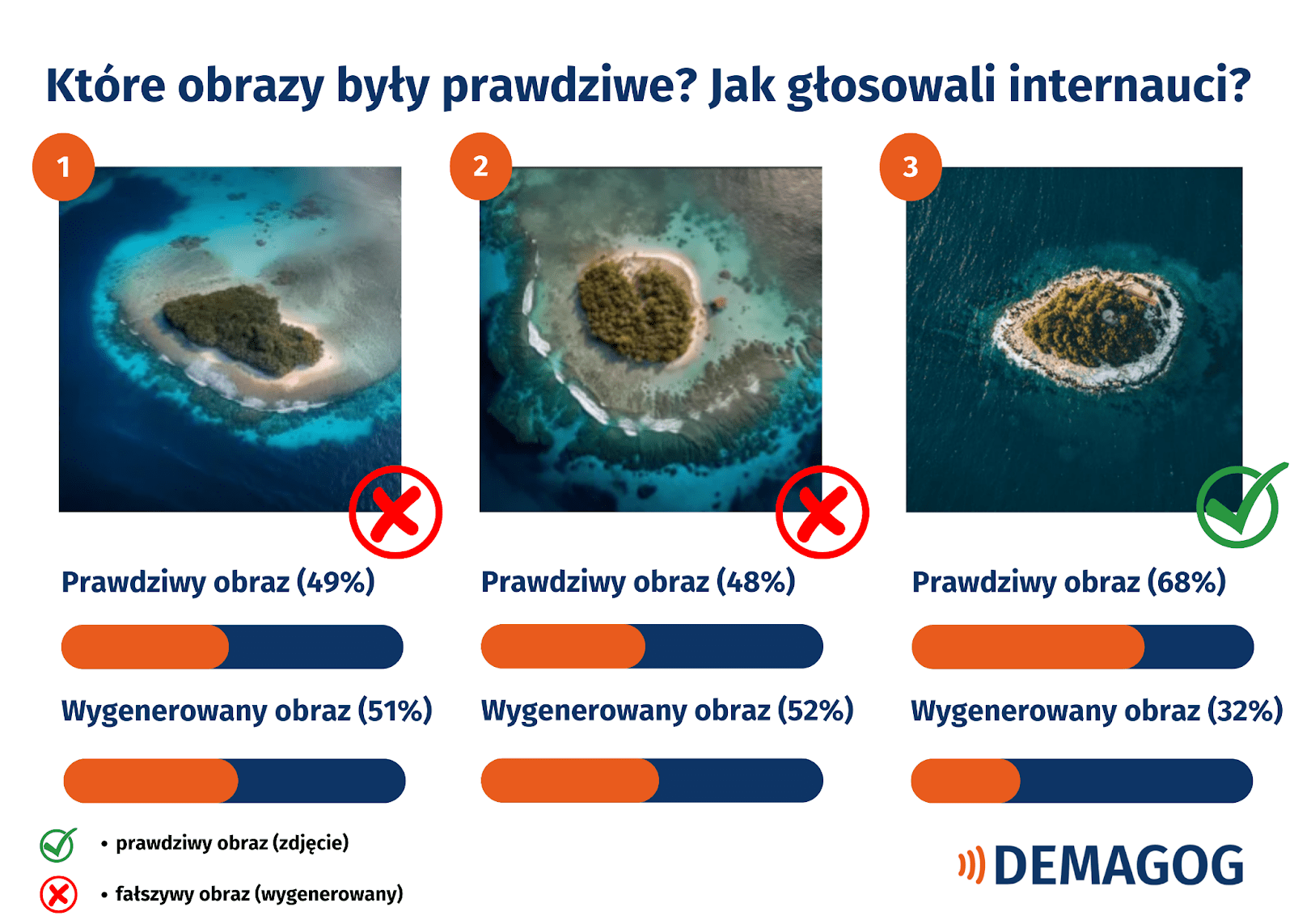

Jakie były odpowiedzi w przypadku pozostałych obrazów z zadania?

W przypadku obrazów krajobrazowych z wyspami, wygenerowanych przy użyciu AI, użytkownicy byli dość podzieleni, a ich odpowiedzi mogły być przypadkowe. 49 proc. (z 244) wskazało, że obraz nr 1 wydaje się im prawdziwy, kiedy tak naprawdę był stworzony przez AI. Z kolei przy nr 2: 48 proc. (z 226). Na pierwszy rzut oka rzeczywiście trudno jest wskazać, która wyspa istnieje, jednak warto zwrócić uwagę na podejrzaną „gładkość” wygenerowanych obrazów.

Źródło: www.demagog.org.pl

Obrazy z dworca ogólnie okazały się zdecydowanie łatwiejsze do rozpoznania jako te wygenerowane przez AI przez większość głosujących. Użytkownicy w 83 proc. (z 231) prawidłowo wskazali fałszywy obraz nr 5 i w 76 proc. (z 229) obraz nr 6. Jak jednak wspomniano wyżej – nieufność odbiła się również na prawdziwym dworcu – to Grand Central Terminal, który zdaniem 61 proc. internautów (z 228) był wygenerowany.

Źródło: www.demagog.org.pl

Z kolei odpowiedzi, które dotyczyły obrazów samochodów, były bardziej zróżnicowane w zależności od zdjęcia. Jedyne prawdziwe zdjęcie przedstawiało samochód marki Rolls Royce, natomiast pozostałe to fikcyjne auta z asymetrycznymi felgami, co zdradza ich nienaturalność. Jedno z tych zdjęć (nr 7) zostało ocenione jako fałszywe w 49 proc. przypadków (z 216). Łatwiej było natomiast w przypadku zdjęcia nr 8: 71 proc. (z 214) oceniło prawidłowo, że obraz jest stworzony przez AI.

Źródło: www.demagog.org.pl

Na podstawie powyższych wyników trudno stwierdzić, kto i czy w ogóle ma zdolność do rozpoznawania fałszywych obrazów. Nie da się też określić, czy jest to trwała zdolność, która pozwala zidentyfikować takie obrazy w absolutnie każdej sytuacji, czy może jedynie przypadek. W każdym razie pojawia się ważne pytanie: Kiedy jesteśmy najbardziej zagrożeni? Najpewniej wtedy, gdy „zasypia” nasza czujność — czyli, gdy dopada nas… deepfake’owa ślepota.

Podsumowanie: przyszłość – pod pewnymi warunkami – nie musi być zła

W naszej serii mogliście przeczytać o tym, jak ewoluowały deepfake’i, jakie możliwości stwarzają obecnie generatory grafik, i wreszcie, jak można weryfikować obrazy stworzone przy użyciu sztucznej inteligencji. Na koniec warto zastanowić się, co pozytywnego przyniesie nam AI i pod jakimi warunkami? Jakie zagrożenia czekają na nas w związku z szybką ewolucją narzędzi, takich jak Midjourney oraz DALL-E?

O opinię dotyczącą przyszłości generatorów i technologii bazujących na sztucznej inteligencjię także zapytaliśmy Wojciecha Kardysia.

„Przede wszystkim automatyzacja i przyśpieszenie procesów twórczych. Teraz jeden grafik, który nauczy się korzystać z AI, będzie umiał przyśpieszyć swoją pracę, ergo będziemy bardziej efektywni, co może przybliżyć nas do tego 4-dniowego tygodnia pracy (w co głęboko wierzę, że jest możliwe). Oczywiście, możemy obawiać się fake newsów czy deepfake’ów — ale tak jest z każdą nową technologią. Dynamit nie po to wynaleziono, by prowadzić wojny. Dlatego im szybciej pojawią się regulacje, tym lepiej dla każdego z nas”.

Wojtek Kardyś, specjalista od komunikacji internetowej

Manipulacja obrazem i materiałami wideo dzięki narzędziom wspieranym przez AI stała się prostsza niż kiedykolwiek. O to, czy fałszywe zdjęcia i deepfake’i mogą być zagrożeniem pod kątem dezinformacji politycznej, zapytaliśmy ponownie Wojtka Kardysia:

„Oczywiście, że tak. Polityka już dawno przekroczyła wszelkie granice zdrowego rozsądku. Pytanie — jak będziemy to karać. Bo jestem pewny, że będziemy w stanie wykryć takie próby — kary powinny być bezlitosne, by pokazać innym, że gra nie jest warta świeczki. No i znowu wspomnę o regulacjach, im szybciej firmy wprowadzą »bezpieczniki « (znaki wodne czy zaszyte informacje w metadanych), tym lepiej dla każdego z nas. Google już to zapowiedziało u siebie. Czas na innych”.

Wojtek Kardyś, specjalista od komunikacji internetowej

Dziękujemy za lekturę serii artykułów poświęconej generatorom grafik! Jeżeli nie widziałeś poprzednich tekstów, to zapoznasz się z nimi tutaj oraz tutaj.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter