Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

Ten artykuł ma więcej niż 3 lata. Niektóre dane mogą być nieaktualne. Sprawdź, jak zmieniała się metodologia i artykuły w Demagogu.

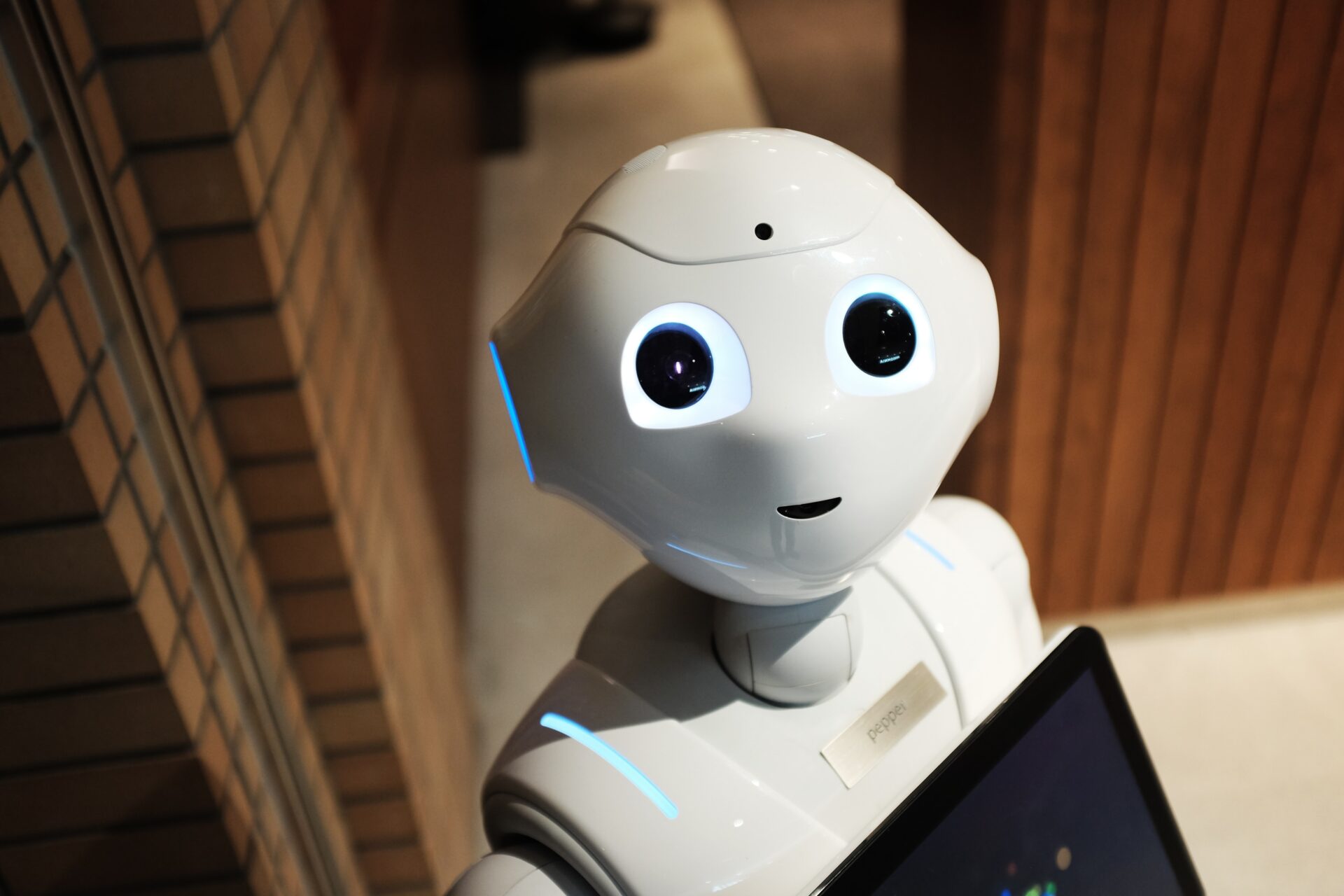

Wściekłe boty. W sieci czai się jeszcze mroczniejsze zagrożenie

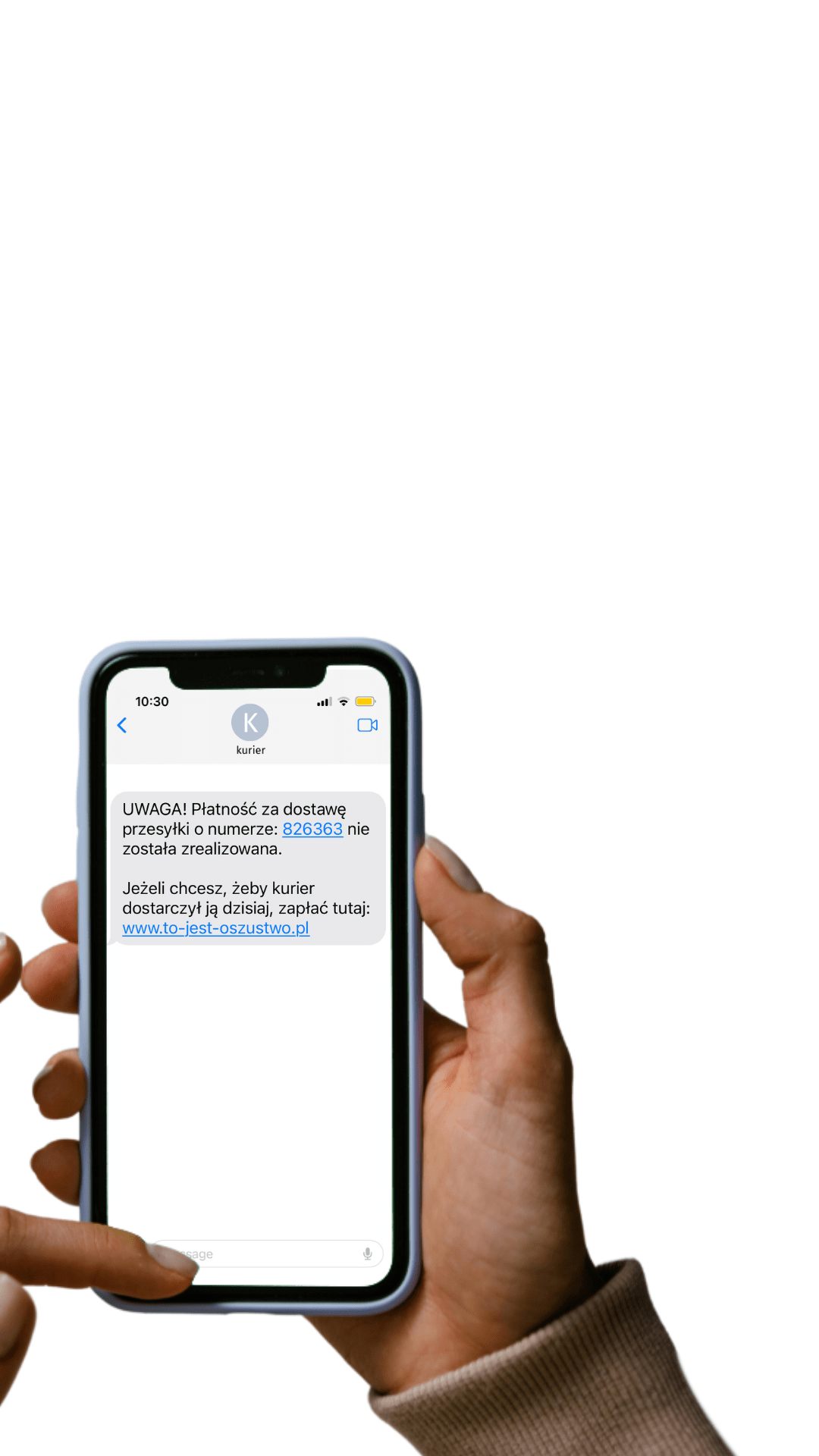

Na pewno słyszeliście o botach. Są jeszcze gorsze niż trolle, bo potrafią w sekundę wysłać tysiące celnie targetowanych wiadomości. Boty stały się jednym z symboli ciemnej strony internetu. Ale w sieci czai się jeszcze mroczniejsze zagrożenie. Media społecznościowe mają moc zmieniania w zdalnie sterowane boty nas, zwykłych śmiertelników. To nie scenariusz science-fiction, lecz wyniki badań naukowych nad obiegiem fałszywych informacji.

Internet zmienia nas w boty. Wystarczy wcisnąć prostą kombinację klawiszy w naszym mózgu, byśmy bezmyślnie podali dalej niemal dowolną wiadomość. Luka bezpieczeństwa umieszczona jest w niespodziewanym miejscu. Kluczem do zamiany nas w maszyny do retweetowania okazują się bowiem emocje, czyli coś, czego zwykle nie kojarzymy z botami.

Ten artykuł ma więcej niż 3 lata. Niektóre dane mogą być nieaktualne. Sprawdź, jak zmieniała się metodologia i artykuły w Demagogu.

Wściekłe boty. W sieci czai się jeszcze mroczniejsze zagrożenie

Wściekłe boty. W sieci czai się jeszcze mroczniejsze zagrożenie

Na pewno słyszeliście o botach. Są jeszcze gorsze niż trolle, bo potrafią w sekundę wysłać tysiące celnie targetowanych wiadomości. Boty stały się jednym z symboli ciemnej strony internetu. Ale w sieci czai się jeszcze mroczniejsze zagrożenie. Media społecznościowe mają moc zmieniania w zdalnie sterowane boty nas, zwykłych śmiertelników. To nie scenariusz science-fiction, lecz wyniki badań naukowych nad obiegiem fałszywych informacji.

Internet zmienia nas w boty. Wystarczy wcisnąć prostą kombinację klawiszy w naszym mózgu, byśmy bezmyślnie podali dalej niemal dowolną wiadomość. Luka bezpieczeństwa umieszczona jest w niespodziewanym miejscu. Kluczem do zamiany nas w maszyny do retweetowania okazują się bowiem emocje, czyli coś, czego zwykle nie kojarzymy z botami.

Wielowymiarowe emocje

Negatywne emocje najlepiej się sprzedają. Znacie to? W mediach społecznościowych wyłażą z nas bestie zainteresowane tylko tym, co najgorsze – krwią, przemocą, ewentualnie politycznym hejtem. Otóż okazuje się, że prawda o emocjach w internecie i ich wpływie na rozprzestrzenianie się fake newsów jest bardziej skomplikowana.

Skomplikowane są także same emocje. I nie chodzi tylko o to, że wciąż nie udało wam się rozpracować, co dokładnie czujecie wobec chłopaka z równoległej klasy, brukselki albo nowego serialu, który wszyscy tak gorąco polecali. Jesteśmy zdolni do odczuwania bardzo szerokiego spektrum emocji, a ich językowe określenia i kulturowe formy wyrazu nie zawsze oddają temu bogactwu sprawiedliwość.

Badacze zajmujący się emocjami pracują na dwóch głównych rodzajach skal. Niektóre z nich mają charakter kategorialny. Oznacza to, że dzielą emocje tak, jak klasyfikuje się rośliny, minerały albo znaczki pocztowe – czyli poprzez umieszczenie ich w oddzielnych przegródkach. Inne skale opisu emocji mają charakter wymiarowy, czyli na kilku osiach umieszczają różne wartości (zmienne), za pomocą których scharakteryzować możemy emocje.

Jedna z tego rodzaju skal okazała się ostatnio wyjątkowo przydatna w rozumieniu naszych działań w sieci. Emocje można na niej opisać jako (1) pozytywne lub negatywne, (2) związane z podporządkowaniem i poczuciem zagrożenia albo przeciwnie – z dominacją i uczuciem kontroli, oraz (3) związane z pobudzeniem lub apatią. I to właśnie ta trzecia oś, wbrew temu, co wcześniej sądziliśmy, okazuje się kluczowa, jeżeli chodzi o dystrybucję fake newsów.

Badania przeprowadzone przez zespół Jonaha Bergera (opisane później przystępnie w jego książce Efekt wiralowy) sugerują, że emocje związane z wysokim pobudzeniem sprzyjają udostępnianiu informacji, niezależnie od tego, czy ma ona charakter pozytywny czy negatywny. Takimi emocjami o wysokim pobudzeniu są pozytywne zachwyt (awe) i rozbawienie (amusement), neutralne podniecenie (excitement), a także negatywne niepokój (anxiety) i gniew (anger). Niskie szanse na retweet mają z kolei wiadomości nacechowane jedną z dwóch emocji o niskim pobudzeniu – zadowoleniem lub smutkiem.

Dla użytkowników oznacza to dwie wiadomości. Dobra jest taka, że nie jesteśmy skazani na zalew emocji negatywnych. Dobre wieści mogą się przebić w internecie, jeżeli tylko wiąże się z nimi silne pobudzenie (np. zachwyt). Zła wiadomość – w praktyce oznacza to, że musimy strzec się manipulacji dokonywanych za pomocą pięciu, a nie dwóch emocji. Dobre, optymistyczne informacje też mogą być manipulacją.

Polaryzacja

Drugim składnikiem tajemnego przepisu na zamianę nas w boty jest wrogość między dwoma obozami. Polaryzacja sprzyja mediom społecznościowym, napędzając im klikalność i zwiększając emocjonalne pobudzenie. Z kolei media społecznościowe sprzyjają polaryzacji, zamykając nas w bańkach, filtrując informacje i podrzucając nam treści, które zmaksymalizują naszą obecność w sieci. To niebezpieczne dodatnie sprzężenie zwrotne! W dodatku w sieci funkcjonują podmioty z premedytacją grające na podzielenie publiczności w myśl motta znanego dziś jako doktryna Breitbarta: „Jeżeli chcesz gruntownie przebudować społeczeństwo, musisz je najpierw rozbić.”

Emocjonalne pobudzenie i neoplemienna polaryzacja. Z ich połączonych mocy powstaje idealny fake news. Pokazują to doskonale analizy przeprowadzone przez Williama Brady’ego i jego współpracowników opublikowane na łamach prestiżowego „PNAS”.

Badacze przebadali najczęściej retweetowane wiadomości, próbując ustalić, czy istnieje „słownik” pojęć gwarantujących sukces w mediach społecznościowych. Okazało się, że owszem, lecz pod uwagę musimy wziąć nie jeden, lecz dwa przenikające się słowniki. Idealny przekaz viralowy powinien być po pierwsze uwikłany w trwający spór dobra ze złem (słownik moralny), po drugie zaś silnie nacechowany emocjonalnie. Komponent moralny oznacza tu właściwie polaryzację polityczną. Pojęcia z magicznego słownika istotnie zwiększały zasięg się wiadomości, lecz oddziaływanie to pozostawało skuteczne tylko wewnątrz sieci liberalnej lub konserwatywnej, a nie pomiędzy nimi.

Jak duży był efekt? Badacze szacują, że użycie pojedynczego słowa ze słownika moralno-emocjonalnego zwiększa zasięg wiadomości o 20%. Każdy, kto kiedykolwiek zajmował się marketingiem w sieci, próbując wycisnąć z przekazu choćby kilka procent więcej, wie, że to bardzo, bardzo dużo. Do tweeta wystarczy dodać „to oburzające” (dobry przykład języka moralno-emocjonalnego), by magicznie poszerzyć grono jego odbiorców.

Daje do myślenia, prawda?

Co możemy z tym zrobić?

Pierwszym krokiem jest uświadomienie sobie tego mechanizmu i przyjęcie do wiadomości, że my także jesteśmy na niego podatni. Każdy i każda z nas od czasu do czasu zmienia się w bota bezrefleksyjnie podającego nacechowane oburzeniem, silnie spolaryzowane wiadomości. Uzmysłowienie sobie tego jest nieprzyjemne. Jak zauważa David Carol z The New School for Social Research „Nie chcemy przyznać, że propaganda działa, bo to by wymagało przyznania się, że jesteśmy słabi”.

Kiedy już wiemy, jakie okoliczności sprzyjają wyłączeniu czujności, skuteczna taktyka przeciwdziałania nasuwa się sama. Wyciszenie i wycofanie. Skonfrontowani z wysoko pobudzającą, uwikłaną w społeczny podział informacją musimy po pierwsze, spróbować się uspokoić, po drugie – spojrzeć na świat z punktu widzenia „drugiej strony barykady”. Wtedy ocena rzetelności i prawdziwości informacji powinna być przynajmniej trochę łatwiejsza. Jeżeli nie mamy możliwości zweryfikowania informacji – lepiej nie podawać jej dalej. Nawet jeśli w pełni potwierdza nasze oburzenie. Zwłaszcza jeśli w pełni potwierdza nasze oburzenie.

Zrób krok wstecz, odetchnij. Wróć do posta za 5 minut. Zastanów się, czy nadal chcesz go podać dalej.

Ta recepta brzmi banalnie, ale chwilowo to najlepsze, co mamy. Kluczem do tego, żeby przestać być botem, jest zrozumienie emocjonalnej pułapki, jaką zastawia na nas internet. Boty kojarzą nam się z bezdusznością. Za stalowym pancerzem robota kryją się zwoje, które czynią go podmiotem doskonale racjonalnym. Tymczasem, wbrew tej intuicji, to właśnie wysoki poziom pobudzenia emocjonalnego i silne zaangażowanie w bieżący spór czynią nas botami, paraliżując nasze krytyczne odruchy.

Niestety, doskonale wiedzą o tym zarówno twórcy fake newsów, jak i właściciele mediów społecznościowych zarabiający na naszym zaangażowaniu.

Czego powinniśmy wymagać?

Nie powinniśmy jednak poprzestawać na braniu spraw we własne ręce. Taktyki doraźnego radzenia sobie z zalewem fake newsów nie wystarczą. Potrzebne nam także długofalowe strategie. A tutaj piłka jest po stronie botów. Tych prawdziwych – chłodno i bez emocji analizujących, co opłaca się najbardziej.

Nie powinniśmy żyć w świecie, w którym każdy produkt komputerowy traktuje nas jak rebelianci Gwiazdę Śmierci – starając się poznać i wykorzystać nasze słabe punkty. Zasługujemy na technologie, które, zamiast nas eksploatować, będą raczej kompensować nasze słabości i czynić nas lepszymi.

I tego właśnie powinniśmy się domagać. Przez lepszą legislację, ujawnianie i ograniczenie nadużyć, rzetelną edukację medialną, przez regulacje algorytmów, która uczyniłaby je bardziej transparentnymi i mniej nastawionymi na eksploatację naszych słabości.

To poważna sprawa. Może zabrzmi to nieco na wyrost, ale sądzę, że jest to wręcz sprawa kluczowa dla przetrwania naszego gatunku. Wystarczy zobaczyć, jaki wpływ ma dezinformacja w sieci na to, jak społeczeństwa (nie)radzą sobie z pandemią, kryzysem klimatycznym czy (znów sprzężenie zwrotne) regulacją nowych technologii. Dlatego pora włączyć w tej kwestii silne pobudzenie i wyraźną polaryzację. Jesteśmy wkurzeni i nie zamierzamy dłużej siedzieć cicho. Ludzie kontra boty. Przetrwamy my albo one.

Autor tekstu, Marcin Napiórkowski współtworzył naszą kampanię: „Nie bądź botem. Włącz myślenie!”. Razem z Kasią Gandor zastanawiał się, w jaki sposób możemy walczyć z fake newsami:

Do poczytania:

- Berger, Jonah. „Arousal increases social transmission of information.” Psychological science 22.7 (2011): 891-893.

- Berger, Jonah, Efekt wiralowy, wyd. polskie MT Biznes, 2021.

- Brady, William J., et al. „Emotion shapes the diffusion of moralized content in social networks.” Proceedings of the National Academy of Sciences 114.28 (2017): 7313-7318.

- Zhang, Xueying, and Shuhua Zhou. „Clicking health risk messages on social media: Moderated mediation paths through perceived threat, perceived efficacy, and fear arousal.” Health communication 34.11 (2019): 1359-1368.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter