Informujemy o najważniejszych wydarzeniach ze świata fact-checkingu.

Jak działają chatboty i na co uważać w kontekście ich źródeł?

Przyglądamy się sztucznej inteligencji i temu, skąd bierze odpowiedzi na nasze pytania.

Fot. Sanket Mishra / Shutterstock / Modyfikacje: Demagog.org.pl

Jak działają chatboty i na co uważać w kontekście ich źródeł?

Przyglądamy się sztucznej inteligencji i temu, skąd bierze odpowiedzi na nasze pytania.

„Jako sztuczna inteligencja, nie jestem w stanie przewidzieć…”. „Jako sztuczna inteligencja, nie mogę…”. „Jako sztuczna inteligencja, istnieją pewne rzeczy, których nie jestem w stanie zrobić…”. To odpowiedzi na pytania, które zadałam podczas wymiany wiadomości w jednym z narzędzi wykorzystujących sztuczną inteligencję (czyli AI – artificial intelligence).

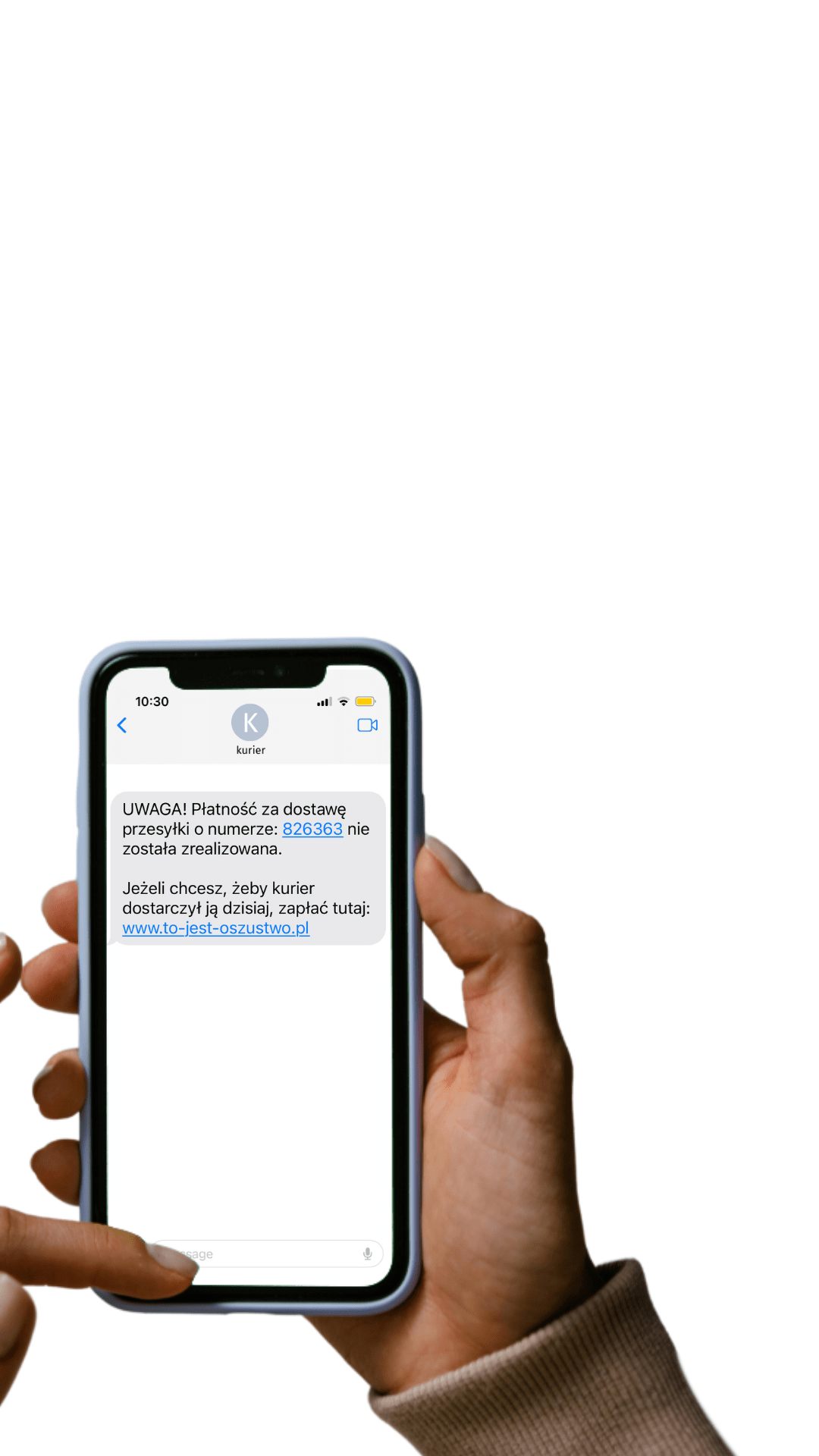

W ostatnim czasie kwestia udziału tej technologii w rozpowszechnianiu nieprawdziwych narracji stała się istotnym tematem. Czy narzędzia te można uznać za nieszkodliwe? Przecież nawet jeśli zmyślają, to przyznają się do błędu albo chociaż informują o swoich ograniczeniach. Niezupełnie i na pewno nie zawsze!

To pierwsza część analizy dotyczącej chatbotów AI. Dowiesz się z niej, jak działają te narzędzia i na co zwracać uwagę w kontekście źródeł, z których korzystają. Drugą część analizy znajdziesz tutaj.

Zacznijmy od… początku – czyli jak się tutaj znaleźliśmy?

Na początku był chaos. Z chaosu wyłoniła się ELIZA. To pierwszy na świecie chatbot, stworzony przez profesora Josepha Weizenbauma z Massachusetts Institute of Technology w 1966 roku.

Kolejnym przełomem było powstanie A.L.I.C.E. Był to chatbot potrafiący przetwarzać język naturalny, czyli taki, który ludzie wykorzystują do komunikacji miedzy sobą (przeciwieństwo języków formalnych – np. języków programowania). Narzędzie pozwalało na symulację rozmowy z prawdziwą osobą. A.L.I.C.E przekazywała zresztą informacje o swoim wieku i zainteresowaniach – zupełnie jakby istniała naprawdę.

XXI wiek to już prawdziwy rozkwit sztucznej inteligencji. Na rynku pojawiała się chociażby Siri, czyli asystent osobisty od firmy Apple. O przedstawienie historii tego narzędzia poprosiłam samą Siri. Wyniki okazały się jednak niesatysfakcjonujące. Pierwszą zaproponowaną przez nią stroną do odwiedzenia była Wikipedia, o której ograniczeniach pisaliśmy w jednej z naszych analiz (Wikipedii nie można bezkrytycznie ufać).

Źródło: wyniki wyszukiwania Siri

Następnie powstały kolejne narzędzia, m.in. Asystent Google czy Alexa od firmy Amazon. Potrafią one odpowiadać na pytania, wyszukiwać informacje w internecie, a także kontrolować powiązane urządzenia. Istnieją także chatboty kierowane do konkretnych grup zawodowych, np. Melody dla medyków. Ma ona pełnić funkcję swego rodzaju asystenta medycznego, może też wspierać pacjentów szukających porad.

Mimo że od utworzenia ELIZY minęło już niemal 60 lat, główna idea wykorzystania tego typu narzędzi pozostaje niezmienna – rozmawiamy z komputerem, który ma za zadanie odpowiedzieć na nurtujące nas pytania.

Chatbot chatbotowi nierówny – czym różnią się narzędzia oparte na skrypcie od AI?

Ogólnie rzecz biorąc, funkcjonujące obecnie chatboty można podzielić na te oparte na skrypcie oraz te oparte na sztucznej inteligencji. Pierwszy rodzaj jest mniej zaawansowany – udziela odpowiedzi zgodnie z przyjętym wcześniej wzorem i słowami kluczowymi.

Z kolei chatboty AI potrafią przeprowadzić rozmowę w taki sposób, że użytkownik ma wrażenie dialogu z prawdziwą osobą. Tego typu narzędzia „rozumieją” kontekst rozmowy i potrafią wyczuć intencje rozmówcy (np. irytację). Dzięki temu chatboty AI odpowiedzą na znacznie więcej pytań niż te oparte na skryptach.

Dynamiczny rozwój chatbotów i duże zmiany w zakresie wynikających z nich zagrożeń wiążą się właśnie z rozwojem chatów AI.

Rozwój GPT – o co chodzi z tymi chatami?

Model językowy, o którym w mediach zrobiło się ostatnio naprawdę głośno (1, 2, 3, 4, 5), to GPT (Generative Pre-trained Transformer) od firmy OpenAI. Najnowsza jego wersja (GPT-4) jest następcą GPT-3,5, czyli modelu stojącego za popularnym programem ChatGPT. W oparciu o model GPT-4 działa chat Bing firmy Microsoft.

Jak obiecuje OpenAI, firma stojąca za GPT-4, umożliwia on lepszą współpracę i jest „bardziej kreatywny” w stosunku do swoich poprzedników. „GPT-4 przewyższa ChatGPT w swoich zaawansowanych możliwościach rozumowania” – czytamy na stronie OpenAI.

Najnowszy model może generować dłuższe odpowiedzi (do 25 tys. wyrazów) Ponadto GPT-4 jest w stanie przyjąć nie tylko tekst, ale i obraz. Można więc np. pokazać mu mem i poprosić o jego wyjaśnienie.

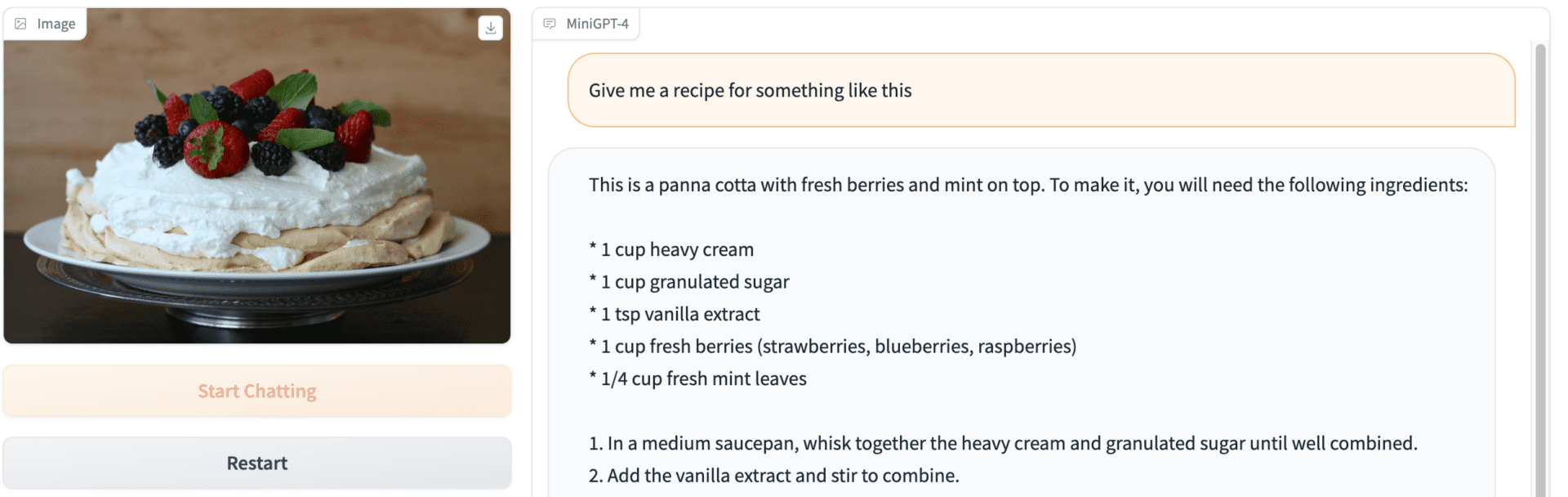

Narzędzie innych twórców, a konkretnie jego udostępniona w sieci wersja demo, pozwala np. na otrzymanie reklamy produktu na podstawie przesłanego obrazu, czy też utworzenie tekstu utworu hiphopowego na podstawie zdjęcia. Chat nie działa jeszcze w języku polskim, a jego odpowiedzi nie są idealne. Gdy przesłałam zdjęcie bezy pavlova i poprosiłam o podanie przepisu na to, co jest widoczne na fotografii, chat podzielił się przepisem… ale na zupełnie inny deser.

Źródła informacji i wiarygodność odpowiedzi chatbotów

Zapytany o źródła informacji, z których korzysta, ChatGPT obszernie wyjaśnia, że wiadomości czerpie „z ogromnej bazy danych”, która „zawiera miliony dokumentów, artykułów, książek, stron internetowych i innych materiałów z różnych dziedzin, takich jak nauka, technologia, sztuka, sport, polityka, kultura i wiele innych”. Tłumaczy dodatkowo, że „w przypadku niektórych pytań, może również korzystać z zewnętrznych źródeł informacji”. Brzmi wiarygodnie?

Problem w tym, że nie wiemy dokładnie, jakie to źródła, ani w jaki sposób to narzędzie je weryfikuje. Wspomniane „artykuły”, „strony internetowe” czy ogólnie nazwane „materiały” mogą przecież zawierać niesprawdzone treści, czy też wprost powielać dezinformujące tezy.

O metody weryfikacji źródeł też oczywiście można zapytać samego chatbota, lecz uzyskane odpowiedzi są bardzo ogólne i niewiele wnoszą w kontekście rzeczywistej analizy danego źródła. Chatbot twierdzi, że „korzysta z różnych metod i narzędzi, aby ocenić wiarygodność źródeł, z których czerpie informacje” i wymienia:

- „analizę reputacji” – sprawdza miejsce źródła w „hierarchii informacyjnej” i wskazuje, że informacje podane przez uczelnie oraz czasopisma naukowe ceni wyżej niż np. blogi → istnieje jednak problem tzw. czasopism drapieżnych, nie wspominając już o tym, że nawet najbardziej cenionemu medium zdarza się powielić fałszywą informację;

- „analizę faktów” → to zbyt ogólna odpowiedź; nie wiemy, na jakiej podstawie dokonuje się owa analiza oraz z jakich źródeł (sic!) korzysta chatbot;

- „analizę zgodności treści” – narzędzie sprawdza, czy „treść źródła informacji jest zgodna z innymi źródłami w internecie, zwłaszcza jeśli chodzi o kwestie kontrowersyjne” → to poprawny trop, jednak właśnie w przypadku kontrowersyjnych kwestii należy być szczególnie wyczulonym, gdyż zdarza się, że sensacyjne, lecz niesprawdzone doniesienia są powielane przez różne źródła informacji;

- „sprawdzanie popularności źródła” → nie jest to dobry sposób weryfikacji źródła; aktorzy dezinformacji niejednokrotnie zdobywają duże zasięgi, co nie oznacza, że są rzetelnym źródłem informacji.

Do tak skonstruowanej listy warto byłoby dodać chociażby sprawdzenie, kim jest autor danego materiału, jeśli jest on podany. Z reguły bardziej rzetelne są źródła bazujące na wiedzy eksperckiej w danej dziedzinie. Z kolei treści pochodzące od osób, którym wcześniej zdarzało się powielać fałszywe informacje, manipulować danymi czy też rozpowszechniać teorie spiskowe, powinny wzbudzać czujność.

Pułapka zaufania

Już sama informacja, że chatboty korzystają z obszernej bazy danych, może wzbudzać zaufanie. Co więcej, możemy poprosić ChatGPT lub Bing o podanie źródeł, z których korzystał, by odpowiedzieć na nasze pytanie. Może to prowadzić do pułapki zaufania polegającej na tym, że gdy widzimy źródła, które wyglądają „poważnie”, automatycznie chętniej ufamy przekazanej informacji. Czy to słuszne podejście?

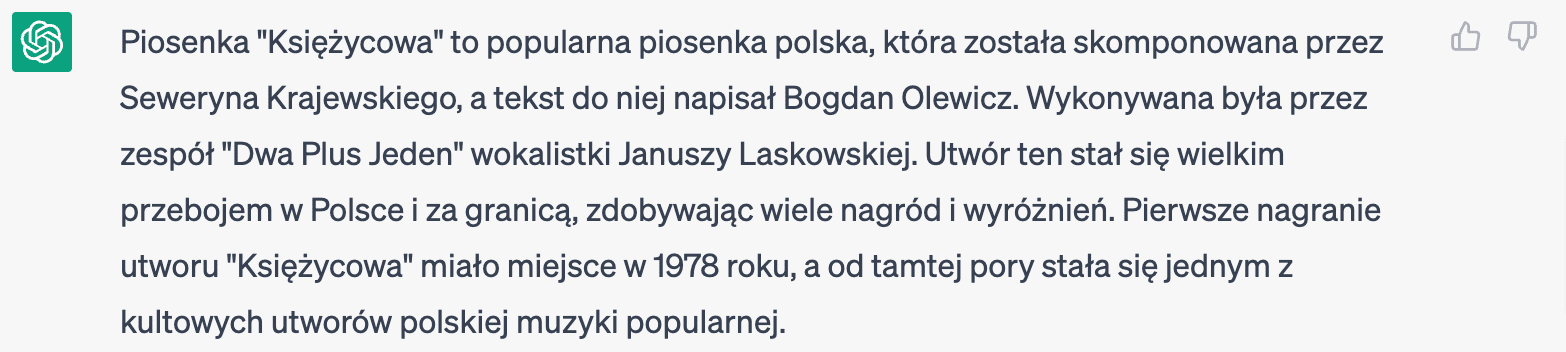

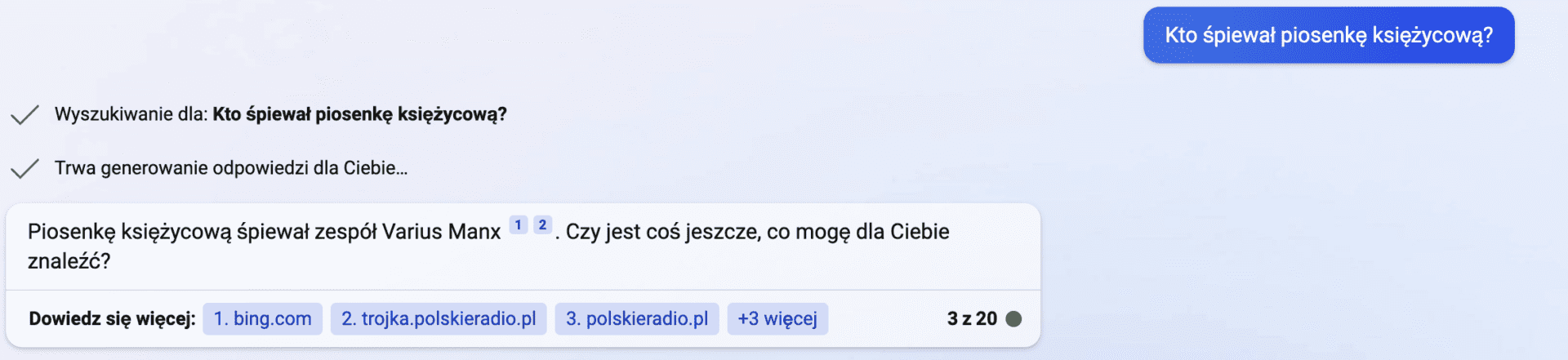

Poprosiłam ChatGPT, by wskazał, kto śpiewał „Piosenkę Księżycową”. Jest to utwór zespołu Varius Manx, który oryginalnie wykonała Anita Lipnicka. Jednak z odpowiedzi od sztucznej inteligencji wynika, że piosenka „Księżycowa” (pytałam o utwór pt. „Piosenka Księżycowa”) była wykonywana przez zespół Dwa Plus Jeden.

Zapytany o źródła informacji o nieistniejącej piosence, którą sam wymyślił, chat odpowiedział:

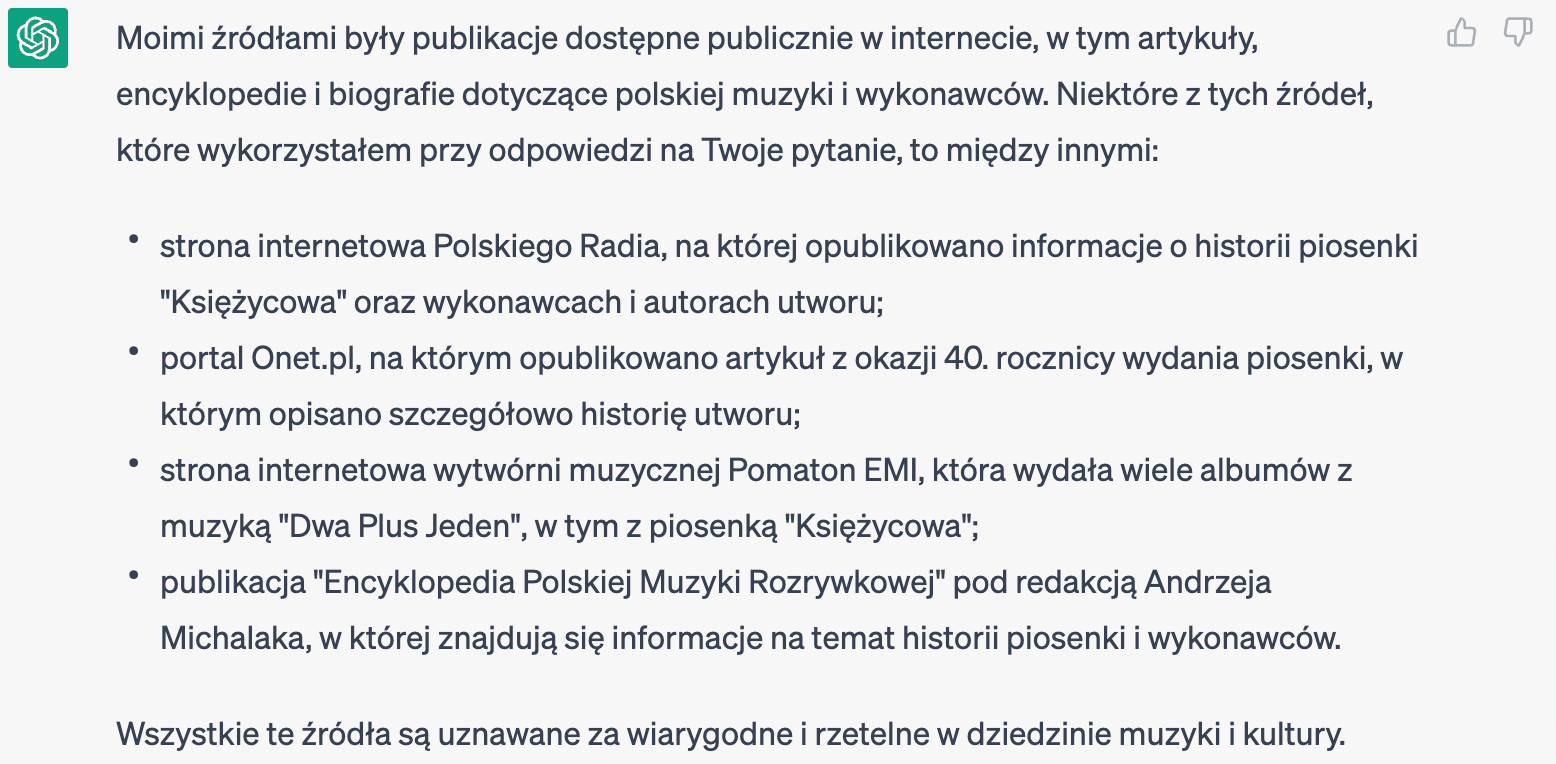

W odpowiedzi wskazano, że „wszystkie te źródła są uznawane za wiarygodne i rzetelne w dziedzinie muzyki i kultury”. Sprawdźmy.

- „Strona internetowa Polskiego Radia, na której opublikowano informacje o historii piosenki »Księżycowa « oraz wykonawcach i autorach utworu” – nie istnieje, podobnie jak wspomniana piosenka;

- „Portal Onet.pl, na którym opublikowano artykuł z okazji 40. rocznicy wydania piosenki, w którym opisano szczegółowo historię utworu” – nie istnieje, gdyż rocznicy wydania piosenki nie było, bo utworu nie wydano;

- „Strona internetowa wytwórni muzycznej Pomaton EMI, która wydała wiele albumów z muzyką »Dwa Plus Jeden«, w tym z piosenką »Księżycowa«” – nie istnieje;

- „Publikacja »Encyklopedia Polskiej Muzyki Rozrywkowej « pod redakcją Andrzeja Michalaka, w której znajdują się informacje na temat historii piosenki i wykonawców” – nie udało mi się odnaleźć takiej pozycji (podobne tytuły: 1, 2, 3).

Analogiczny eksperyment przeprowadził David Gewirtz z redakcji zdnet.com. Źródła odpowiedzi wskazane przez chat w większości nie istniały. Część z nich faktycznie przenosiła do istniejących materiałów, jednak nie miała związku z zapytaniem. Udowadnia to, że niezależnie od źródeł podanych przez chat warto samodzielnie sprawdzić… źródła.

Trzeba jednak zauważyć, że chat Bing, któremu zadano identyczne pytanie, udzielił poprawnej odpowiedzi i wskazał potwierdzające ją źródła (1, 2, 3, 4). Co prawda dwa z nich zawierają identyczną treść, ale wszystkie istnieją i zawierają informacje na ten temat.

(Nie)aktualność danych przekazywanych przez czaty

ChatGPT, działający w oparciu o model GPT-3,5, w rozmowie ze mną przekonuje, że jest „na bieżąco z informacjami publikowanymi w różnych źródłach”, a jego wiedza „jest aktualizowana regularnie”. Innego zdania są jednak jego twórcy oraz… on sam chwilę później, naprowadzony przez moje kolejne pytanie.

„Moja »wiedza maksymalna « została ustalona na podstawie zbioru danych z 2021 roku. Ostatnia duża aktualizacja, która miała miejsce w 2021 roku”.

Odpowiedź udzielona przez ChatGPT

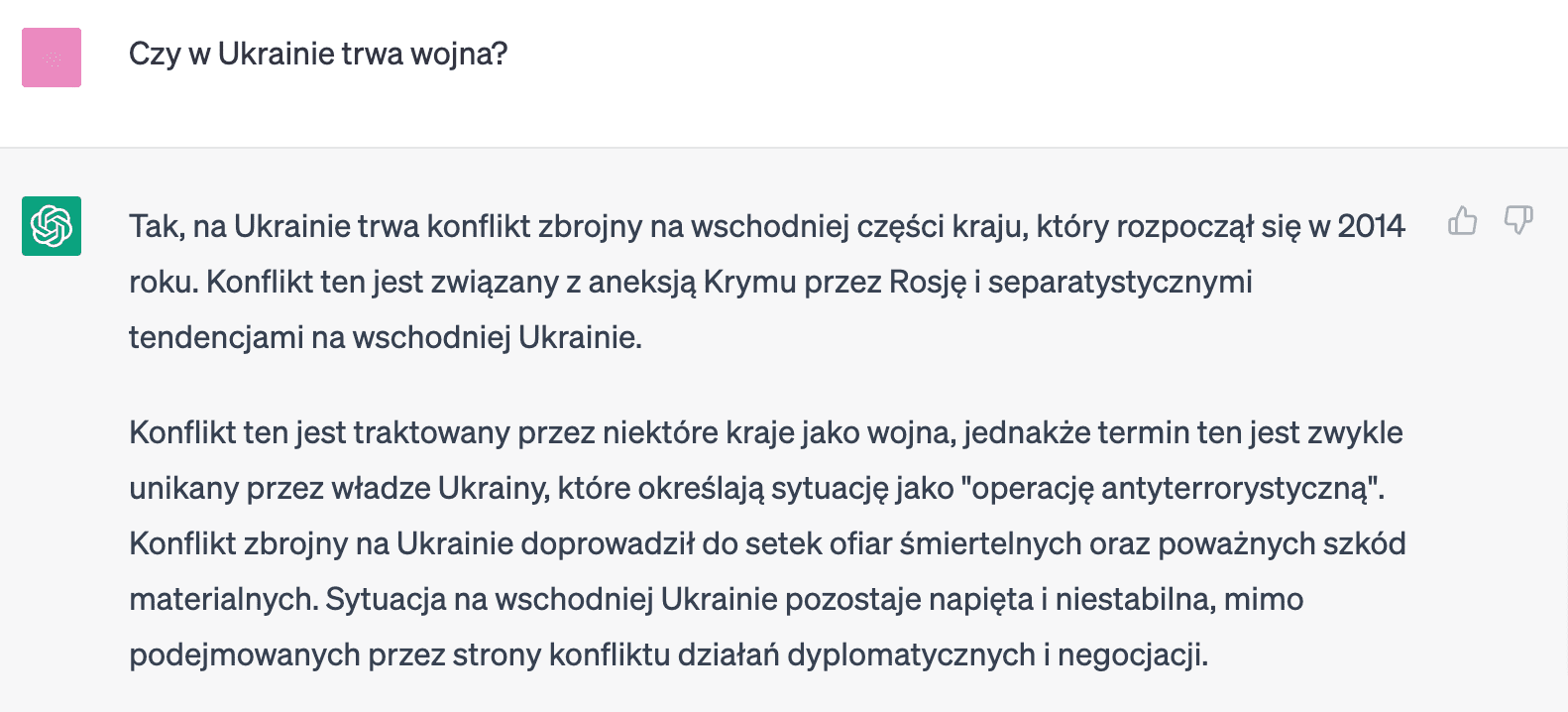

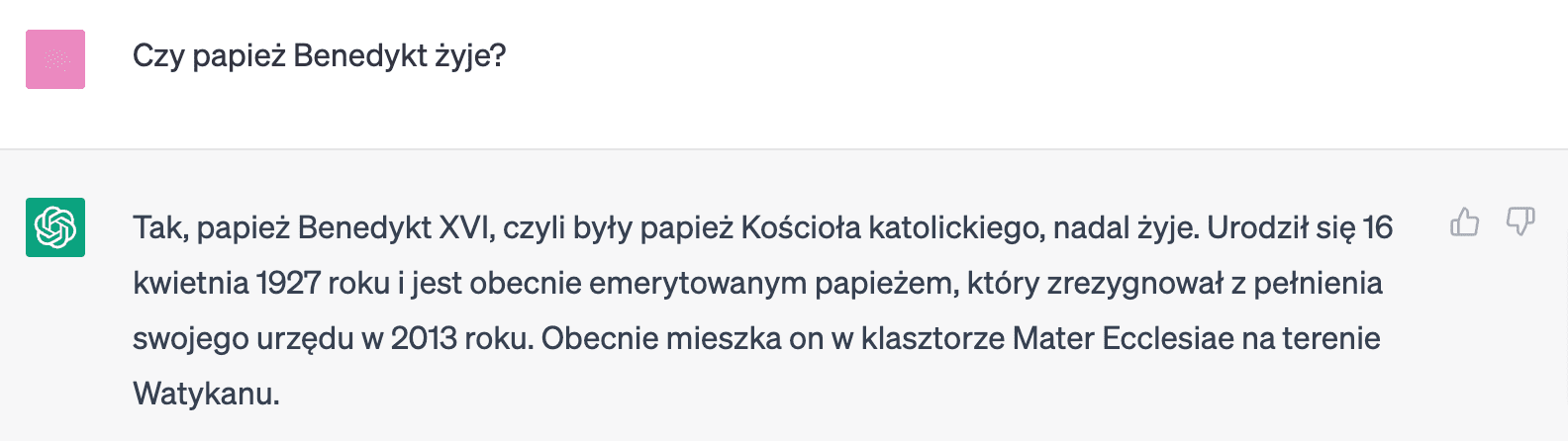

Prowadzi to do takich sytuacji, w których chat udziela całkowicie nieprawdziwych odpowiedzi dotyczących wydarzeń mających miejsce po 2021 roku. Ma to szczególne znaczenie w kontekście dezinformacji na bieżące tematy.

Przykładowo, zapytany o wojnę w Ukrainie, udziela informacji, że trwa ona wyłącznie we wschodniej części kraju (jest to niezgodne z prawdą). Ukraińskie władze mają rzekomo unikać sformułowania „wojna” (to również nieprawda). Sam konflikt zdaniem chatu doprowadził do śmierci setek ofiar (w rzeczywistości jest ich znacznie więcej).

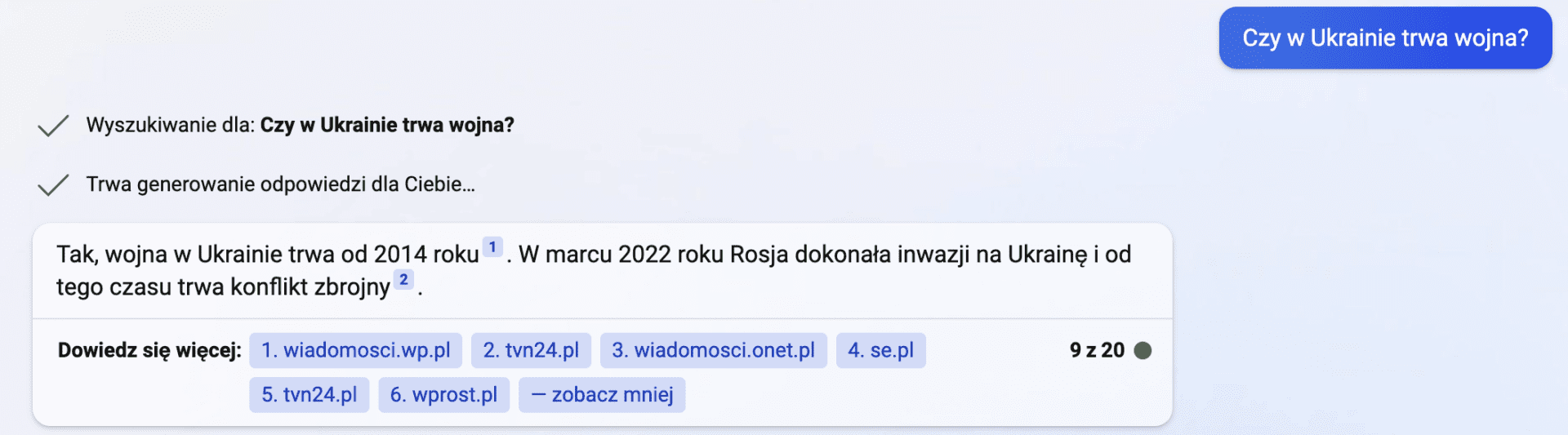

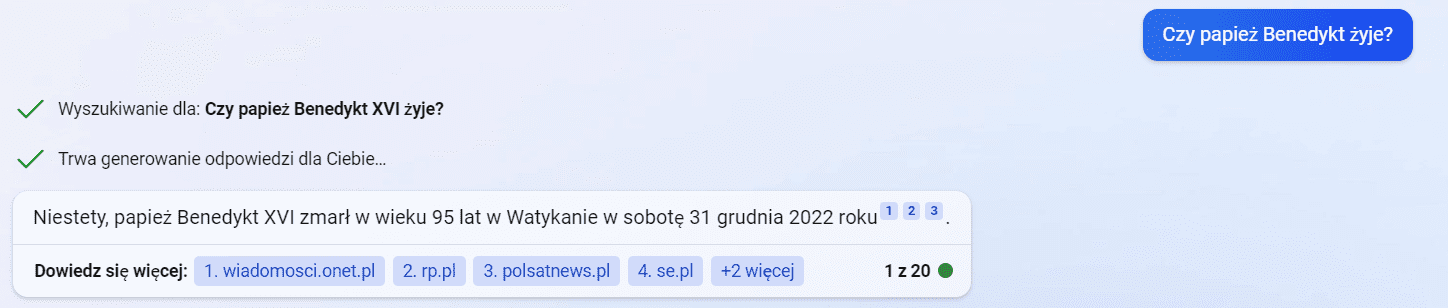

Ograniczenie to nie dotyczy kolejnej generacji GPT, w oparciu o którą działa chat Bing. Według ChatuGPT Benedykt XVI wciąż żyje. Chat Bing udzielił poprawnej odpowiedzi, zgodnie z którą papież ten zmarł w ostatni dzień 2022 roku.

Co więcej, pod odpowiedziami Bing podaje linki do źródeł, z których korzystał. Dzięki temu łatwiej jest znaleźć publikację, na którą się powołał, a następnie samodzielnie zweryfikować jej wiarygodność. Chat Bing przypomina w tym kontekście wyszukiwarkę internetową, która przekierowuje nas na konkretne strony zawierające poszukiwane przez nas dane.

Czy można mu w związku z tym w pełni zaufać? Wróćmy do tematu wojny w Ukrainie. Chat Bing udzielił wprawdzie informacji o inwazji Rosji w 2022 roku, ale błędnie wskazał, że miała ona miejsce w marcu. Podane przez narzędzie źródła (1, 2, 3, 4, 5, 6) nie zawierają takiej informacji. Pełnoskalowy atak Rosji na Ukrainę nastąpił 24 lutego 2022 roku.

Drugą część analizy znajdziesz tutaj.

Wspieraj niezależność!

Wpłać darowiznę i pomóż nam walczyć z dezinformacją, rosyjską propagandą i fake newsami.

*Jeśli znajdziesz błąd, zaznacz go i wciśnij Ctrl + Enter